Um grupo de cientistas brasileiros conseguiu gerar um entrelaçamento quântico de três feixes de luz de cores diferentes. O feito deverá ajudar a compreender as características desse fenômeno que é considerado pelos cientistas como a base para futuras tecnologias como computação quântica, criptografia quântica e teletransporte.

Fenômeno intrínseco da mecânica quântica, o entrelaçamento permite que duas ou mais partículas compartilhem suas propriedades mesmo sem a existência de qualquer ligação física entre elas e independentemente da distância que as separa -

veja Átomos assombrados de Einstein abrem caminho para computação quântica.A possibilidade de alternar o entrelaçamento quântico entre as diferentes frequências de luz poderá ser útil para a criação de protocolos avançados de troca de informações.

Entrelaçamento triploDe acordo com o autor principal do estudo, Paulo Nussenzveig, do Instituto de Física da USP, a possibilidade de gerar o entrelaçamento de três feixes de luz diferentes havia sido prevista pela mesma equipe há três anos, mas ainda não havia sido demonstrada experimentalmente. Dos três feixes, apenas um estava na porção visível do espectro e dois no infravermelho.

"Em 2005, medimos pela primeira vez o entrelaçamento em dois feixes, comprovando uma previsão teórica feita por outros grupos em 1988. A partir daí, percebemos que a informação presente no sistema era mais complexa do que imaginávamos e, em 2006, escrevemos um artigo teórico prevendo o entrelaçamento de três feixes, que conseguimos demonstrar agora", disse Nussenzveig à Agência FAPESP.

O cientista explica que, para realizar o estudo, o grupo utilizou um experimento conhecido como oscilador paramétrico óptico (OPO), que consiste em um cristal especial disposto entre dois espelhos, sobre o qual é bombeada uma fonte de luz.

"O que esse cristal tem de especial é sua resposta à luz, que é não-linear. Com isso, podemos introduzir no sistema uma luz verde e ter como resultado uma luz infravermelha, por exemplo", explicou. Segundo ele, os OPO com onda contínua, empregados no estudo, são utilizados desde a década de 1980.

Dissolução do elo quânticoEnfrentando diversas dificuldades e surpresas, ao lidar com fenômenos até então desconhecidos, os cientistas conseguiram "domar" o sistema para observar o entrelaçamento de três feixes com comprimentos de onda diferentes. Durante o experimento, descobriram ainda um efeito importante: a chamada morte súbita do entrelaçamento também ocorria no caso estudado.

Segundo Nussenzveig, um estudo coordenado por Luiz Davidovich, da Universidade Federal do Rio de Janeiro (UFRJ), publicado na Science em 2007, mostrou que o entrelaçamento quântico podia desaparecer repentinamente, "dissolvendo" o elo quântico entre as partículas - o que poderia comprometer a aplicação do fenômeno no futuro desenvolvimento de computadores quânticos.

O efeito, batizado como morte súbita do entrelaçamento, já havia sido previsto anteriormente por físicos teóricos e foi observado pela primeira vez pelo grupo da UFRJ em sistemas discretos - isto é, sistemas que têm um conjunto finito de resultados possíveis.

"Para sistemas macroscópicos de variáveis contínuas existem relativamente poucos trabalhos e previsões teóricas. E não existia absolutamente nenhum trabalho experimental. Observamos pela primeira vez algo que não havia sido previsto: a morte súbita em variáveis contínuas. Isso significa que trata-se de um efeito global coletivo", disse.

Além da física clássicaDe acordo com outro autor do estudo, Marcelo Martinelli, também professor do Instituto de Física da USP, o entrelaçamento quântico é a propriedade que distingue as situações quânticas das situações nas quais os eventos obedecem às leis da física clássica.

"Essa propriedade é verificada por meio de correlações que são diferentes das que ocorrem no mundo da física clássica. Quando jogamos uma moeda no chão, na física clássica, se temos a coroa voltada para cima, temos a cara voltada para baixo. No mundo quântico, esse resultado tem diferentes graus de liberdade e ângulos de correlação", explicou.

Teletransporte quânticoSegundo Martinelli, o entrelaçamento já havia sido muitas vezes verificado em sistemas discretos, ou entre dois ou mais sistemas no domínio de variáveis contínuas. Mas, quando havia três ou mais subsistemas, o entrelaçamento gerado era sempre de feixes de luz da mesma cor.

"Isso é interessante, porque abre caminho para que possamos, a partir de um sistema que interage com uma certa frequência do espectro eletromagnético, transferir suas propriedades quânticas para outro sistema - seria o chamado teletransporte quântico", disse o cientista.

De acordo com Martinelli, seria possível fazer isso utilizando feixes de entrelaçamento como veículo para transformar a informação. "Mas, se só pudermos lidar com variáveis da mesma cor, a informação quântica do primeiro só passaria para um segundo e um terceiro sistema se todos eles atuarem na mesma frequência. O nosso modelo permitiria fazer a transferência de informação quântica entre diferentes faixas do espectro eletromagnético", explicou.

Ao observar pela primeira vez a morte súbita de entrelaçamento em um sistema de variáveis contínuas, o grupo conseguiu novas informações sobre a natureza do fenômeno.

Morte súbita do entrelaçamentoMartinelli explica que todo sistema que interage com a natureza apresenta perdas, gradualmente. Uma chaleira em contato com o ambiente esfria continuamente até atingir o equilíbrio térmico com a temperatura externa. Mas esse processo se dá de forma exponencial e só estaria completo em um período de tempo infinito. Na prática, a chaleira sempre estará um pouco mais quente que o ambiente.

"No entanto, no caso do entrelaçamento, a sua interação com o ambiente nem sempre segue esse decaimento exponencial. Eventualmente ele desaparece em um tempo finito - o que caracteriza a chamada morte súbita. Vimos que isso também ocorre para variáveis contínuas e, ajustando os parâmetros de operação do nosso OPO, conseguimos controlar essa morte súbita", disse.

Segundo ele, essa descoberta é importante para que um dia se faça transporte de informação quântica. "Se enviarmos essa informação por fibra óptica, por exemplo, não podemos perder o entrelaçamento no sistema mediante perdas na propagação. Se a informação quântica passar a ter um papel central na tecnologia da informação, a compreensão da dinâmica da morte súbita e do entrelaçamento serão ainda mais fundamentais", disse.

Uma equipe da Faculdade de Engenharia Química (FEQ) da Unicamp desenvolveu a tecnologia de um novo processo de produção de bioquerosene a partir de óleos vegetais.

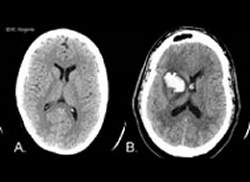

Uma equipe da Faculdade de Engenharia Química (FEQ) da Unicamp desenvolveu a tecnologia de um novo processo de produção de bioquerosene a partir de óleos vegetais. Um em cada oito casos de acidente vascular cerebral (AVC), também conhecido como derrame, é precedido "por um pequeno alerta", ou melhor, um ataque isquêmico transitório, segundo estudo publicado na revista Neurology, da Academia Norte-Americana de Neurologia.

Um em cada oito casos de acidente vascular cerebral (AVC), também conhecido como derrame, é precedido "por um pequeno alerta", ou melhor, um ataque isquêmico transitório, segundo estudo publicado na revista Neurology, da Academia Norte-Americana de Neurologia. A transmissão do HIV da mãe para o filho durante a gestação - chamada de transmissão vertical - e que pode ocorrer durante o trabalho de parto e por meio da amamentação, é responsável pela quase totalidade de casos de AIDS em crianças no Brasil.

A transmissão do HIV da mãe para o filho durante a gestação - chamada de transmissão vertical - e que pode ocorrer durante o trabalho de parto e por meio da amamentação, é responsável pela quase totalidade de casos de AIDS em crianças no Brasil.

Você vê uma pessoa na rua que lhe parece familiar, mas não consegue lembrar seu nome e nem de onde a conhece. Uma nova pesquisa feita da Universidade de Irvine (EUA) sugere que sua memória sobre essa pessoa está lá, em alguma parte do seu cérebro - você apenas não consegue acessá-la.

Você vê uma pessoa na rua que lhe parece familiar, mas não consegue lembrar seu nome e nem de onde a conhece. Uma nova pesquisa feita da Universidade de Irvine (EUA) sugere que sua memória sobre essa pessoa está lá, em alguma parte do seu cérebro - você apenas não consegue acessá-la.

Os engenheiros da Universidade de Bath, na Inglaterra, parecem decididos a construir um zoológico robótico.

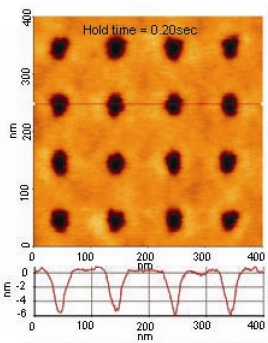

Os engenheiros da Universidade de Bath, na Inglaterra, parecem decididos a construir um zoológico robótico. Em 2002, a IBM apresentou uma tecnologia mecânica de memórias digitais que lembrava muito os antigos cartões perfurados do início da era da informática, onde os furos representavam os bits. Com a diferença que a nanotecnologia levou tudo para a escala dos nanômetros.

Em 2002, a IBM apresentou uma tecnologia mecânica de memórias digitais que lembrava muito os antigos cartões perfurados do início da era da informática, onde os furos representavam os bits. Com a diferença que a nanotecnologia levou tudo para a escala dos nanômetros. Pesquisadores da Universidade Johns Hopkins (EUA) descobriram que um exame dos movimentos dos olhos dos pacientes, feito na cama e com duração de um minuto, produz melhores resultados do que os caros e demorados exames de ressonância magnética para a detecção de derrames cerebrais e outros problemas vasculares.

Pesquisadores da Universidade Johns Hopkins (EUA) descobriram que um exame dos movimentos dos olhos dos pacientes, feito na cama e com duração de um minuto, produz melhores resultados do que os caros e demorados exames de ressonância magnética para a detecção de derrames cerebrais e outros problemas vasculares. A Microsoft liberou esta semana uma correção temporária para o problema no compartilhamento de arquivos que permite a invasão ou infecção remota do PC. Para se proteger é necessário usar o botão “Fix It”

A Microsoft liberou esta semana uma correção temporária para o problema no compartilhamento de arquivos que permite a invasão ou infecção remota do PC. Para se proteger é necessário usar o botão “Fix It”