Imagine poder escutar o som de um instrumento musical, executado através de uma projeção sonora, com a mesma qualidade obtida se o músico estivesse tocando ao seu lado, no mesmo ambiente.

Essa realidade já existe e foi desenvolvida pelo pesquisador Alexander Mattioli Pasqual, da Faculdade de Engenharia Mecânica da Unicamp.

Trata-se de um sistema de áudio para projeção tridimensional do som, um dispositivo esférico que difere dos alto-falantes convencionais porque possui uma distribuição espacial de energia sonora feita por doze pequenos alto-falantes, controlados de forma independente.

Assinatura espacialA aplicação mais imediata dessa nova tecnologia pode ser percebida quando se escuta um músico ao vivo e depois a sua gravação. Pasqual explicou que é possível perceber a diferença dos sons porque a distribuição de energia no espaço do instrumento musical é diferente da distribuição do alto-falante.

"Chamamos essa distribuição de energia de assinatura espacial. Com o novo dispositivo, conseguimos aproximar as assinaturas espaciais do instrumento e do alto-falante", assegurou o pesquisador.

Sob a orientação do professor José Roberto de França Arruda, Pasqual contou que a pesquisa foi desenvolvida em parceria com o Laboratório de Mecânica e Acústica do Centre National de La Recherche Scientifique (CNRS) de Marselha (França), referência mundial em acústica.

De acordo com o pesquisador, esse tipo de equipamento não existe no mercado e que, portanto, seu trabalho foi estudar as potencialidades do equipamento, quais os tipos de distribuição espacial que se consegue ou não reproduzir, as restrições em termos de bandas de frequência, projetos de equalizadores, técnicas de otimização e, também, as suas limitações.

Conexão de alto-falantesPara o pesquisador, do ponto de vista da engenharia, houve um avanço significativo nos estudos de acoplamento de alto-falantes. O normal em um sistema de som é ter vários alto-falantes operando em diferentes faixas de frequência e, portanto, o funcionamento de um não interfere no outro.

No caso do novo dispositivo, doze alto-falantes trabalham na mesma faixa de frequência e existe um acoplamento entre eles, ou seja, o som de um interfere no outro.

Foi necessário o desenvolvimento de modelos físicos e matemáticos para conseguir prever esse comportamento e poder projetar um dispositivo de forma mais eficiente. O protótipo agora apresentado avança significativamente em relação à primeira caixa acústica onidirecional, criada na USP há quase três anos.

"Desenvolvemos modelos eletromecânicos e eletroacústicos e avançamos bastante mostrando o que somos capazes de reproduzir em termos de distribuição espacial com arranjos esféricos. Propomos uma nova base vetorial para representar essa distribuição de energia sonora no espaço, gerada por uma fonte esférica. Isso impacta na nossa técnica de controle, que acaba sendo mais simples e eficiente do que tem sido desenvolvido em outros laboratórios," afirmou Pasqual.

Impressão 3DEm termos técnicos, trata-se de uma aproximação modal, chamada de modos de radiação acústica, desenvolvida especialmente para esse tipo de dispositivo esférico. "Após a realização de todos os cálculos para determinar esses modos de radiação acústica, com esse tipo de arranjo esférico de alto-falantes, usamos isso como base para representar a diretividade do som. E essa nova aproximação modal talvez seja a maior contribuição científica desse trabalho", revelou o pesquisador.

Utilizando uma técnica chamada de prototipagem virtual, a esfera de nylon foi fabricada a partir dos desenhos fornecidos pelos pesquisadores por uma equipe do Centro de Tecnologia da Informação Renato Archer (CTI) - órgão do Ministério da Ciência e Tecnologia, localizado em Campinas (SP).

Através de uma impressora 3D, as camadas de nylon vão sendo depositadas umas sobre as outras de acordo com a configuração do desenho. "A peça veio pronta, inclusive com toda a furação, sem que fosse necessário utilizar qualquer processo de usinagem", contou Pasqual.

Caixa de som esféricaO pesquisador afirmou que a decisão pelo formato esférico se deu por conta da simetria. O objetivo era reproduzir a diretividade sonora, que é o que descreve a característica espacial do som. A diretividade é a distribuição espacial de energia de uma fonte sonora.

"Queríamos reproduzir a diretividade no espaço tridimensional completo e a esfera é o formato mais simétrico que existe. A disposição dos alto-falantes, nesse caso, segue um dodecaedro que é um dos cinco sólidos de Platão. Queríamos ser capazes de fazer girar essa diretividade no espaço. Imagine, por exemplo, que eu coloquei mais energia numa direção do que na outra e quero girar essa direção em tempo real. Eu posso fazer isso com a esfera devido à simetria", explicou Pasqual.

Comparativamente a esse novo dispositivo, o pesquisador disse que os sistemas de som existentes no mercado atualmente, apesar de serem espaciais também, apresentam limitações.

Cinema em casaA tecnologia do "cinema em casa", que dispõe os alto-falantes em torno do ouvinte - técnica de projeção de fora para dentro - não permite posicionar uma fonte virtual em qualquer local do espaço e restringe a mobilidade do ouvinte a uma pequena área.

O objetivo dessa técnica leva o ouvinte a localizar onde está uma fonte sonora, criando sensações nele. Pasqual revela ainda que já existem técnicas mais modernas que tentam suplantar essas dificuldades, no entanto ainda não estão disponíveis comercialmente.

A técnica de projeção sonora realizada pelo novo dispositivo - de dentro para fora - possui a vantagem de não se preocupar com a acústica do ambiente onde ele está inserido. Sendo assim, há um aproveitamento maior da nova técnica, porque é uma aproximação diferente.

No entanto, ainda não há uma previsão para que esse novo dispositivo se torne comercial. "Ainda há muito trabalho pela frente. Essa é uma fonte de doze canais que precisa de um sistema dedicado para controlar os alto-falantes e isso não é tão simples quanto parece", garantiu Pasqual.

Música eletroacústicaExistem, de acordo com o pesquisador, outras aplicações interessantes desse dispositivo. Uma delas é para a música eletroacústica. Como o dispositivo permite controlar a distribuição de energia no espaço, ele pode ser utilizado também como instrumento musical.

O compositor pode utilizar, por exemplo, a rotação dos padrões de diretividade em tempo real. "Assim, ele pode utilizar isso como uma expressão a mais em sua composição, capaz de criar efeitos nos ouvintes e isso no palco é muito interessante", acrescentou.

Outra aplicação seria evitar microfonia em performances. Para isso, basta que o dispositivo também tenha um sensor de posição do microfone e, de acordo com o deslocamento no palco, criar um zero de pressão no microfone para que não haja microfonia.

"O dispositivo emite som para todas as direções, menos para onde está localizado o microfone no espaço", disse Pasqual. A princípio, o dispositivo serve apenas para reproduzir uma fonte pontual, no entanto, é possível pensar na utilização para um quarteto de cordas, por exemplo, onde cada instrumento teria uma fonte para reproduzir seu som.

Pesquisas em áudioO contato com a equipe do Laboratório de Mecânica e Acústica do CNRS de Marselha foi fundamental para o sucesso do trabalho, contou Pasqual. Como essa área de áudio não possui uma tradição, principalmente na área de engenharia mecânica, o pesquisador afirmou que foi muito importante procurar essa parceria com os pesquisadores franceses, que já possuem uma experiência muito grande no assunto.

"Tive um coorientador francês, professor Philippe Herzog, que é um especialista em alto-falantes, e todo o aparato experimental de que precisávamos para validar os modelos teóricos para esse transdutor foi disponibilizado pelo CNRS", disse.

Durante onze meses, Pasqual realizou desenvolvimentos teóricos e computacionais no CNRS e, numa segunda etapa, estagiou no laboratório francês por três meses para fazer a parte experimental.

"Os resultados foram satisfatórios e essa cooperação internacional foi muito importante para o meu aprendizado, não só científico quanto pessoal, porque pude conhecer vários laboratórios que desenvolvem fontes como essa," concluiu.

Pesquisadores australianos apresentaram o protótipo de um olho biônico que está pronto para ser implantado no primeiro paciente humano.

Pesquisadores australianos apresentaram o protótipo de um olho biônico que está pronto para ser implantado no primeiro paciente humano. Imagine poder escutar o som de um instrumento musical, executado através de uma projeção sonora, com a mesma qualidade obtida se o músico estivesse tocando ao seu lado, no mesmo ambiente.

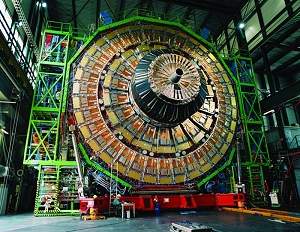

Imagine poder escutar o som de um instrumento musical, executado através de uma projeção sonora, com a mesma qualidade obtida se o músico estivesse tocando ao seu lado, no mesmo ambiente. Às 13h06 desta terça-feira (30/3), horário local, o acelerador de partículas LHC (Large Hadron Collider, ou "Grande Colisor de Hádrons"), localizado na fronteira da Suíça com a França, inaugurou seu programa de pesquisa ao provocar um choque de duas nuvens de prótons com energia total de 7 teraelétron-volts (TeV).

Às 13h06 desta terça-feira (30/3), horário local, o acelerador de partículas LHC (Large Hadron Collider, ou "Grande Colisor de Hádrons"), localizado na fronteira da Suíça com a França, inaugurou seu programa de pesquisa ao provocar um choque de duas nuvens de prótons com energia total de 7 teraelétron-volts (TeV). Algas marinhas podem se tornar uma importante alternativa contra a epidemia de obesidade.

Algas marinhas podem se tornar uma importante alternativa contra a epidemia de obesidade.