As teorias conspiratórias envolvendo os Illuminati são teorias da conspiração que afirmam que a "sociedade filosófica" alemã dos Illuminati da Baviera, historicamente dissolvida em 1785, têm persistido na clandestinidade e prosseguem com um plano secreto para dominar o mundo. Essas teorias, cuja primeira referência remonta as obras de John Robison e Augustin Barruel, são confundidas com as teorias conspiratórias maçônicas que alegam que os Illuminati realizaram seus planos de infiltração nos diferentes governos, particularmente naqueles a partir de revoluções, e outras sociedades secretas, incluindo a Maçonaria.

As teorias conspiratórias envolvendo os Illuminati são teorias da conspiração que afirmam que a "sociedade filosófica" alemã dos Illuminati da Baviera, historicamente dissolvida em 1785, têm persistido na clandestinidade e prosseguem com um plano secreto para dominar o mundo. Essas teorias, cuja primeira referência remonta as obras de John Robison e Augustin Barruel, são confundidas com as teorias conspiratórias maçônicas que alegam que os Illuminati realizaram seus planos de infiltração nos diferentes governos, particularmente naqueles a partir de revoluções, e outras sociedades secretas, incluindo a Maçonaria.Se os estudos históricos estimam que os Illuminati não sobreviveram para além do final do século XVIII, a denominação "Illuminati" é usada como um termo genérico no folclore das teorias da conspiração para sintetizar as teorias que identificam como conspiradores diversos grupos (maçons, judeus, sionistas, comunistas, várias sociedades secretas, organizações internacionais) e para designar, o sistema resultante, o núcleo dos "senhores do mundo".

História

A Ordem dos Illuminati era uma sociedade secreta Era do Iluminismo fundada em 1 de maio de 1776, em Ingolstadt (Baviera), por Adam Weishaupt, que foi o primeiro professor leigo de Direito Canónico na Universidade de Ingolstadt. O movimento consistiu de livres-pensadores, secularistas, liberais, republicanos e pró-feministas, recrutados nas lojas maçônicas da Alemanha, que visavam promover o perfeccionismo, através de escolas de mistério. Em 1785, a ordem foi infiltrada, quebrada e reprimida pelos agentes do governo de Carlos Teodoro, Eleitor da Baviera, em sua campanha para neutralizar a ameaça das sociedades secretas que nunca se tornam focos de conspirações para derrubar a monarquia da Baviera e da sua religião do Estado, o Catolicismo.

No final do século XVIII, os teóricos da conspiração reacionários, como o físico escocês John Robison e o sacerdote jesuíta francês Augustin Barruel, começaram a especular que os Illuminati sobreviveram à repressão e tornaram-se os cérebros por trás da Revolução Francesa e do Reino do Terror. Os Illuminati foram acusados de serem déspotas-esclarecidos que estavam tentando secretamente orquestrar uma revolução mundial, a fim de globalizar os ideais mais radicais do Iluminismo - o anti-clericalismo, a anti-monarquia e o anti-patriarcalismo. Durante o século XIX, o medo de uma conspiração dos Illuminati era uma preocupação real das classes dominantes europeias, e suas reações opressivas para este medo infundado provocou em 1848, as revoluções que muito procuravam impedir.

Durante o período entre-guerras do século XX, os propagandistas fascistas, como a historiadora revisionista britânica Nesta Webster e a socialite americana Edith Starr Miller, não só popularizaram o mito de uma conspiração dos Illuminati, mas alegaram que era uma sociedade secreta subversiva que servia as elites judaicas que supostamente apoiavam tanto o capitalismo financeiro e quanto o comunismo soviético para dividir e governar o mundo. O evangelista americano Gerald Burton Winrod e outros teóricos da conspiração dentro do movimento fundamentalista cristão nos Estados Unidos, que surgiram na década de 1910 como uma reação contra os princípios do Iluminismo, modernismo e liberalismo, tornaram-se o principal canal de divulgação de teorias da conspiração Illuminati. Os populistas de direita em seguida começaram a especular que algumas fraternidades colegiadas, os clubes de cavalheiros e as Usina de ideias da classe alta americana são organizações de fachada dos Illuminati, que acusam de conspirar para criar uma Nova Ordem Mundial através de um governo mundial.

Os céticos argumentam que as evidências sugerem que os Illuminati da Baviera não são nada mais do que uma nota curiosa histórica já que não há provas de que os Illuminati sobreviveram a sua supressão em 1785.

Supostos objetivos

Segundo as teorias, Weishaupt teria criado esta sociedade com o propósito de derrotar os governos e reinos do mundo e erradicar todas as religiões e crenças para governar as nações sob uma Nova Ordem Mundial, com base em um sistema internacionalista, criar uma moeda única e uma religião universal, onde de acordo com suas crenças, cada pessoa poderia atingir a perfeição.

No entanto, os propositos finais desta sociedade, eram conhecidos apenas por Weishaupt e seus seguidores mais próximos. Alguns autores, como Nesta Webster, e descrevem os seis objetivos de longo prazo dos Illuminati:

* Abolição da monarquia e todos os governos organizados sob o antigo regime.

* Abolição da propriedade privada dos meios de produção para os indivíduos e sociedades, com a consequente abolição das classes sociais.

* Abolição dos direitos de herança em qualquer caso.

* Destruição do conceito de patriotismo e nacionalismo e sua substituição por um governo mundial e de controle internacional.

* Abolição do conceito da família tradicional e clássica.

* Proibição de qualquer religião (especialmente a destruição da Igreja Católica Romana), estabelecendo um ateísmo oficial.

Outras atribuições ao nome Illuminati

Além dos "Illuminati Bavaros", muitas sociedades secretas de genero "ocultas" ou ligados a tradições esotéricas são por vezes associadas com o termo "Illuminati" porque são inspiradas por princípios semelhantes, tanto para a referência à descendência comum na identificação da "Luz", sinônimo de conhecimento (gnose) e a expansão da visão e do quadro perceptivo (ou clarividência).

Entre a Idade Média e a Idade Moderna vários grupos se auto-definem como "iluminados": os Irmãos do Livre Espírito, os Rosacruzes, os Alumbrados, os Illuminés, os Martinistas, o Palladium...

Uma vez que a partir do século XIX, especialmente no campo das teorias da conspiração, o termo "Illuminati" será geralmente associado com os seguidores de sociedades secretas de inspiração oculta e / ou globalista, independentemente do fato de eles serem realmente relacionados com a Ordem Illuminati: os Skull & Bones, Grupo Mesa Redonda, a Sociedade Fabiana, o Royal Institute of International Affairs, o Council on Foreign Relations, o Bohemian Club, o Clube de Bilderberg, a Comissão Trilateral, o Clube de Roma, a Fundação Carnegie, a Fundação Rockefeller, etc.

Principais teorias

Desde o final do século XVIII até meados do século XX, muitos teóricos de conspiração reacionários especulam que os Illuminati sobreviveram a sua supressão, por causa de sua suposta infiltração na Maçonaria, e se tornaram o cérebro por trás de grandes eventos históricos como a Revolução Americana, a Revolução Francesa, a Revolução Russa, as Guerras Mundiais e até os ataques de 11 de setembro de 2001; levando a cabo um plano secreto para subverter as monarquias da Europa e a religião Cristã visando a formação de uma Nova Ordem Mundial secular baseada na razão científica.

CONTINUE LENDO CLICANDO AQUI.

Até 1998, a questão de vírus em hardware era muito clara para especialistas. A maioria acreditava que não era possível que uma praga digital danificasse o computador fisicamente de qualquer forma. Naquele ano, porém, surgiu o vírus Chernobyl, também conhecido como CIH e Spacefiller. Usando uma falha no design de placas-mãe, ele conseguia apagar o chip da BIOS. Com isso, o computador não podia mais ser ligado.

Até 1998, a questão de vírus em hardware era muito clara para especialistas. A maioria acreditava que não era possível que uma praga digital danificasse o computador fisicamente de qualquer forma. Naquele ano, porém, surgiu o vírus Chernobyl, também conhecido como CIH e Spacefiller. Usando uma falha no design de placas-mãe, ele conseguia apagar o chip da BIOS. Com isso, o computador não podia mais ser ligado. Uma "palmilha inteligente" capaz de regular a temperatura dos pés já está em fase de conclusão na Escola Politécnica (Poli) da USP.

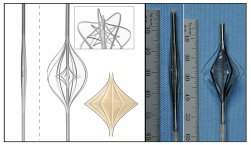

Uma "palmilha inteligente" capaz de regular a temperatura dos pés já está em fase de conclusão na Escola Politécnica (Poli) da USP. Ao descobrir a primeira estrela dupla, onde uma estrela variável pulsante, conhecida como cefeida, e outra estrela passam em frente uma da outra, uma equipe internacional de astrônomos desvendou um mistério de décadas.

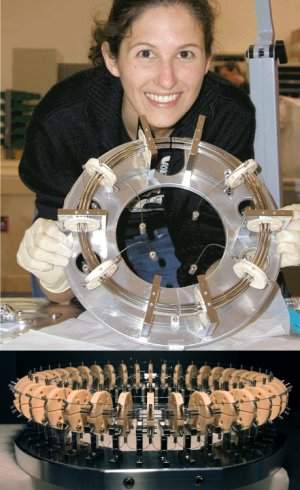

Ao descobrir a primeira estrela dupla, onde uma estrela variável pulsante, conhecida como cefeida, e outra estrela passam em frente uma da outra, uma equipe internacional de astrônomos desvendou um mistério de décadas. Quando um bebê nasce com circulação univentricular, uma doença cardíaca congênita, o único caminho é a cirurgia - na verdade, no mínimo três cirurgias.

Quando um bebê nasce com circulação univentricular, uma doença cardíaca congênita, o único caminho é a cirurgia - na verdade, no mínimo três cirurgias. Em uma pesquisa que está provocando um debate realmente irado entre os cientistas, um grupo de pesquisadores chegou à conclusão de que eventos que ainda não aconteceram podem influenciar nosso comportamento.

Em uma pesquisa que está provocando um debate realmente irado entre os cientistas, um grupo de pesquisadores chegou à conclusão de que eventos que ainda não aconteceram podem influenciar nosso comportamento. Físicos da Universidade de Bonn, na Alemanha, criaram uma forma totalmente nova de luz, algo que, até recentemente, era apontado pelos cientistas como sendo algo impossível de realizar.

Físicos da Universidade de Bonn, na Alemanha, criaram uma forma totalmente nova de luz, algo que, até recentemente, era apontado pelos cientistas como sendo algo impossível de realizar. Cientistas alemães descobriram que tecidos de fora do cérebro, contendo a proteína beta-amilóide, podem viajar pelo corpo e "infectar" o cérebro.

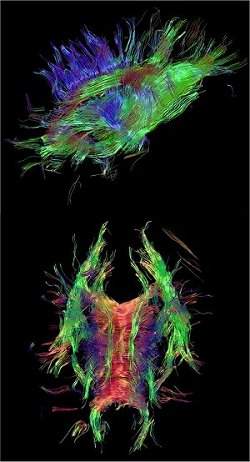

Cientistas alemães descobriram que tecidos de fora do cérebro, contendo a proteína beta-amilóide, podem viajar pelo corpo e "infectar" o cérebro. Uma equipe de pesquisadores da Universidade de Tecnologia de Eindhoven, na Holanda, desenvolveu um programa de computador que os médicos poderão usar para estudar as conexões do cérebro de seus pacientes.

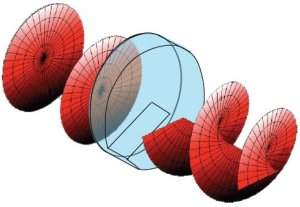

Uma equipe de pesquisadores da Universidade de Tecnologia de Eindhoven, na Holanda, desenvolveu um programa de computador que os médicos poderão usar para estudar as conexões do cérebro de seus pacientes. Torcer um feixe de luz em forma de parafuso é um feito recente, mas já realizado ao longo dos últimos anos.

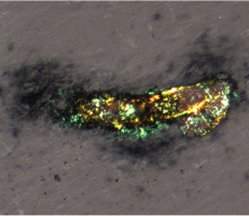

Torcer um feixe de luz em forma de parafuso é um feito recente, mas já realizado ao longo dos últimos anos. Não foi por acaso que o LHC e todos os outros aceleradores e colisores de partículas fizeram sua fama: eles se tornaram a principal ferramenta da física ao permitir o estudo detalhado das partículas eletricamente carregadas.

Não foi por acaso que o LHC e todos os outros aceleradores e colisores de partículas fizeram sua fama: eles se tornaram a principal ferramenta da física ao permitir o estudo detalhado das partículas eletricamente carregadas. Nos seriados de TV Águia de Fogo e Trovão Azul os helicópteros eram as verdadeiras estrelas e sempre brilharam mais do que os atores.

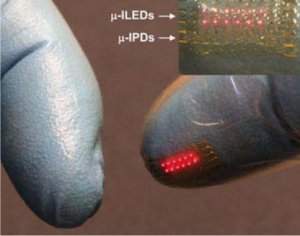

Nos seriados de TV Águia de Fogo e Trovão Azul os helicópteros eram as verdadeiras estrelas e sempre brilharam mais do que os atores. Em uma inovação que supera os conceitos de roupas inteligentes e "computadores de vestir", um grupo internacional de cientistas está desenvolvendo circuitos eletrônicos não para serem usados como roupas, mas para serem implantados sob a pele.

Em uma inovação que supera os conceitos de roupas inteligentes e "computadores de vestir", um grupo internacional de cientistas está desenvolvendo circuitos eletrônicos não para serem usados como roupas, mas para serem implantados sob a pele. Nos primeiros passos daquilo que poderá ser um avanço histórico na ciência, especialistas de todo o mundo estão se empenhando em um esforço para a criação de um novo Sistema Internacional de Unidades (SI).

Nos primeiros passos daquilo que poderá ser um avanço histórico na ciência, especialistas de todo o mundo estão se empenhando em um esforço para a criação de um novo Sistema Internacional de Unidades (SI).