Quando o satélite espacial Glória (Glory) subir ao espaço nesta semana, ele estará levando consigo uma pastilha de silício onde está gravado o nome do Site Inovação Tecnológica - www.inovacaotecnologica.com.br.

A iniciativa é parte do programa de divulgação científica da NASA, cujo principal objetivo é engajar estudantes e o público em geral nas missões espaciais, fomentando o interesse pelos aspectos científicos das missões e despertando o interesse pela ciência em geral.

É a primeira vez que um site brasileiro participa do programa.

A inscrição brasileira foi submetida assim que o satélite Glória foi incluído no programa de divulgação científica, em Setembro de 2008, tendo sido aceita em 04 de Dezembro de 2009.

O Site Inovação Tecnológica é o maior site de divulgação científica em língua portuguesa, no ar há quase 12 anos e reconhecido por meio de links de centenas de instituições de ensino do Brasil e do exterior, incluindo todas as principais universidades brasileiras.

O material divulgado pelo Site Inovação Tecnológica já foi tema de oito vestibulares e está presente em 54 livros didáticos editados para uso nas escolas brasileiras neste ano de 2011 - foram mais de duas centenas de livros didáticos desde que o site entrou no ar.

Satélite Glória

A principal missão do satélite Glória é estudar o sistema climático da Terra, desvendado o papel representado pelos aerossóis presentes na atmosfera e mensurando a influência da radiação solar sobre o clima.

O satélite possui dois instrumentos científicos principais.

O primeiro é um detector de aerossóis, chamado APS (Aerosol Polarimetry Sensor), que irá detectar informações sobre essas micropartículas, incluindo formato, composição e capacidade de reflexão da luz.

O segundo instrumento é um medidor da luz solar, chamado TIM (Total Irradiance Monitor), que irá monitorar as variações na atividade solar detectando a quantidade de energia que chega à camada superior da atmosfera da Terra.

O satélite Glória vai se juntar a uma frota de satélites de monitoramento ambiental, chamada A-Train, formada por sete satélites, cada um dos quais voltado a um aspecto específico da climatologia.

A duração prevista da missão científica do satélite Glória é de 30 anos.

segunda-feira, 28 de fevereiro de 2011

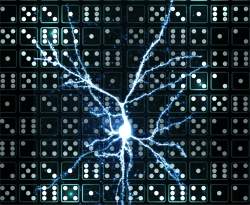

Memory scraping burla criptografia e já é uma das principais ameaças de 2011

O que vem a ser “pervasive memory scrapping” e por que essa tecnologia é considerada pelo Instituto SANS como sendo um dos ataques a sistemas mais perigosos de 2011?

Vamos simplificar.

“Essa técnica é aplicada por hackers para garantir acesso privilegiado (de administrador de sistemas) e obter informações de identificação pessoal e outra miríade de dados confidenciais”, explica Ed Skoudis, consultor sênior da empresa InGuardians e instrutor em eventos da SANS. De acordo com Skoudis, a todo momento surgem evidências sobre o emprego de tais ataques.

“Os dados são criptografados onde ficam armazenados”, explica Skoudis. Junto de Johannes Ulrich, pesquisador-chefe do instituto SANS, Skoudis apresentou o relatório em que afirma o número de ataques à sistemas criptografados estar aumentando.

“Apesar de criptografadas, assim que as informações são processadas elas ficam vulneráveis”, alerta o executivo.

A criptografia é, sem dúvida, uma boa ideia para armazenar dados confidenciais. Em certas ocasiões, pode até ser requerida por políticas e regulamentações. O que os hackers fazem no momento, é explorar as brechas na trama da criptografia para furtar informações valiosas.

“Eles (os hackers) se aproveitam do momento em que os dados são decodificados, invadem a memória e capturam as informações pessoais”, diz Skoudis. “Interessante nesse caso”, continua o executivo, “é que os hackers fazem questão de deixar o sistema intacto e não decodificam os dados no ambiente da solução”.

Raspas e restos

A técnica não é exatamente nova. Há dois anos, o relatório de vazamento de dados da Verizon identificou uma técnica a qual batizou de RAM scraping (literalmente, "raspagem da memória RAM"), usada para comprometer redes de setores financeiros e de saúde. Segundo a Verizon, o RAM scraping consiste “em uma tecnologia relativamente nova, desenvolvida para capturar dados de memória volátil em sistemas".

Entre as ferramentas usadas pelos hackers para viabilizar o furto de dados estão um módulo de software denominado Metasploit Meterpreter, que roda dentro do framework para open source Metasploit.

De acordo com Skoudis, o pesquisador Colin Ames foi o pioneiro na demonstração de como tal técnica é viável.

Para dar conta da proteção dos sistemas contra tais ataques, é sugerido o uso de soluções de prevenção contra perda de dados (data loss prevention, ou DLP). Essas soluções (algumas delas gratuitas) podem auxiliar na detecção de vazamento de dados confidenciais. Ainda assim, não bastam para parar totalmente os ataques do tipo memory scraping , pois “os bandidos atuam dentro de uma ambiente criptografado, onde são invisíveis”, completa Skoudis.

IPv6, iPhones & iPads

Foram identificados outros tipos de ataques. Alguns deles se aproveitarão da migração entre as versões do protocolo IP da atual versão 4 para a 6. Possivelmente, os hackers irão se infiltrar em redes IPv6 que funcionam sem as TIs de algumas empresas saberem disso.

É plausível, ainda, que os firewalls para as redes IPv6 não estejam preparados para barrar acessos estranhos.

“iPads e iPhones são exemplos de dispositivos que já funcionam à base de IPv6”, diz Ulrich, que chama atenção para o fato de haver uma carência por ferramentas para monitoramento. Segundo Ulrich, o “IPv6 pode funcionar igual a uma rede escondida, imperceptível aos olhos dos provedores de acesso”. Ele adverte que quem não precisar usar a versão 6 do protocolo IP deve desligar tal função diretamente nos roteadores.

Vamos simplificar.

“Essa técnica é aplicada por hackers para garantir acesso privilegiado (de administrador de sistemas) e obter informações de identificação pessoal e outra miríade de dados confidenciais”, explica Ed Skoudis, consultor sênior da empresa InGuardians e instrutor em eventos da SANS. De acordo com Skoudis, a todo momento surgem evidências sobre o emprego de tais ataques.

“Os dados são criptografados onde ficam armazenados”, explica Skoudis. Junto de Johannes Ulrich, pesquisador-chefe do instituto SANS, Skoudis apresentou o relatório em que afirma o número de ataques à sistemas criptografados estar aumentando.

“Apesar de criptografadas, assim que as informações são processadas elas ficam vulneráveis”, alerta o executivo.

A criptografia é, sem dúvida, uma boa ideia para armazenar dados confidenciais. Em certas ocasiões, pode até ser requerida por políticas e regulamentações. O que os hackers fazem no momento, é explorar as brechas na trama da criptografia para furtar informações valiosas.

“Eles (os hackers) se aproveitam do momento em que os dados são decodificados, invadem a memória e capturam as informações pessoais”, diz Skoudis. “Interessante nesse caso”, continua o executivo, “é que os hackers fazem questão de deixar o sistema intacto e não decodificam os dados no ambiente da solução”.

Raspas e restos

A técnica não é exatamente nova. Há dois anos, o relatório de vazamento de dados da Verizon identificou uma técnica a qual batizou de RAM scraping (literalmente, "raspagem da memória RAM"), usada para comprometer redes de setores financeiros e de saúde. Segundo a Verizon, o RAM scraping consiste “em uma tecnologia relativamente nova, desenvolvida para capturar dados de memória volátil em sistemas".

Entre as ferramentas usadas pelos hackers para viabilizar o furto de dados estão um módulo de software denominado Metasploit Meterpreter, que roda dentro do framework para open source Metasploit.

De acordo com Skoudis, o pesquisador Colin Ames foi o pioneiro na demonstração de como tal técnica é viável.

Para dar conta da proteção dos sistemas contra tais ataques, é sugerido o uso de soluções de prevenção contra perda de dados (data loss prevention, ou DLP). Essas soluções (algumas delas gratuitas) podem auxiliar na detecção de vazamento de dados confidenciais. Ainda assim, não bastam para parar totalmente os ataques do tipo memory scraping , pois “os bandidos atuam dentro de uma ambiente criptografado, onde são invisíveis”, completa Skoudis.

IPv6, iPhones & iPads

Foram identificados outros tipos de ataques. Alguns deles se aproveitarão da migração entre as versões do protocolo IP da atual versão 4 para a 6. Possivelmente, os hackers irão se infiltrar em redes IPv6 que funcionam sem as TIs de algumas empresas saberem disso.

É plausível, ainda, que os firewalls para as redes IPv6 não estejam preparados para barrar acessos estranhos.

“iPads e iPhones são exemplos de dispositivos que já funcionam à base de IPv6”, diz Ulrich, que chama atenção para o fato de haver uma carência por ferramentas para monitoramento. Segundo Ulrich, o “IPv6 pode funcionar igual a uma rede escondida, imperceptível aos olhos dos provedores de acesso”. Ele adverte que quem não precisar usar a versão 6 do protocolo IP deve desligar tal função diretamente nos roteadores.

Fonte: IDG Now!

Redes Wi-Fi de hotéis e aeroportos são prato cheio para cibercriminosos

As conexões Wi-fi que muitos hotéis e aeroportos oferecem aos clientes, de comodidade podem virar uma ameaça. O motivo é que, em geral, as informações que transitam por tais redes não são criptografadas, de modo que, se criminosos virtuais as interceptarem, os usuários podem ser seriamente prejudicados.

Segundo Dmitry Bestuzhev, diretor da equipe de analistas da Kasperky Lab – empresa de segurança digital – a falta de proteção facilita a tarefa de hackers mal intencionados. Com um simples ataque de man-in-the-middle – termo que designa golpes em que o criminoso fica no meio de uma conexão entre dois computadores – eles conseguem roubar qualquer dado enviado por essas redes, como logins e senhas ou números de cartões de crédito.

O especialista sugere duas soluções para o problema. A primeira consiste em usar apenas conexões VPN (Virtual Private Network). No entanto, grande parte dos administradores de hotspots bloqueia tal função, para impedir que a rede seja usada para fins maliciosos.

A segunda opção é mais trabalhosa, mas livre de obstáculos. O internauta deverá digitar https:// antes do endereço do portal que quiser visitar – dessa forma, ativará a conexão segura SSL. A seguir, terá que esperar a página ser carregada e clicar no cadeado que aparecerá no canto direito ou esquerdo da barra de endereços. Assim, o certificado de segurança do site será exibido; se alguma informação estiver errada ou for incoerente, o melhor é que o usuário interrompa sua navegação e, principalmente, não digite nenhuma senha enquanto estiver conectado.

Vale lembrar que a alternativa mais segura é acessar a Internet via rede Ethernet, disponível em alguns lounges de aeroportos. Em último caso, se o internauta precisar usar o Wi-fi, mas não tiver garantias quanto à segurança, recomenda-se que não faça pagamentos ou entre em internet banking, já que esses são os dados mais visados pelo cibercriminosos.

Segundo Dmitry Bestuzhev, diretor da equipe de analistas da Kasperky Lab – empresa de segurança digital – a falta de proteção facilita a tarefa de hackers mal intencionados. Com um simples ataque de man-in-the-middle – termo que designa golpes em que o criminoso fica no meio de uma conexão entre dois computadores – eles conseguem roubar qualquer dado enviado por essas redes, como logins e senhas ou números de cartões de crédito.

O especialista sugere duas soluções para o problema. A primeira consiste em usar apenas conexões VPN (Virtual Private Network). No entanto, grande parte dos administradores de hotspots bloqueia tal função, para impedir que a rede seja usada para fins maliciosos.

A segunda opção é mais trabalhosa, mas livre de obstáculos. O internauta deverá digitar https:// antes do endereço do portal que quiser visitar – dessa forma, ativará a conexão segura SSL. A seguir, terá que esperar a página ser carregada e clicar no cadeado que aparecerá no canto direito ou esquerdo da barra de endereços. Assim, o certificado de segurança do site será exibido; se alguma informação estiver errada ou for incoerente, o melhor é que o usuário interrompa sua navegação e, principalmente, não digite nenhuma senha enquanto estiver conectado.

Vale lembrar que a alternativa mais segura é acessar a Internet via rede Ethernet, disponível em alguns lounges de aeroportos. Em último caso, se o internauta precisar usar o Wi-fi, mas não tiver garantias quanto à segurança, recomenda-se que não faça pagamentos ou entre em internet banking, já que esses são os dados mais visados pelo cibercriminosos.

Fonte: IDG Now!

Robôs fazem ciência: Desvendando as proteínas

O Brasil tem todas as condições para contribuir com os avanços tecnológicos no campo da automação.

Esses avanços estão revolucionando as pesquisas para a descoberta de novos fármacos a partir da síntese de novas moléculas, de acordo com Otávio Thiemann, do Instituto de Física de São Carlos (IFSC) da Universidade de São Paulo (USP).

Thiemann participou nesta quinta-feira, em São Paulo, do Simpósio sobre Biologia Sintética e Robótica, que teve o objetivo de divulgar a nova área multidisciplinar que envolve a automação e a sintetização de biocompostos.

O evento, organizado pela FAPESP e pelo Consulado Britânico em São Paulo, integra a Parceria Brasil-Reino Unido em Ciência e Inovação.

Cristalografia de proteínas

Durante o evento, o pesquisador fez uma avaliação dos avanços e perspectivas das aplicações da robótica à cristalografia de proteínas - uma técnica que permite "enxergar" as moléculas de proteína em nível atômico.

As estruturas das moléculas, entretanto, não podem ser propriamente vistas, porque sua escala é menor do que o comprimento de onda da luz visível.

Por conta disso, os cientistas utilizam raios X de alta energia, produzidos por linhas de luz síncrotron, que permitem distinguir distâncias atômicas da ordem de poucos ângstrons.

* Processo genético chave é visto em resolução atômica

Thiemann utiliza a técnica para elucidar a estrutura molecular e a função de proteínas-alvo na fisiologia de parasitas como as Leishmanias e os Trypanosomas, avaliando o potencial dessas moléculas para o desenvolvimento de novas drogas.

"Várias etapas do processo de cristalografia de proteínas já foram automatizados, mas ainda há gargalos em algumas delas. As tecnologias de automação, no entanto, estão avançando muito rapidamente e deverão tornar o ciclo inteiro muito mais ágil", disse Thiemann.

Conforme avança a robotização de determinadas fases do processo, segundo o pesquisador, a ciência avança na direção de cristalizar um grande número de proteínas simultaneamente, em vez de estudar a estrutura de cada uma delas separadamente. "Isso vai encurtar enormemente o caminho para a descoberta e melhoria de drogas", explicou.

Ciência robotizada

De acordo com o cientista, o processo para se chegar a cristalizar as moléculas - desvendando sua estrutura, sua dinâmica e sua atividade - não é trivial. Suas diversas etapas, porém, podem ser diferenciadas em dois universos diferentes: o da produção da proteína e o da cristalização propriamente dita.

"Na produção da proteína, embora a automação ainda não esteja tão bem estabelecida, já há vários robôs que podem ajudar em várias etapas do processo. Mas é ao fim da parte da cristalização que temos alguns gargalos fundamentais, cuja superação deverá revolucionar todo o processo", afirmou.

A automação da montagem da proteína no difratômetro - o equipamento utilizado para a análise da estrutura da molécula - é crucial para mudar a escala do processo, segundo o cientista.

"Temos que montar a gota de cristalização, selecionar o cristal, difratar os dados e resolver a estrutura. Uma vez que temos o cristal, o principal gargalo que temos consiste em colocá-lo dentro do difratômetro", explicou.

* Você já viu um vírus?

Uma vez que isso é feito, o robô se encarrega do resto, alinhando o cristal corretamente diante do feixe de raio X. "No meu entender, esse é o ponto que ainda está suscetível a enormes avanços de inovação. Se o robô puder 'pescar' o cristal para introduzi-lo no difratômetro, todo o processo ganhará outra escala", disse Thiemann.

Uma das alternativas utilizadas atualmente consiste em diminuir as chances para que o cristal cresça livremente dentro da gota de cristalização, imobilizando-o dentro de um capilar.

"Mas são ainda iniciativas que estão em estágio inicial. Quando o cristal cresce, geralmente a intervenção humana se faz necessária. É preciso ter discernimento para saber se o cristal é bom ou não, se inclui outros precipitados, ou se possui outras características em seu entorno que precisam ser retiradas", destacou.

Cristalização automatizada

Como essa parte do processo ainda exige a intervenção humana, o processo sofre interrupções contínuas. A automação aumentaria a velocidade, dispensaria diversos cuidados específicos e permitiria um trabalho de 24 horas por dia.

"Se quisermos, por exemplo, cocristalizar uma enzima com 500 ou mil compostos possíveis, para avaliar as características da molécula e, a partir daí, melhorar sua ação, teremos que criar condições de cristalização para todas essas cocristalizações", apontou Thiemann.

"Nesse processo, é preciso encontrar um composto, voltar atrás, cocristalizar o composto, aprender, voltar atrás mais uma vez, sintetizar o novo composto e assim por diante. Esse ciclo poderá se tornar muito mais ágil com a automação", disse.

Com mais agilidade, seria possível cristalizar as moléculas simultaneamente em larga escala. "Cristalizar a proteína é diferente de cocristalizar a proteína com um inibidor dentro dela. As condições podem ser bastante diferentes dependendo do composto e o número de combinações possíveis é enorme. Geralmente, conseguimos cocristalizar uma proteína com um ou dois inibidores - o que já dá muito trabalho aos alunos. Com o robô, poderíamos fazer isso em massa", disse.

Robótica e inteligência artificial

Para o professor da USP, a tecnologia da robótica está avançando em um ritmo muito forte, assim como a informática, que permite a análise e a distinção de padrões de imagem.

"Além disso, a inteligência artificial faz com que os programas aprendam com o que acabaram de fazer, realimentando o software para que ele consiga executar a próxima rodada com maior taxa de acerto", disse.

Segundo ele, há perspectivas de desenvolvimento desse tipo de tecnologia em vários centros no Brasil.

"Há alguns cursos de graduação - como mecatrônica e robótica - formando pessoal nessa área. Mas se trata de um segmento essencialmente multidisciplinar. Não precisamos só de alguém que saiba montar um robô, mas alguém que saiba fazê-lo com essa finalidade específica. Precisamos de pessoal com várias formações diferentes e certamente é possível desenvolver isso no Brasil", afirmou.

* Você sabe o que é Física Biológica?

Esses avanços estão revolucionando as pesquisas para a descoberta de novos fármacos a partir da síntese de novas moléculas, de acordo com Otávio Thiemann, do Instituto de Física de São Carlos (IFSC) da Universidade de São Paulo (USP).

Thiemann participou nesta quinta-feira, em São Paulo, do Simpósio sobre Biologia Sintética e Robótica, que teve o objetivo de divulgar a nova área multidisciplinar que envolve a automação e a sintetização de biocompostos.

O evento, organizado pela FAPESP e pelo Consulado Britânico em São Paulo, integra a Parceria Brasil-Reino Unido em Ciência e Inovação.

Cristalografia de proteínas

Durante o evento, o pesquisador fez uma avaliação dos avanços e perspectivas das aplicações da robótica à cristalografia de proteínas - uma técnica que permite "enxergar" as moléculas de proteína em nível atômico.

As estruturas das moléculas, entretanto, não podem ser propriamente vistas, porque sua escala é menor do que o comprimento de onda da luz visível.

Por conta disso, os cientistas utilizam raios X de alta energia, produzidos por linhas de luz síncrotron, que permitem distinguir distâncias atômicas da ordem de poucos ângstrons.

* Processo genético chave é visto em resolução atômica

Thiemann utiliza a técnica para elucidar a estrutura molecular e a função de proteínas-alvo na fisiologia de parasitas como as Leishmanias e os Trypanosomas, avaliando o potencial dessas moléculas para o desenvolvimento de novas drogas.

"Várias etapas do processo de cristalografia de proteínas já foram automatizados, mas ainda há gargalos em algumas delas. As tecnologias de automação, no entanto, estão avançando muito rapidamente e deverão tornar o ciclo inteiro muito mais ágil", disse Thiemann.

Conforme avança a robotização de determinadas fases do processo, segundo o pesquisador, a ciência avança na direção de cristalizar um grande número de proteínas simultaneamente, em vez de estudar a estrutura de cada uma delas separadamente. "Isso vai encurtar enormemente o caminho para a descoberta e melhoria de drogas", explicou.

Ciência robotizada

De acordo com o cientista, o processo para se chegar a cristalizar as moléculas - desvendando sua estrutura, sua dinâmica e sua atividade - não é trivial. Suas diversas etapas, porém, podem ser diferenciadas em dois universos diferentes: o da produção da proteína e o da cristalização propriamente dita.

"Na produção da proteína, embora a automação ainda não esteja tão bem estabelecida, já há vários robôs que podem ajudar em várias etapas do processo. Mas é ao fim da parte da cristalização que temos alguns gargalos fundamentais, cuja superação deverá revolucionar todo o processo", afirmou.

A automação da montagem da proteína no difratômetro - o equipamento utilizado para a análise da estrutura da molécula - é crucial para mudar a escala do processo, segundo o cientista.

"Temos que montar a gota de cristalização, selecionar o cristal, difratar os dados e resolver a estrutura. Uma vez que temos o cristal, o principal gargalo que temos consiste em colocá-lo dentro do difratômetro", explicou.

* Você já viu um vírus?

Uma vez que isso é feito, o robô se encarrega do resto, alinhando o cristal corretamente diante do feixe de raio X. "No meu entender, esse é o ponto que ainda está suscetível a enormes avanços de inovação. Se o robô puder 'pescar' o cristal para introduzi-lo no difratômetro, todo o processo ganhará outra escala", disse Thiemann.

Uma das alternativas utilizadas atualmente consiste em diminuir as chances para que o cristal cresça livremente dentro da gota de cristalização, imobilizando-o dentro de um capilar.

"Mas são ainda iniciativas que estão em estágio inicial. Quando o cristal cresce, geralmente a intervenção humana se faz necessária. É preciso ter discernimento para saber se o cristal é bom ou não, se inclui outros precipitados, ou se possui outras características em seu entorno que precisam ser retiradas", destacou.

Cristalização automatizada

Como essa parte do processo ainda exige a intervenção humana, o processo sofre interrupções contínuas. A automação aumentaria a velocidade, dispensaria diversos cuidados específicos e permitiria um trabalho de 24 horas por dia.

"Se quisermos, por exemplo, cocristalizar uma enzima com 500 ou mil compostos possíveis, para avaliar as características da molécula e, a partir daí, melhorar sua ação, teremos que criar condições de cristalização para todas essas cocristalizações", apontou Thiemann.

"Nesse processo, é preciso encontrar um composto, voltar atrás, cocristalizar o composto, aprender, voltar atrás mais uma vez, sintetizar o novo composto e assim por diante. Esse ciclo poderá se tornar muito mais ágil com a automação", disse.

Com mais agilidade, seria possível cristalizar as moléculas simultaneamente em larga escala. "Cristalizar a proteína é diferente de cocristalizar a proteína com um inibidor dentro dela. As condições podem ser bastante diferentes dependendo do composto e o número de combinações possíveis é enorme. Geralmente, conseguimos cocristalizar uma proteína com um ou dois inibidores - o que já dá muito trabalho aos alunos. Com o robô, poderíamos fazer isso em massa", disse.

Robótica e inteligência artificial

Para o professor da USP, a tecnologia da robótica está avançando em um ritmo muito forte, assim como a informática, que permite a análise e a distinção de padrões de imagem.

"Além disso, a inteligência artificial faz com que os programas aprendam com o que acabaram de fazer, realimentando o software para que ele consiga executar a próxima rodada com maior taxa de acerto", disse.

Segundo ele, há perspectivas de desenvolvimento desse tipo de tecnologia em vários centros no Brasil.

"Há alguns cursos de graduação - como mecatrônica e robótica - formando pessoal nessa área. Mas se trata de um segmento essencialmente multidisciplinar. Não precisamos só de alguém que saiba montar um robô, mas alguém que saiba fazê-lo com essa finalidade específica. Precisamos de pessoal com várias formações diferentes e certamente é possível desenvolver isso no Brasil", afirmou.

* Você sabe o que é Física Biológica?

Fonte: Agência Fapesp

Máquinas do tempo do futuro podem ser detectadas hoje

As viagens no tempo não são descartadas pela relatividade geral, embora possam criar problemas para as leis do senso comum.

Agora, uma equipe de físicos está propondo um novo modo de verificar a possibilidade ou a impossibilidade de estados quânticos que viajam para a frente e para trás no tempo.

O novo critério automaticamente desautoriza versões quânticas do "paradoxo do avô", segundo o qual uma pessoa viaja de volta no tempo e mata seu antecessor, garantindo assim a sua própria morte.

A equipe também realizou um experimento que ilustra o mecanismo de anulamento desse paradoxo.

Loops temporais

A relatividade geral, a teoria de Einstein do espaço e do tempo, permite a existência de loops temporais, as chamadas curvas temporais fechadas (CTCs na sigla em inglês: closed timelike curve) - rotas que avançam no tempo e, em seguida, voltam novamente para reconectar-se e formar circuitos fechados, também conhecidas como linhas lorentzianas do tempo.

Embora ainda não esteja claro se as CTCs podem ser criadas, os físicos têm explorado suas possíveis consequências, incluindo a sua influência na mecânica quântica.

Um evento quântico comum pode envolver duas partículas que se movem para frente no tempo, alterando-se mutuamente ao interagir em algum momento e, então, seguem caminhos separados rumo ao futuro.

No entanto, se uma das partículas, seguindo seu próprio futuro, entrar em uma CTC, ela pode voltar e reassumir sua posição como uma das partículas anteriores à interação - influenciando assim a sua própria transformação.

Estados quânticos

Em 1991, o físico David Deutsch, da Universidade de Oxford, propôs uma condição de consistência para evitar paradoxos nas viagens no tempo: uma partícula que volta no tempo desta forma, ao reaparecer no passado imediato à interação, deverá estar no mesmo estado quântico que estava quando partiu da interação para o futuro.

Para ver como essa condição funciona, imagine uma partícula quântica tendo estados chamados 0 e 1. Ela viaja em uma CTC e, em seu retorno, interage com uma partícula "externa" de tal forma que o 0 se torna 1 e o 1 se torna 0.

Tal partícula apresenta o paradoxo quântico do avô: quando ela volta pelo circuito, ela altera seu antigo "self" para o estado oposto.

No entanto, Deutsch mostrou que é possível alcançar a consistência se a partícula estiver em uma superposição- um estado que tem simultaneamente os dois valores, 0 e 1.

A interação altera o 0 em 1, mas o estado geral mantém-se inalterado. Para que isso funcione, a partícula externa também deve estar em uma superposição.

Universos paralelos

O paradoxo é evitado, mas o problema reaparece se a partícula externa for medida.

Nesse momento ela não poderá continuar em seu estado de superposição, devendo tornar-se definitivamente 0 ou 1 - o que significa que a partícula na CTC também não poderá permanecer em uma superposição.

Para preservar a coerência, Deutsch argumentou que a partícula CTC deve existir em dois universos paralelos - um "universo 0" e um "universo 1" - e continuamente alternar entre esses dois universos, de modo que nenhuma contradição ocorra em qualquer um deles.

Lorenzo Maccone e seus colegas do Instituto de Tecnologia de Massachusetts, nos EUA, e da Universidade de Pavia, na Itália, propõem uma condição mais rigorosa que evita essas dificuldades.

Impossibilidade de alterar o passado

Eles exigem que qualquer medição da partícula que está indo para o futuro produza o mesmo resultado gerado em sua medição quando ela retornar do passado.

Assim, não se permite qualquer estado que possa alterar o passado quando ela voltar no tempo, impedindo o surgimento do paradoxo do avô.

Talvez de forma surpreendentemente, Maccone afirma que "nós ainda podemos ter CTCs mesmo com essa condição forte."

De antemão, somente podem existir estados que evitem os paradoxos após a interação - por isso a equipe chama sua condição de "pós-seleção."

Simulação da viagem no tempo

Para demonstrar essas ideias, a equipe realizou um experimento com fótons, mostrando que a condição de consistência de fato escolhe estados específicos e destrói todos os demais.

Por falta de uma CTC real para realizar a pós-seleção, a equipe criou fótons em um estado quântico específico para a entrada, um estado onde a polarização não era conhecida e nem medida, mas tinha uma correlação com outra propriedade, associada com a trajetória do fóton.

Conforme o fóton atravessava o experimento, ele passou por mudanças que imitam a alternância de 0 para 1 que ocorre no imaginado arranjo da viagem no tempo.

A equipe descobriu que somente os fótons que não geram os paradoxos passaram incólumes pelo experimento.

Embora o resultado esteja de acordo com o esperado, ninguém havia simulado a viagem no tempo desta forma antes.

Detecção de futuras máquinas do tempo

Uma consequência estranha da pós-seleção é que, como a presença de um CTC anula completamente os estados paradoxais, ela pode impedir alguns estados que hoje parecem inócuos, mas que podem ter consequências inaceitáveis no futuro.

"Em princípio, pode-se detectar a existência futura de máquinas do tempo procurando-se por desvios atuais nas previsões da mecânica quântica," afirma Todd Brun, da Universidade da Califórnia do Sul, em Los Angeles.

Embora, segundo ele, seja difícil saber de antemão o que exatamente se deve medir em busca de tais desvios.

* Viagem no tempo derrota a Mecânica Quântica

Agora, uma equipe de físicos está propondo um novo modo de verificar a possibilidade ou a impossibilidade de estados quânticos que viajam para a frente e para trás no tempo.

O novo critério automaticamente desautoriza versões quânticas do "paradoxo do avô", segundo o qual uma pessoa viaja de volta no tempo e mata seu antecessor, garantindo assim a sua própria morte.

A equipe também realizou um experimento que ilustra o mecanismo de anulamento desse paradoxo.

Loops temporais

A relatividade geral, a teoria de Einstein do espaço e do tempo, permite a existência de loops temporais, as chamadas curvas temporais fechadas (CTCs na sigla em inglês: closed timelike curve) - rotas que avançam no tempo e, em seguida, voltam novamente para reconectar-se e formar circuitos fechados, também conhecidas como linhas lorentzianas do tempo.

Embora ainda não esteja claro se as CTCs podem ser criadas, os físicos têm explorado suas possíveis consequências, incluindo a sua influência na mecânica quântica.

Um evento quântico comum pode envolver duas partículas que se movem para frente no tempo, alterando-se mutuamente ao interagir em algum momento e, então, seguem caminhos separados rumo ao futuro.

No entanto, se uma das partículas, seguindo seu próprio futuro, entrar em uma CTC, ela pode voltar e reassumir sua posição como uma das partículas anteriores à interação - influenciando assim a sua própria transformação.

Estados quânticos

Em 1991, o físico David Deutsch, da Universidade de Oxford, propôs uma condição de consistência para evitar paradoxos nas viagens no tempo: uma partícula que volta no tempo desta forma, ao reaparecer no passado imediato à interação, deverá estar no mesmo estado quântico que estava quando partiu da interação para o futuro.

Para ver como essa condição funciona, imagine uma partícula quântica tendo estados chamados 0 e 1. Ela viaja em uma CTC e, em seu retorno, interage com uma partícula "externa" de tal forma que o 0 se torna 1 e o 1 se torna 0.

Tal partícula apresenta o paradoxo quântico do avô: quando ela volta pelo circuito, ela altera seu antigo "self" para o estado oposto.

No entanto, Deutsch mostrou que é possível alcançar a consistência se a partícula estiver em uma superposição- um estado que tem simultaneamente os dois valores, 0 e 1.

A interação altera o 0 em 1, mas o estado geral mantém-se inalterado. Para que isso funcione, a partícula externa também deve estar em uma superposição.

Universos paralelos

O paradoxo é evitado, mas o problema reaparece se a partícula externa for medida.

Nesse momento ela não poderá continuar em seu estado de superposição, devendo tornar-se definitivamente 0 ou 1 - o que significa que a partícula na CTC também não poderá permanecer em uma superposição.

Para preservar a coerência, Deutsch argumentou que a partícula CTC deve existir em dois universos paralelos - um "universo 0" e um "universo 1" - e continuamente alternar entre esses dois universos, de modo que nenhuma contradição ocorra em qualquer um deles.

Lorenzo Maccone e seus colegas do Instituto de Tecnologia de Massachusetts, nos EUA, e da Universidade de Pavia, na Itália, propõem uma condição mais rigorosa que evita essas dificuldades.

Impossibilidade de alterar o passado

Eles exigem que qualquer medição da partícula que está indo para o futuro produza o mesmo resultado gerado em sua medição quando ela retornar do passado.

Assim, não se permite qualquer estado que possa alterar o passado quando ela voltar no tempo, impedindo o surgimento do paradoxo do avô.

Talvez de forma surpreendentemente, Maccone afirma que "nós ainda podemos ter CTCs mesmo com essa condição forte."

De antemão, somente podem existir estados que evitem os paradoxos após a interação - por isso a equipe chama sua condição de "pós-seleção."

Simulação da viagem no tempo

Para demonstrar essas ideias, a equipe realizou um experimento com fótons, mostrando que a condição de consistência de fato escolhe estados específicos e destrói todos os demais.

Por falta de uma CTC real para realizar a pós-seleção, a equipe criou fótons em um estado quântico específico para a entrada, um estado onde a polarização não era conhecida e nem medida, mas tinha uma correlação com outra propriedade, associada com a trajetória do fóton.

Conforme o fóton atravessava o experimento, ele passou por mudanças que imitam a alternância de 0 para 1 que ocorre no imaginado arranjo da viagem no tempo.

A equipe descobriu que somente os fótons que não geram os paradoxos passaram incólumes pelo experimento.

Embora o resultado esteja de acordo com o esperado, ninguém havia simulado a viagem no tempo desta forma antes.

Detecção de futuras máquinas do tempo

Uma consequência estranha da pós-seleção é que, como a presença de um CTC anula completamente os estados paradoxais, ela pode impedir alguns estados que hoje parecem inócuos, mas que podem ter consequências inaceitáveis no futuro.

"Em princípio, pode-se detectar a existência futura de máquinas do tempo procurando-se por desvios atuais nas previsões da mecânica quântica," afirma Todd Brun, da Universidade da Califórnia do Sul, em Los Angeles.

Embora, segundo ele, seja difícil saber de antemão o que exatamente se deve medir em busca de tais desvios.

* Viagem no tempo derrota a Mecânica Quântica

Novo equipamento muda a forma de medir pressão sanguínea

Cientistas desenvolveram uma nova forma, mais precisa, para medir a pressão sanguínea, o que dará aos médicos informações melhor fundamentadas para embasar suas decisões sobre o tratamento.

Cientistas desenvolveram uma nova forma, mais precisa, para medir a pressão sanguínea, o que dará aos médicos informações melhor fundamentadas para embasar suas decisões sobre o tratamento.O equipamento, inventado por cientistas da Grã-Bretanha e de Cingapura, permite uma leitura mais precisa do que o método atualmente utilizado.

O equipamento será particularmente útil para as pessoas mais jovens, nas quais a pressão medida no braço às vezes pode ser bastante exagerada quando comparada com a pressão sistólica central.

Pressão sistólica central

Este é o primeiro aparelho economicamente viável e tecnicamente seguro capaz de medir a pressão arterial bem junto ao coração - a chamada pressão aórtica sistólica central ou CASP (Central Aortic Systolic Pressure).

A pressão arterial hoje é medida no braço porque isso é mais conveniente.

Contudo, a leitura que se obtém nem sempre reflete com precisão como a pressão está nas grandes artérias próximas ao coração.

A nova tecnologia usa um sensor no pulso para registrar a onda de pulso e, em seguida, usando modelos matemáticos dessa onda, um microprocessador calcula a pressão próxima ao coração - com uma precisão muito elevada, equivalente a fazer a medição direta de forma invasiva.

Pressão na aorta

Medir a pressão arterial na aorta, que está mais perto do coração e do cérebro, é importante porque é lá que a pressão arterial elevada pode causar mais danos.

Além disso, a pressão na aorta pode ser muito diferente da pressão que é tradicionalmente medida no braço.

"Não tenho qualquer dúvida sobre a magnitude da mudança que esta técnica trará. Foi um avanço científico fabuloso chegar a este ponto e ele vai mudar a forma como a pressão arterial tem sido monitorada por mais de um século," disse o Dr. Bryan Williams, que coordenou o desenvolvimento do aparelho.

"A beleza de tudo isso é que é difícil argumentar contra a tese de que a pressão próxima ao coração e ao cérebro é mais relevante para o risco de acidente vascular cerebral e doença cardíaca do que a pressão em seu braço," conclui o médico.

Fonte: Redação do Diário da Saúde

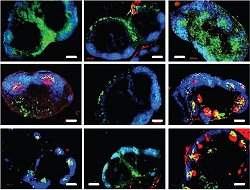

Mosquito da malária cria resposta imune contra causador da doença

O transmissor de uma doença pode ajudar a controlá-la? Uma pesquisa desenvolvida por cientistas norte-americanos, indianos e brasileiros sugere que sim.

O transmissor de uma doença pode ajudar a controlá-la? Uma pesquisa desenvolvida por cientistas norte-americanos, indianos e brasileiros sugere que sim.A doença em questão é a malária, causada pelo parasita Plasmodium e transmitida ao homem pelo mosquito Anopheles.

Os pesquisadores descobriram que o mosquito desenvolve rapidamente uma resposta imunológica ao parasita, destruindo-o.

O trabalho, que contou com a participação de dois cientistas da Fiocruz de Pernambuco, foi publicado na revista Science. A pesquisa foi realizada no Instituto Nacional de Saúde dos Estados Unidos (NIH, na sigla em inglês).

Hemolinfa

De acordo com os pesquisadores, as bactérias estão diretamente envolvidas na resposta imune do Anopheles contra o parasita, mas ainda não é possível explicar como se dá essa relação.

Nos experimentos, os pesquisadores coletaram a hemolinfa (o equivalente ao sangue nos insetos) de mosquitos contaminados pelo Plasmodium. Essa hemolinfa foi, então, transferida para mosquitos sadios, que, posteriormente, foram infectados pelo parasita.

Os resultados mostraram que a hemolinfa transferida potencializou a resposta imunológica dos insetos: todos os mosquitos sadios, após a infecção pelo Plasmodium, eliminaram por completo o parasita.

"Embora o Anopheles responda naturalmente ao Plasmodium, em alguns casos o parasita consegue completar seu ciclo de vida no organismo do mosquito", explica o pesquisador Fábio Brayner, da Fiocruz Pernambuco.

Infecção dos mosquitos

A técnica de transferência de hemolinfa foi originalmente criada pelo pesquisador Luiz Alves, também da Fiocruz Pernambuco, e aprimorada pelo grupo.

Com o uso de um microcapilar de vidro, eles retiraram a hemolinfa já diluída com anticoagulante, por meio de uma incisão no abdômen do mosquito. A transfusão foi feita com o auxílio de um microinjetor.

Para avaliar o efeito da transferência de hemolinfa dos mosquitos contaminados para os sadios, os pesquisadores verificaram o número de parasitas (no estágio de oocistos) no intestino médio dos insetos. Entre o sétimo e o 14º dia após a infecção dos mosquitos sadios estimulados com a hemolinfa, os oocistos haviam sido eliminados.

Observações

Em outros experimentos, os pesquisadores compararam dois grupos de mosquitos. O primeiro (grupo desafiado) já tinha desenvolvido previamente uma infecção pelo Plasmodium, com formação de oocistos, enquanto o segundo (grupo controle) nunca havia apresentado tal infecção.

O grupo desafiado foi, então, infectado pela segunda vez e o grupo controle, pela primeira. A comparação das células de defesa dos dois grupos de mosquitos revelou algumas diferenças.

A quantidade de células do tipo granulócito foi significativamente maior no grupo desafiado, que, por sua vez, apresentou menor número de prohemócitos (células de defesa imaturas). Alterações morfológicas e funcionais nas células também foram identificadas.

Os granulócitos do grupo desafiado apresentaram um tamanho maior e tinham mais grânulos em seu interior, indicando ativação celular para efetivar a defesa contra o parasita.

Memória imunológica

Esses resultados sugerem que os mosquitos do grupo desafiado já contavam com uma espécie de "memória imunológica" para combater o Plasmodium.

Os achados da equipe, coordenada pela cientista Carolina Barillas-Mury, do NIH, põem abaixo a crença de que os invertebrados - animais que não têm esqueleto interno, como os insetos - são incapazes de apresentar resposta imune quando infectados logo na segunda vez.

"Encontramos uma evidência clara de que eles têm uma memória imune inata que responde mais rápido do que a dos homens. Nos humanos essa memória é adaptativa, isto é, só à medida que é estimulada com algumas infecções, ela responde mais rapidamente", explica Luiz Alves.

O papel das bactérias

Os grupos controle e desafiado foram testados, ainda, em duas situações diferentes: na presença e na ausência das bactérias existentes na flora interna do inseto. Para ambos os grupos, nas situações estudadas, os testes não detectaram mudança na quantidade de granulócitos e prohemócitos. De acordo com os pesquisadores, as bactérias estão diretamente envolvidas na resposta imune do Anopheles contra o parasita, mas ainda não é possível explicar como se dá essa relação.

A meta dos cientistas é descobrir uma maneira de interromper o ciclo de transmissão da malária, e os resultados da pesquisa apontam nessa direção. Entretanto, ainda há muito para se conhecer sobre o mosquito transmissor da doença.

Além disso, ainda são necessários muitos estudos moleculares para identificar os principais elementos envolvidos na destruição do Plasmodium pelo Anopheles.

Há poucos dias, uma equipe australiana divulgou um estudo mostrando que uma bactéria pode ajudar a controlar o mosquito da dengue.

Fonte: Fabíola Tavares

sexta-feira, 25 de fevereiro de 2011

Batata quente quântica troca menor unidade possível de energia

Seu nome técnico é oscilador harmônico acoplado.

Seu nome técnico é oscilador harmônico acoplado.Mas você pode pensar nesse experimento como uma batata quente sendo descartada por dois competidores, que só podem jogá-la um na mão do outro.

Ao arremessar a batata quente, cada competidor - na verdade, cada oscilador - está enviando para o outro exatamente um quanta de energia, a menor unidade possível de energia.

Como a troca de energia equivale à troca de informações, esses osciladores acoplados poderão ser usados para transferir, por exemplo, dados codificados em um fóton, entre dois íons.

Essa capacidade de troca de energia, ou de informações, em nível quântico, é mais uma ferramenta para a oficina dos cientistas que estão trabalhando na construção dos computadores quânticos.

Eles também acreditam que a informação quântica poderá ser transferida para um oscilador mecânico - uma máquina quântica - que poderia servir de interface entre o processador quântico e o mundo macro.

A criação da primeira máquina quântica foi considerada o maior avanço científico do ano passado pela revista Science, ao demonstrar que a mecânica quântica aplica-se ao movimento de objetos macroscópicos.

Batata quente quântica

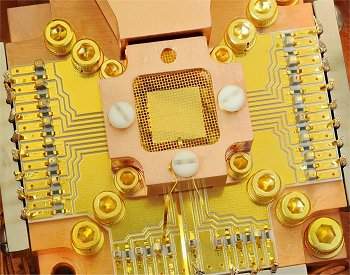

Os osciladores harmônicos acoplados foram construídos por cientistas do Instituto Nacional de Padronização e Tecnologia dos Estados Unidos.

Eles colocaram dois íons de berílio próximos um ao outro e os induziram a ficar trocando as menores unidades de energia que se pode medir.

Para entender seu funcionamento é preciso rever a analogia da batata quente.

Perceba que estamos falando de uma "batata quântica". Então, como tudo no mundo quântico é um tanto estranho, você pode dispensar a batata e os jogadores é que passam a pular um para a posição do outro, sem se chocar, trocando o calor.

O movimento dos íons, embora aconteça em condições regidas pela mecânica quântica, pode ser comparado ao comportamento de dispositivos osciladores do mundo macro, como o pêndulo de um relógio ou um diapasão.

"Primeiro um íon se mexe um pouco, enquanto o outro fica parado. Então o movimento passa para o outro íon, mediante a troca da menor quantidade de energia que se pode medir," explica Kenton Brown, um dos construtores da batata quente quântica. "Nós também ajustar o acoplamento, afetando o quão rápido eles trocam a energia e em que medida. Podemos ligar e desligar a interação."

A troca de energia de vários quanta foi detectada a cada 155 microssegundos. A troca de um quanta foi menos comum, e ocorreu a cada 218 microssegundos.

Teoricamente, os íons podem trocar energia indefinidamente, até que o processo seja interrompido pelo aquecimento - a propósito, o dispositivo funciona a -269º C.

Transformador quântico

Este experimento é semelhante ao realizado pelo mesmo grupo em 2009, quando eles demonstraram o entrelaçamento quântico, um fenômeno que associa as propriedades de de partículas separadas:

* Processador quântico programável roda pela primeira vez

Contudo, eles afirmam que o experimento agora apresentado acopla os osciladores mais diretamente e, portanto, pode simplificar o processamento quântico de informações.

O acoplamento direto de íons postos em locais separados pode simplificar as operações lógicas e ajudar a corrigir erros de processamento.

Além disso, o experimento sugere que as interações podem ser usadas para conectar diferentes tipos de sistemas quânticos, como um íon e uma partícula de luz, um fóton, para transferir informações em uma rede quântica. Por exemplo, um íon aprisionado poderia atuar como um "transformador quântico" entre um qubit supercondutor e um qubit feito de fótons.

Computador minúsculo funciona como sensor de pressão ocular

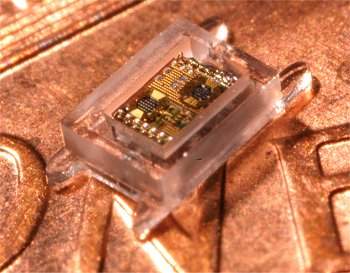

Pesquisadores da Universidade de Michigan, nos Estados Unidos, acabam de criar o primeiro "milicomputador" do mundo - um dispositivo de processamento com dimensões na faixa dos milímetros.

Pesquisadores da Universidade de Michigan, nos Estados Unidos, acabam de criar o primeiro "milicomputador" do mundo - um dispositivo de processamento com dimensões na faixa dos milímetros.Isso pode parecer estranho quando todos já se acostumaram com o termo microcomputador - em uma escala de dimensões, micro é mil vezes menor do mili.

Ocorre que, quando o termo foi cunhado, um microcomputador era minúsculo em relação aos mainframes.

E os microcomputadores tinham como unidade central de processamento um microprocessador, cujos transistores tinham dimensões na faixa dos micrômetros - logo, com um pouco de boa vontade, é possível concluir que o termo fazia sentido na época.

Mas o que os engenheiros construíram agora foi um dispositivo de processamento inteiro que mede alguns poucos milímetros. Ou, pelo menos é assim que ele foi anunciado com grande alarde.

Sensor autônomo inteligente

Embora esteja sendo chamado de computador, o equipamento é na verdade um protótipo de monitor de pressão dos olhos para pacientes com glaucoma. Quando totalmente desenvolvido, ele deverá ser implantado no olho do paciente.

Sua primeira versão foi apresentada há exatamente um ano, de forma bem mais discreta, e não como um computador, mas como um microssensor implantável para uso médico:

* Microssensor perpétuo captura sua própria energia

E ele continua sendo isto: um microssensor capaz de fazer leituras periódicas e transmitir os resultados para um computador por meio de uma conexão de rádio. Uma categoria mais adequada para o equipamento seria sensor autônomo inteligente, uma vez que computador refere-se a máquinas sem objetivos definidos.

O que, por si só, torna-o um desenvolvimento importante, rumo não apenas a dispositivos implantáveis para monitoramento da saúde, como também para viabilização das tão esperadas redes de sensores sem fios, que poderão monitorar de tudo, do funcionamento de máquinas ao processo de troca de carbono nas florestas.

Hibernação extrema

O microssensor inteligente agora apresentado é voltado sobretudo para aplicações médicas, embora ele ainda não tenha sido testado in vivo.

Em um invólucro de pouco mais de 1 milímetro cúbico, o sistema inclui um microprocessador de potência ultrabaixa, um sensor de pressão, memória, uma bateria de filme fino, uma célula solar e um transmissor de rádio com uma antena, capaz de transmitir os dados coletados para um leitor externo localizado a uma distância de alguns milímetros.

O processador no monitor de pressão intra-ocular é a terceira geração do chip Phoenix, desenvolvido pela equipe de Michigan, que usa um sistema de hibernação extrema para consumir pouca energia.

O processador acorda apenas a cada 15 minutos para fazer as medições, consumindo uma média de 5,3 nanowatts. Sua memória pode armazenar até uma semana de informações

Para manter a bateria carregada, suas células solares devem ficar expostas a pelo menos 10 horas de luz interna ou 1,5 hora de luz solar direta - uma solução aparentemente inadequada para um dispositivo implantável no corpo humano, embora muito útil para sensores ambientais.

Poeira inteligente e Nanitos

Mas é necessário fazer justiça ao trabalho de outros pesquisadores.

Como, por exemplo, o projeto "Poeira Inteligente" (SmartDust) que apresentou o realmente primeiro "milicomputador" no ano de 2003:

* Sensor wireless de 5 mm2

Poeira Inteligente refere-se a sensores minúsculos, que poderiam ser espalhados pelo ambiente para coletar dados, transmitindo-os para uma central para processamento. Coincidentemente ou não, o grupo da Universidade de Berkeley, criadora desse projeto, comparou seu sensor inteligente com a ponta de uma caneta.

A mesma ideia de computadores minúsculos está presente no conceito dos nanitos, microrrobôs milimétricos capazes de agir coletivamente, imitando o comportamento de enxames de insetos, como formigas, cupins e abelhas:

* Vêm aí os nanitos, microrrobôs milimétricos capazes de agir coletivamente

Discussões à parte, o fato é que os sistemas inteligentes na escala milimétrica, ou menor, poderão viabilizar a chamada computação ubíqua - em todos os lugares - que muitos especialistas afirmam ser o futuro da informática.

Físicos criam garrafa para guardar antimatéria

A antimatéria ficou, durante muito tempo, restrita ao mundo da teoria e da ficção científica.

A antimatéria ficou, durante muito tempo, restrita ao mundo da teoria e da ficção científica.No campo da ciência, os teóricos continuam desbravando novos caminhos, e já propõem que matéria e antimatéria podem ser criadas do "nada".

Nos últimos anos, contudo, o desenvolvimento de tecnologias experimentais está permitindo manipular diretamente essa "contraparte negativa" da matéria em laboratório.

O ano passado, por exemplo, marcou a descoberta da partícula de antimatéria mais estranha já vista, a demonstração de que pode ser possível construir um laser de raios gama pela aniquilação de matéria e antimatéria e, finalmente, a antimatéria foi capturada pela primeira vez.

Tal sequência de feitos fez com que as pesquisas sobre antimatéria fossem eleitas as mais importantes de 2010.

Produção e armazenamento de antimatéria

Embora os físicos já produzam antimatéria em laboratório de forma rotineira, usando radioisótopos e aceleradores de partículas, resfriar essas antipartículas e armazená-las por qualquer período de tempo é outra história.

Tão logo a antimatéria entra em contato com a matéria ordinária ela é aniquilada, desaparecendo - juntamente com a matéria com a qual ela se chocou - em um clarão de radiação gama.

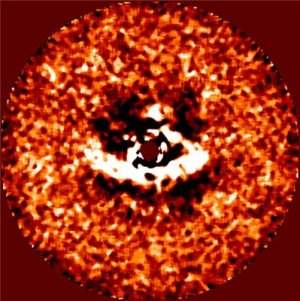

Agora, Clifford Surko e seus colegas da Universidade da Califórnia, nos Estados Unidos, relataram seus últimos avanços na construção de uma "garrafa de antimatéria", o maior recipiente de antimatéria já construído.

Durante a reunião da Sociedade Americana para o Avanço da Ciência, Surko apresentou as novas técnicas capazes de criar estados especiais de antimatéria na forma de grandes nuvens de antipartículas, comprimir essas nuvens e gerar disparos de feixes de antimatéria - ideais para usos em experimentos de laboratório.

Garrafas de antimatéria

Nos últimos anos, os cientistas desenvolveram novas técnicas para armazenar bilhões de pósitrons - o equivalente de antimatéria do elétron - por várias horas e resfriá-los a baixas temperaturas, a fim de retardar seus movimentos para que eles possam ser estudados - criando moléculas de antimatéria, por exemplo.

Surko relatou que agora já é possível retardar os pósitrons gerados por fontes radioativas, levando-os a condições de baixa energia.

Isto permite que eles sejam guardados por dias em "garrafas de antimatéria" especialmente projetadas, cujas paredes são formadas não por matéria, mas por campos magnéticos e elétricos.

Eles também desenvolveram técnicas para resfriar a antimatéria a temperaturas tão baixas quanto as do hélio líquido e para comprimi-la em altas densidades.

Feixes de antimatéria

"Pode-se, em seguida, empurrar a antimatéria para fora da garrafa em um fluxo fino, um feixe, de forma parecida com apertar um tubo de pasta de dente," disse Surko, acrescentando que há uma grande variedade de usos para esses feixes de pósitrons.

Atualmente, os pósitrons, ou anti-elétrons, são usados em exames de tomografia conhecidos como PET (Positron Emission Tomography: tomografia por emissão de pósitrons).

Na técnica da garrafa de antimatéria, os feixes de pósitrons serão usados de forma diferente.

"Estes raios oferecem novas formas de estudar como as antipartículas interagem ou reagem com a matéria comum," disse Surko. "Eles são muito úteis, por exemplo, na compreensão das propriedades superficiais dos materiais."

Depósito de antimatéria

Surko e seus colegas estão agora construindo o maior depósito de antimatéria do mundo, que irá armazenar pósitron de baixa energia - a armadilha será capaz de armazenar mais de um trilhão de partículas de antimatéria.

"Estamos trabalhando agora para acumular trilhões de pósitrons ou mais, em armadilhas formadas por múltiplas células, uma matriz de garrafas magnéticas semelhantes a um hotel com muitos quartos, com cada quarto contendo dezenas de bilhões de antipartículas," disse ele.

"Um entusiasmante objetivo de longo prazo do nosso trabalho é a criação de armadilhas portáteis de antimatéria," acrescentou Surko. "Isso aumentaria consideravelmente a capacidade de usar e explorar as antipartículas no nosso mundo de matéria, em situações onde é inconveniente usar os radioisótopos ou as fontes de pósitrons baseadas em aceleradores."

Metamaterial tritura recorde de índice refração

Quando você olha para uma colher dentro de um copo com água, a colher parece quebrada.

Isto acontece por causa do índice refração da água, uma medida de quanto a luz se curva quando passa de um meio para o outro.

Na verdade, o índice de refração mede o ângulo em que a luz se curva quando passa do vácuo para o material em questão.

Os materiais comuns, como a água ou o vidro, têm índices de refração entre 1 e 3 nas frequências da luz visível - o recorde vai para o silício, que se aproxima de 4.

Agora, cientistas coreanos desenvolveram um material cujo índice de refração bateu em incríveis 38,6.

Metamaterial

É um material artificial, um assim chamado metamaterial, que opera na frequência dos terahertz - os raios T.

Os metamateriais ganharam notoriedade com as pesquisas sobre invisibilidade, graças à sua capacidade de dobrar a luz ao contrário, na direção oposta ao que fazem os materiais naturais.

Este novo metamaterial, por sua vez, possui um índice de refração positivo, o que o torna especialmente adequado para pesquisas com a promissora radiação terahertz, que promete substituir os raios X, sem os malefícios destes.

Outra possibilidade de aplicação prática é na chamada óptica transformacional, que estuda o controle das ondas de luz.

Átomos em formato de I

Bumki Min e seus colegas do instituto KAIST sintetizaram o metamaterial construindo "átomos" com estruturas de ouro e alumínio - como esses materiais artificiais são compostos de unidades básicas menores do que o comprimento de onda da radiação com que devem operar, os cientistas chamam essas unidades fundamentais de átomos.

Os átomos artificiais, em formato de I, têm cerca de 60 micrômetros de altura e se repetem sobre uma matriz de polímero a cada 60 micrômetros.

O material bateu o recorde do índice de refração - alcançando um pico de 38,6 - a uma frequência de 0,3 THz.

Segundo os cientistas, o feito é promissor porque pode ser possível alcançar níveis ainda mais elevados, ou alcançar níveis significativos em outros comprimentos de onda, uma vez que os átomos podem ser montados em camadas ou serem montados em outros espaçamentos.

Isto acontece por causa do índice refração da água, uma medida de quanto a luz se curva quando passa de um meio para o outro.

Na verdade, o índice de refração mede o ângulo em que a luz se curva quando passa do vácuo para o material em questão.

Os materiais comuns, como a água ou o vidro, têm índices de refração entre 1 e 3 nas frequências da luz visível - o recorde vai para o silício, que se aproxima de 4.

Agora, cientistas coreanos desenvolveram um material cujo índice de refração bateu em incríveis 38,6.

Metamaterial

É um material artificial, um assim chamado metamaterial, que opera na frequência dos terahertz - os raios T.

Os metamateriais ganharam notoriedade com as pesquisas sobre invisibilidade, graças à sua capacidade de dobrar a luz ao contrário, na direção oposta ao que fazem os materiais naturais.

Este novo metamaterial, por sua vez, possui um índice de refração positivo, o que o torna especialmente adequado para pesquisas com a promissora radiação terahertz, que promete substituir os raios X, sem os malefícios destes.

Outra possibilidade de aplicação prática é na chamada óptica transformacional, que estuda o controle das ondas de luz.

Átomos em formato de I

Bumki Min e seus colegas do instituto KAIST sintetizaram o metamaterial construindo "átomos" com estruturas de ouro e alumínio - como esses materiais artificiais são compostos de unidades básicas menores do que o comprimento de onda da radiação com que devem operar, os cientistas chamam essas unidades fundamentais de átomos.

Os átomos artificiais, em formato de I, têm cerca de 60 micrômetros de altura e se repetem sobre uma matriz de polímero a cada 60 micrômetros.

O material bateu o recorde do índice de refração - alcançando um pico de 38,6 - a uma frequência de 0,3 THz.

Segundo os cientistas, o feito é promissor porque pode ser possível alcançar níveis ainda mais elevados, ou alcançar níveis significativos em outros comprimentos de onda, uma vez que os átomos podem ser montados em camadas ou serem montados em outros espaçamentos.

Coração de mamíferos pode se regenerar

Cientistas descobriram que os corações de camundongos recém-nascidos podem se regenerar, em um processo nunca visto entre mamíferos.

A pesquisa foi publicada nesta sexta-feira pela revista Science.

Os pesquisadores do Centro Médico Southwestern, da Universidade do Texas, autores da pesquisa, removeram o que é conhecido como o ápice ventricular esquerdo do coração (cerca de 15% do músculo cardíaco) dos camundongos, apenas um dia depois de eles terem nascido.

Foi observado que o coração se recompôs completamente após 21 dias. Dois meses depois, o órgão parecia estar funcionando normalmente.

Muitos peixes e anfíbios são conhecidos por sua capacidade de reconstruir o tecido de seus corações, mas, segundo o estudo divulgado nesta sexta, isso nunca tinha sido observado em mamíferos.

Para especialistas britânicos, o entendimento desse processo nos camundongos pode ajudar em tratamentos cardíacos para humanos.

Autorregeneração

No entanto, quando o mesmo experimento foi realizado em roedores com uma semana de vida, o coração foi incapaz de se refazer sozinho, indicando que é curto o período em que os animais preservam a habilidade de autorregeneração.

Acredita-se que as células cardíacas continuem a se replicar e se recompor durante um breve intervalo após o nascimento do camundongo.

"Nossos resultados mostram que as células do novo músculo cardíaco, que recuperam a área amputada do coração, vêm da proliferação e migração de células cardíacas pré-existentes", disse um dos autores do estudo, o professor Eric Olson. "Não temos evidência de que tenham vindo de uma população de células-tronco."

Segundo Olson, há motivos para acreditar que o coração humano tenha a mesma capacidade.

"Tudo o que sabemos sobre o desenvolvimento e as funções iniciais do coração do camundongo são comparáveis ao coração humano. Portanto, estamos confiantes que esse processo pode se repetir em humanos, ainda que isso ainda precise ser mostrado."

Capacidade regenerativa

Os cientistas americanos agora buscam formas de ativar esta capacidade regenerativa em corações de camundongos adultos, com a ambição de fazer o mesmo em humanos e corrigir danos causados durante ataques cardíacos.

"Identificamos um micro-RNA (pequeno pedaço de material genético) que regula esse processo e vamos tentar usá-lo como forma de incrementar a capacidade de regeneração cardíaca. Também estamos buscando novas drogas que possam reavivar esse mecanismo na vida adulta", afirma Olson.

O pesquisador diz, no entanto, que novas pesquisas esbarram em desafios, como evitar que a alteração das células cardíacas humanas provoque arritmias, por exemplo. Além disso, o funcionamento do coração humano é mais complexo do que o de outros animais.

A pesquisa foi publicada nesta sexta-feira pela revista Science.

Os pesquisadores do Centro Médico Southwestern, da Universidade do Texas, autores da pesquisa, removeram o que é conhecido como o ápice ventricular esquerdo do coração (cerca de 15% do músculo cardíaco) dos camundongos, apenas um dia depois de eles terem nascido.

Foi observado que o coração se recompôs completamente após 21 dias. Dois meses depois, o órgão parecia estar funcionando normalmente.

Muitos peixes e anfíbios são conhecidos por sua capacidade de reconstruir o tecido de seus corações, mas, segundo o estudo divulgado nesta sexta, isso nunca tinha sido observado em mamíferos.

Para especialistas britânicos, o entendimento desse processo nos camundongos pode ajudar em tratamentos cardíacos para humanos.

Autorregeneração

No entanto, quando o mesmo experimento foi realizado em roedores com uma semana de vida, o coração foi incapaz de se refazer sozinho, indicando que é curto o período em que os animais preservam a habilidade de autorregeneração.

Acredita-se que as células cardíacas continuem a se replicar e se recompor durante um breve intervalo após o nascimento do camundongo.

"Nossos resultados mostram que as células do novo músculo cardíaco, que recuperam a área amputada do coração, vêm da proliferação e migração de células cardíacas pré-existentes", disse um dos autores do estudo, o professor Eric Olson. "Não temos evidência de que tenham vindo de uma população de células-tronco."

Segundo Olson, há motivos para acreditar que o coração humano tenha a mesma capacidade.

"Tudo o que sabemos sobre o desenvolvimento e as funções iniciais do coração do camundongo são comparáveis ao coração humano. Portanto, estamos confiantes que esse processo pode se repetir em humanos, ainda que isso ainda precise ser mostrado."

Capacidade regenerativa

Os cientistas americanos agora buscam formas de ativar esta capacidade regenerativa em corações de camundongos adultos, com a ambição de fazer o mesmo em humanos e corrigir danos causados durante ataques cardíacos.

"Identificamos um micro-RNA (pequeno pedaço de material genético) que regula esse processo e vamos tentar usá-lo como forma de incrementar a capacidade de regeneração cardíaca. Também estamos buscando novas drogas que possam reavivar esse mecanismo na vida adulta", afirma Olson.

O pesquisador diz, no entanto, que novas pesquisas esbarram em desafios, como evitar que a alteração das células cardíacas humanas provoque arritmias, por exemplo. Além disso, o funcionamento do coração humano é mais complexo do que o de outros animais.

Fonte: BBC

Vírus artificial pode estimular imunidade definitiva

Vacinas feitas com vírus vivos, como as da varíola ou da febre amarela, oferecem uma proteção imunológica que dura décadas.

Vacinas feitas com vírus vivos, como as da varíola ou da febre amarela, oferecem uma proteção imunológica que dura décadas.O grande sonho dos cientistas, contudo, sempre foi o de induzir uma resposta imunológica que dure toda a vida da pessoa.

Eles têm tateado no escuro há muito tempo em busca desse "santo remédio".

Agora eles parecem ter encontrado um ponto de referência nessa escuridão, com a ajuda da nanotecnologia.

Vírus artificial

Cientistas do Centro de Vacinas Emory, nos Estados Unidos, criaram minúsculas nanopartículas que se assemelham aos vírus, tanto no tamanho como na composição imunológica, e que induziram a "imunidade vitalícia" em camundongos.

Os resultados em macacos foram igualmente promissores.

Esses vírus artificiais reproduziram com sucesso os efeitos imuno-estimulantes de uma das vacinas de maior sucesso já desenvolvidas - a vacina contra a febre amarela.

As nanopartículas, feitas de polímeros biodegradáveis, têm componentes que ativam dois elementos diferentes do sistema imunológico, e podem ser usadas com materiais extraídos de vários tipos de bactérias ou vírus.

"Estes resultados desvendam um antigo enigma em vacinologia: como fazer com que as vacinas induzam uma imunidade duradoura," explicou Bali Pulendran, coordenador do estudo, que foi publicado na revista Nature.

Receptores TLR

As nanopartículas podem se tornar uma ferramenta importante para substituir o material viral - esse material nem sempre está ao alcance da mão quando se trata de pandemias ou no surgimento de novas infecções - e para ajudar no desenvolvimento de vacinas para doenças ainda não contempladas com soluções efetivas de prevenção, como HIV, malária, tuberculose e dengue.

Os pesquisadores se inspiraram na vacina contra a febre amarela, desenvolvida nos anos 1930 e que oferece proteção por décadas.

Esta vacina estimula receptores do sistema imunológico conhecidos como TLR (Tool-Like Receptors), moléculas produzidas pelas células que, ao detectar "produtos" dos vírus, bactérias e parasitas, ativam uma resposta do sistema imunológico.

O grupo do Dr. Pulendran descobriu que o sistema imunológico detecta a vacina contra a febre amarela por meio de múltiplos TLRs.

"Os TLRs são como um sexto sentido dos nossos corpos, porque eles têm uma capacidade requintada para detectar vírus e bactérias e transmitir esta informação para estimular a resposta imunológica," explicou o pesquisador.

"Descobrimos que, para obter a melhor resposta imunológica, é preciso acertar mais de um tipo de receptor tipo Toll. Nosso objetivo foi criar uma partícula sintética que realiza essa tarefa," completou.

Anticorpos

As nanopartículas são feitas de um plástico especial e biocompatível, chamado PLGA, atualmente utilizado para enxertos e suturas biodegradáveis. Todos os componentes da fórmula das nanopartículas já são aprovados para uso humano.

Nos testes em camundongos, as nanopartículas estimularam a produção de anticorpos para proteínas do vírus da gripe e da bactéria do antrax.

Mais importante, as células do sistema imunológico persistiram nos gânglios linfáticos por, pelo menos, 18 meses, praticamente o tempo de vida da cobaia.

Nos testes com macacos, as nanopartículas acrescidas das proteínas virais induziram respostas fortes cinco vezes maiores do que a resposta induzida por uma dose da mesma proteína viral isolada, sem as nanopartículas.

Ainda não há previsão para o início dos testes desses vírus artificiais em humanos.

Fonte: Redação do Diário da Saúde

Nanopartículas híbridas combatem microorganismos e fungos

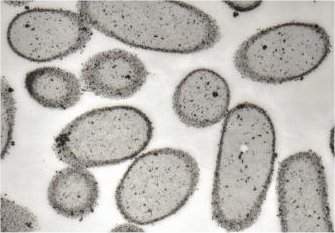

Cientistas da USP desenvolveram uma nova família de nanopartículas com propriedades antimicrobianas e antifúngicas.

Nanopartículas são aglomerados de matéria com dimensões na faixa dos nanômetros - 1 nanômetro é igual a 1 bilionésimo de metro. Elas são tão pequenas que só podem ser visualizadas em microscópios eletrônicos.

A equipe da professora Ana Maria Carmona Ribeiro, do Instituto de Química da USP, desenvolveu nanopartículas híbridas, formadas pela combinação de lipídios (gorduras) e polímeros (plásticos).

"Com esse sistema sistema biomimético é possível interagir com células e tecidos, além de bactérias e microorganismos patogênicos", aponta a professora. "A interação com moléculas de cargas opostas abre a possibilidade de que as partículas possam carregar drogas até as células, uma função importante para o desenvolvimento de fármacos."

Antimicrobiano

As nanoestruturas híbridas combinam lipídios e polímeros sintéticos catiônicos, que possuem cargas semelhantes, unidos por um polímero com carga oposta.

"Os lipídios, apesar de serem produzidos sinteticamente, são bastante acessíveis", diz Ana Maria. "Eles apresentam um grupamento de amônio quaternário, que possui comprovado efeito bactericida."

Em solução aquosa, os lipídios apresentam a propriedade de se estruturar em bicamadas, de forma análoga às membranas celulares.

Testes preliminares apontaram que os polímeros sintéticos catiônicos, que também possuíam um agrupamento de amônio quaternário, também apresentam atividade antimicrobiana, o que levou à combinação com o lipídio.

"Como os dois compostos são catiônicos, ou seja, possuem cargas positivas, utilizou-se um polímero aniônico, que serve para unir os dois materiais", ressalta Ana Maria. "Ambos mantêm suas propriedades antimicrobianas na combinação."

Fungicida

As pesquisas também mostraram uma propriedade antifúngica associada às partículas híbridas. "O efeito fungicida completo só acontece com a adição do polímero catiônico ao lipídio", explica a professora. "Essa atividade é importante porque fungos são organismos difíceis de se combater em terapia".

* Óleo de lavanda combate infecções causadas por fungos

As partículas passaram por testes com hemácias (células sanguíneas) para verificar sua toxicidade em células de mamíferos.

"Não houve hemólise, ou seja, rompimento das hemácias", conta Ana Maria, "o que é um possível indício da compatibilidade das partículas com organismos vivos mais complexos". Em prosseguimento aos estudos, serão realizados testes de toxicidade in vivo, em animais e humanos.

Antifungo para madeira

Além da utilização em fármacos, a professora menciona outras possíveis aplicações das partículas híbridas, como na produção de tintas.

"A tinta látex é um particulado que sujeito a chuva e a umidade pode propiciar o desenvolvimento de populações de fungos", relata. "Partículas híbridas poderiam ser incorporadas à composição da tinta, criando um revestimento com efeito fungicida permanente."

A ação das partículas também poderia ser aproveitada na indústria madeireira. "Há uma grande preocupação com a possibilidade da madeira desenvolver fungos", diz Ana Maria. "Como forma de proteção, a madeira poderia ser impregnada com as partículas fungicidas". As pesquisas são realizadas no Laboratório de Biocolóides do Departamento de Bioquímica do IQ.

Nanopartículas são aglomerados de matéria com dimensões na faixa dos nanômetros - 1 nanômetro é igual a 1 bilionésimo de metro. Elas são tão pequenas que só podem ser visualizadas em microscópios eletrônicos.

A equipe da professora Ana Maria Carmona Ribeiro, do Instituto de Química da USP, desenvolveu nanopartículas híbridas, formadas pela combinação de lipídios (gorduras) e polímeros (plásticos).

"Com esse sistema sistema biomimético é possível interagir com células e tecidos, além de bactérias e microorganismos patogênicos", aponta a professora. "A interação com moléculas de cargas opostas abre a possibilidade de que as partículas possam carregar drogas até as células, uma função importante para o desenvolvimento de fármacos."

Antimicrobiano

As nanoestruturas híbridas combinam lipídios e polímeros sintéticos catiônicos, que possuem cargas semelhantes, unidos por um polímero com carga oposta.

"Os lipídios, apesar de serem produzidos sinteticamente, são bastante acessíveis", diz Ana Maria. "Eles apresentam um grupamento de amônio quaternário, que possui comprovado efeito bactericida."

Em solução aquosa, os lipídios apresentam a propriedade de se estruturar em bicamadas, de forma análoga às membranas celulares.

Testes preliminares apontaram que os polímeros sintéticos catiônicos, que também possuíam um agrupamento de amônio quaternário, também apresentam atividade antimicrobiana, o que levou à combinação com o lipídio.

"Como os dois compostos são catiônicos, ou seja, possuem cargas positivas, utilizou-se um polímero aniônico, que serve para unir os dois materiais", ressalta Ana Maria. "Ambos mantêm suas propriedades antimicrobianas na combinação."

Fungicida

As pesquisas também mostraram uma propriedade antifúngica associada às partículas híbridas. "O efeito fungicida completo só acontece com a adição do polímero catiônico ao lipídio", explica a professora. "Essa atividade é importante porque fungos são organismos difíceis de se combater em terapia".

* Óleo de lavanda combate infecções causadas por fungos

As partículas passaram por testes com hemácias (células sanguíneas) para verificar sua toxicidade em células de mamíferos.

"Não houve hemólise, ou seja, rompimento das hemácias", conta Ana Maria, "o que é um possível indício da compatibilidade das partículas com organismos vivos mais complexos". Em prosseguimento aos estudos, serão realizados testes de toxicidade in vivo, em animais e humanos.

Antifungo para madeira

Além da utilização em fármacos, a professora menciona outras possíveis aplicações das partículas híbridas, como na produção de tintas.

"A tinta látex é um particulado que sujeito a chuva e a umidade pode propiciar o desenvolvimento de populações de fungos", relata. "Partículas híbridas poderiam ser incorporadas à composição da tinta, criando um revestimento com efeito fungicida permanente."

A ação das partículas também poderia ser aproveitada na indústria madeireira. "Há uma grande preocupação com a possibilidade da madeira desenvolver fungos", diz Ana Maria. "Como forma de proteção, a madeira poderia ser impregnada com as partículas fungicidas". As pesquisas são realizadas no Laboratório de Biocolóides do Departamento de Bioquímica do IQ.

Fonte: Agência USP

quinta-feira, 24 de fevereiro de 2011

Matemáticos criam Tabela Periódica dos átomos geométricos

Matemáticos estão criando sua própria Tabela Periódica, uma coleção de formatos geométricos fundamentais, que não podem ser reduzidos a nada mais simples.

Os átomos geométricos são "formatos suaves", sem bordas ou cantos, lembrando mais esferas deformadas, podendo ser descritos em termos do seu "fluxo" - se um formato tem um padrão único de fluxo, então ele é um átomo; se não ele é uma molécula e pode ser decomposto em formatos mais simples.

Esses formatos simples, ou átomos geométricos, são conhecidos pelos matemáticos como variedades de Fano, em referência a Gino Fano, que descobriu nove formatos atômicos bidimensionais nos anos 1930. Na década de 1980 foram descobertos 102 formatos em três dimensões.

Mas ninguém antes havia organizado esses formatos fundamentais em grupos e nem avançado rumo a múltiplas dimensões. Um novo programa de computador criado pelos pesquisadores certamente facilitará esse trabalho daqui para frente.

Tabela Periódica de formatos

Esses átomos geométricos, à primeira vista, deverão produzir um número muito maior de "elementos matemáticos" do que a Tabela Periódica tradicional tem de elementos químicos.

Isso porque o objetivo dos cientistas é ambicioso: isolar todos os "possíveis formatos do universo" em três, quatro e cinco dimensões, interligando os formatos da mesma forma que os elementos químicos são reunidos em famílias.

"A Tabela Periódica é uma das ferramentas mais importantes na química. Ela lista os átomos com os quais tudo o mais é feito, e explica suas propriedades químicas," explica o professor Alessio Corti, que está trabalhando juntamente com matemáticos da Austrália, Japão e Rússia.