O glaucoma é uma degeneração da cabeça do nervo óptico que leva a uma perda de campo visual permanente e irreversível no indivíduo. É a segunda causa de cegueira no mundo, respondendo por 12% dos casos, ficando atrás apenas da catarata (48%).

A pressão intraocular e a história familiar positiva são importantes fatores de risco para o desenvolvimento do glaucoma primário de ângulo aberto, que é a forma mais comum da doença e que se manifesta principalmente após os 40 anos com certas peculiaridades.

Seu início tardio em muitos casos e suas alterações em diferentes tecidos oculares, como o trabeculado (região responsável em parte pela determinação da pressão intraocular) e a cabeça do nervo óptico, indicam a presença de mais de um gene no desenvolvimento do glaucoma.

O aumento da pressão intraocular é o mais destacado fator de risco para o glaucoma do adulto.

Porém, existem outras situações em que, antagonicamente, é possível que um paciente com glaucoma não tenha pressão intraocular elevada e ainda, mesmo sendo portador do problema, que não tenha glaucoma.

A característica fundamental que define esta moléstia, no entanto, é de fato a presença de lesão típica da cabeça do nervo óptico, observada durante o exame oftalmológico.

Em busca dos genes do glaucomaNo genoma humano existem, até o momento, 14 regiões associadas ao glaucoma do adulto. Apenas em três dessas regiões, os genes já foram identificados: o gene miocilina, que é o de maior efeito para o desenvolvimento do glaucoma, o optineurina e o WDR-36, o que leva a crer que ainda é possível encontrar genes novos mesmo na população brasileira.

Várias equipes de cientistas permanecem procurando genes relacionados à doença. Este é o caso do Grupo de Genética em Oftalmologia (CBMEG) da Unicamp, coordenado pela geneticista Mônica Barbosa de Melo e pelo oftalmologista José Paulo Cabral de Vasconcellos.

O grupo da Unicamp tem concentrado forças para caracterizar melhor o papel do gene miocilina em relação ao glaucoma, que é o mais expressivo gene conhecido relacionado a esta doença. Alterações neste gene estão geralmente associadas a um tipo de glaucoma familiar, de instalação mais precoce e de maior gravidade, cuja pressão intraocular é bem mais elevada que a normal.

Gene brasileiro do glaucomaOs principais estudos com o gene miocilina foram iniciados no Brasil por José Paulo, analisando pacientes com glaucoma primário de ângulo aberto do tipo juvenil, que é uma forma de glaucoma do adulto que surge mais precocemente e também mais agressiva.

Em sua pesquisa, o oftalmologista identificou uma nova e frequente mutação neste gene que, até hoje, ainda não foi descrita em outra população, somente na brasileira.

A mutação consiste na troca de uma cisteína (um dos aminoácidos que fazem parte do código genético) por uma arginina na posição 433 da proteína miocilina, o que equivale a dizer que esta alteração localiza-se em uma região bastante conservada e estruturalmente muito importante para o bom funcionamento desta proteína.

Por isso o grupo da Unicamp acompanha rotineiramente famílias com alterações neste gene. "Quando as encontramos, procuramos estudar o seu papel em relação à doença e à evolução clínica do paciente, indagando a quantidade de cirurgias a que o paciente foi submetido e a quantidade de medicações em uso para controle da doença. Com isto tentamos estabelecer uma relação entre a gravidade da doença (fenótipo) e a presença ou não da mutação (genótipo)".

Descoberta de novos genesTambém há uma tentativa de identificar novos genes modificadores que agiriam de forma a colaborar para o aparecimento da doença ou torná-la mais ou menos grave.

Por que indivíduos que têm a mesma alteração se comportam de formas diferentes? José Paulo esclarece que neste processo pode haver uma interação com genes modificadores, como no caso do CYP1B1, que é o gene associado ao glaucoma congênito, além da contribuição de fatores ambientais.

Ao concluir sua tese e constatar o estado daquela pesquisa no mundo, o pesquisador propôs uma investigação para identificar novos genes ou novas regiões do genoma associadas ao glaucoma primário de ângulo aberto - glaucoma do adulto - em famílias brasileiras. Esta iniciativa gerou um projeto que foi aceito pelo Programa Jovens Pesquisadores em Centros Emergentes da Fundação de Amparo à Pesquisa do Estado de São Paulo (Fapesp).

Acompanhamento de famílias com glaucomaAo longo do novo projeto, várias famílias portadoras de glaucoma foram analisadas e apresentaram a troca de cisteína por arginina no aminoácido 433 da miocilina. Nesse particular, as famílias têm sido acompanhadas quanto à presença desta mutação em relação à manifestação do glaucoma, a sua evolução e ao seu prognóstico, abrindo novas perspectivas para que elas possam ser seguidas mais de perto pelo oftalmologista, uma vez que sabe-se que indivíduos com esta alteração acima dos 40 anos apresentam a doença de 80% a 100% dos casos.

Um dos pontos do estudo, contudo, permanece uma incógnita, já que até agora são pelo menos 11 regiões do genoma com grande probabilidade de conter genes relacionados ao glaucoma adulto. Por outro lado, também foram selecionadas famílias sem alteração em nenhuma destas regiões. A pergunta de Mônica é: "será que conseguiremos identificar algum gene novo nestas famílias com glaucoma na população brasileira?"

Em uma outra fase da pesquisa, que é uma abordagem de ponta, utilizam-se chips de DNA para avaliar variações de números de cópias ou copy number variations (CNV). Isso porque atualmente se discute a participação destas alterações, que variam de quilobases a megabases em tamanho e que poderiam ter participação na causa de diversas doenças. Estes resultados estão sendo analisados e algumas regiões podem estar relacionadas ao desenvolvimento do glaucoma.

Prevenção e aconselhamentoUma das contribuições da genética para o glaucoma é compreender melhor os mecanismos por meio dos quais esta doença se desenvolve. Com isso, propõem-se melhores tratamentos e métodos diagnósticos, pontua José Paulo.

Outra contribuição, enfatiza Mônica, consiste na possibilidade de se realizar um futuro aconselhamento genético, pois quanto mais se entende a genética do glaucoma, mais se chega a indivíduos com maior ou menor risco. Além disso, a genética permite indicar um acompanhamento personalizado, iniciativa que tem sido estimulada pelo grupo da Unicamp.

Genética e oftalmologiaSegundo Mônica, na pesquisa de genética em oftalmologia, há seis pessoas atualmente envolvidas, quatro atuando mais na identificação de genes e outras duas em pesquisas sobre as alterações do gene miocilina.

O grupo, ligado ao Laboratório de Genética Molecular Humana do CBMEG, também investiga aspectos genéticos da catarata congênita, da degeneração macular relacionada à idade, da retinopatia falciforme e do glaucoma congênito.

Em relação ao glaucoma congênito, estuda-se o principal gene identificado até o momento, o CYP1B1, em famílias e também em casos esporádicos. Esta pesquisa foi publicada na revista Investigative Ophthalmology and Visual Science (IOVS), desenvolvida em conjunto com a Universidade de Connecticut, EUA.

Recentemente, uma tese defendida sob orientação de Mônica e de José Paulo teve seus resultados divulgados no Journal of Glaucoma, demonstrando que na população brasileira existe uma variação de 30% a 50% de mutações neste gene relacionadas ao glaucoma congênito, ou seja, de crianças que já nascem com a doença.

Riscos do glaucomaO glaucoma, quando não diagnosticado e, portanto não tratado, pode levar a um risco maior de cegueira. Sendo assim, indivíduos com histórico familiar ou mesmo alterações nos genes associados ao glaucoma devem ter uma atenção médica mais dirigida aos seus aspectos preventivos.

Pacientes que têm uma mutação no gene miocilina e não desenvolvem a doença, por exemplo, devem ter um acompanhamento mais frequente para que, estando diante de qualquer indício da doença, possam começar rapidamente o tratamento.

Realizar consultas desse modo - com mensuração da pressão intraocular e exames de fundo de olho - e não protelar o início do tratamento ao menor indício de aumento da pressão intraocular, ou mesmo mediante algum sinal precoce de alteração do nervo óptico, são medidas fundamentais para minimizar e mesmo evitar as perdas visuais causadas pelo glaucoma, de acordo com José Paulo.

Tratamento do glaucomaO início da terapêutica em geral é clínico, conta ele, começando pela indicação de um colírio que reduz a pressão intraocular; a indicação cirúrgica fica restrita aos pacientes que não responderam ao tratamento clínico, com redução para níveis seguros da pressão intraocular.

A cirurgia do glaucoma consiste na redução da pressão para valores que impeçam a progressão da doença, protegendo a cabeça do nervo óptico e impedindo perda adicional do campo visual. Quando se trata de um indivíduo com história familiar de glaucoma, recomenda-se que haja uma ampla investigação e acompanhamento, não somente do paciente, mas igualmente da sua família.

Ao estudar famílias que têm alteração no gene miocilina, José Paulo recorda que atendeu uma adolescente que chegou à consulta médica apresentando 20mmHg de pressão intraocular, sendo que o pai já era cego dos dois olhos e o avô também. "Não houve dúvida para instituirmos o tratamento, começando a tratá-la, apesar de não ter sinal de alteração glaucomatosa da cabeça do nervo óptico. A pressão intraocular normal varia entre 10mmHg e 20mmHg, portanto a adolescente estava no limite superior da pressão intraocular e tinha histórico familiar da mutação.

Rastreamento de mutaçõesEm 1997, o pesquisador Stone e colaboradores identificaram o gene miocilina, associado ao glaucoma primário de ângulo aberto (GPAA), por meio de estudos de ligação em famílias portadoras desta enfermidade.

Os autores concluíram que mutações no gene miocilina seriam a causa mais frequente de cegueira com base molecular conhecida. Diversos estudos subsequentes, avaliando mutações neste gene em populações portadoras de GPAA esporádico, das mais diversas origens étnicas, obtiveram frequências de mutações variando de 2% a 5%.

Entretanto, observou-se que esta frequência elevava-se para aproximadamente 30% em indivíduos com história familiar de glaucoma e desenvolvimento da moléstia antes dos 40 anos de idade, caracterizando o GPAA do tipo juvenil (GPAA-J).

O rastreamento de mutações neste gene foi realizado na população brasileira de pacientes com GPAA-J e GPAA, obtendo-se uma frequência de mutações de 35,71% e 3,85% respectivamente.

Além disso, identificou-se uma mutação específica da população brasileira, a troca do aminoácido cisteína por arginina na posição 433 da proteína, presente em 28% dos pacientes com GPAA-J. A presença desta mutação entre os indivíduos com GPAA-J levou ao desenvolvimento de um glaucoma com níveis pressóricos significativamente mais elevados e necessidade mais frequente de procedimentos cirúrgicos para o controle da doença. Portanto, o tipo de mutação no gene miocilina contribuiria para a gravidade do glaucoma.

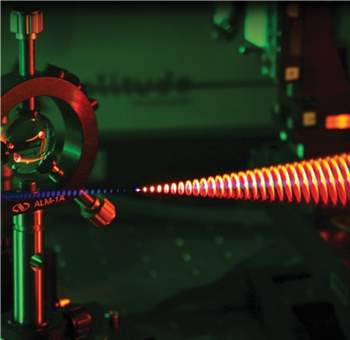

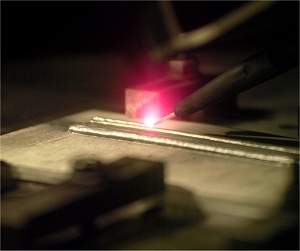

O físico brasileiro Ricardo Elgul Samad, do IPEN (Instituto de Pesquisas Energéticas e Nucleares), foi o vencedor do 4º concurso de imagens fotográficas realizado anualmente pela revista Optics & Photonics News, da Sociedade Óptica da América.

O físico brasileiro Ricardo Elgul Samad, do IPEN (Instituto de Pesquisas Energéticas e Nucleares), foi o vencedor do 4º concurso de imagens fotográficas realizado anualmente pela revista Optics & Photonics News, da Sociedade Óptica da América. O glaucoma é uma degeneração da cabeça do nervo óptico que leva a uma perda de campo visual permanente e irreversível no indivíduo. É a segunda causa de cegueira no mundo, respondendo por 12% dos casos, ficando atrás apenas da catarata (48%).

O glaucoma é uma degeneração da cabeça do nervo óptico que leva a uma perda de campo visual permanente e irreversível no indivíduo. É a segunda causa de cegueira no mundo, respondendo por 12% dos casos, ficando atrás apenas da catarata (48%). Um e-mail com suposto conteúdo erótico está roubando senhas de jogadores no game “World of warcraft”. O alerta é da empresa de segurança britânica Sophos, que afirma que um programa malicioso contido na mensagem consegue enviar dados completos das contas para os criminosos.

Um e-mail com suposto conteúdo erótico está roubando senhas de jogadores no game “World of warcraft”. O alerta é da empresa de segurança britânica Sophos, que afirma que um programa malicioso contido na mensagem consegue enviar dados completos das contas para os criminosos. A princípio você pode pensar que há algum mal contato gerando ruído nas caixas de som do seu computador. Mas é só esperar um pouco e as coisas parecem começar a fazer algum sentido musical. E algumas das músicas são de fato interessantes.

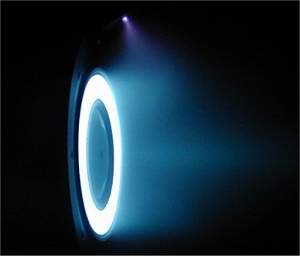

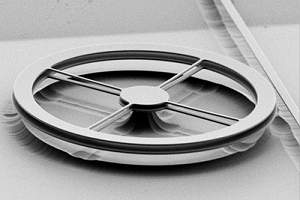

A princípio você pode pensar que há algum mal contato gerando ruído nas caixas de som do seu computador. Mas é só esperar um pouco e as coisas parecem começar a fazer algum sentido musical. E algumas das músicas são de fato interessantes. Um motor espacial com pouco mais de um centímetro de diâmetro e cujo funcionamento se baseia em nanopartículas milhares de vezes menores do que o diâmetro de um fio de cabelo humano, pode ser a solução que faltava para viabilizar os nanossatélites.

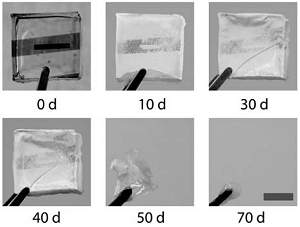

Um motor espacial com pouco mais de um centímetro de diâmetro e cujo funcionamento se baseia em nanopartículas milhares de vezes menores do que o diâmetro de um fio de cabelo humano, pode ser a solução que faltava para viabilizar os nanossatélites. Pesquisadores criaram transistores totalmente biodegradáveis e os utilizaram para construir circuitos eletrônicos que poderão ser utilizados como implantes temporários para o corpo humano.

Pesquisadores criaram transistores totalmente biodegradáveis e os utilizaram para construir circuitos eletrônicos que poderão ser utilizados como implantes temporários para o corpo humano. A simples menção à palavra bateria traz à mente os telefones celulares, os tocadores de MP3, as câmeras digitais e toda uma parafernália de equipamentos eletrônicos portáteis.

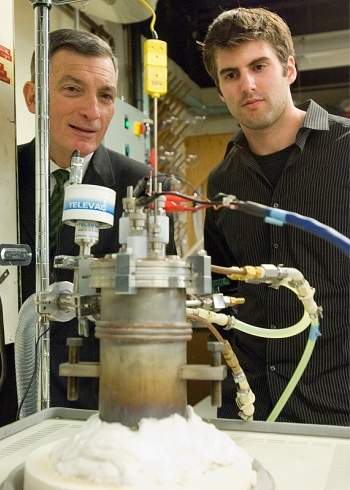

A simples menção à palavra bateria traz à mente os telefones celulares, os tocadores de MP3, as câmeras digitais e toda uma parafernália de equipamentos eletrônicos portáteis. Quando se fala em tecnologia espacial e em projetos envolvendo a NASA geralmente se imagina grandes equipes de engenheiros e cientistas super especializados, trabalhando com orçamentos na casa dos muitos milhões de dólares.

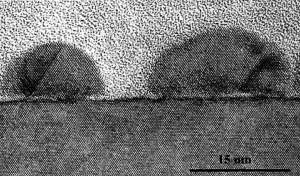

Quando se fala em tecnologia espacial e em projetos envolvendo a NASA geralmente se imagina grandes equipes de engenheiros e cientistas super especializados, trabalhando com orçamentos na casa dos muitos milhões de dólares. Engenheiros da Universidade da Carolina do Norte, nos Estados Unidos, sintetizaram um novo material com potencial para aumentar a densidade de armazenamento das memórias de computador e para aumentar a temperatura de funcionamento dos motores de carros, permitindo que eles consumam menos combustível.

Engenheiros da Universidade da Carolina do Norte, nos Estados Unidos, sintetizaram um novo material com potencial para aumentar a densidade de armazenamento das memórias de computador e para aumentar a temperatura de funcionamento dos motores de carros, permitindo que eles consumam menos combustível. Os endoscópios tradicionais permitem que os médicos deem uma espiada no interior do corpo dos pacientes.

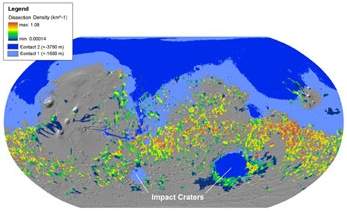

Os endoscópios tradicionais permitem que os médicos deem uma espiada no interior do corpo dos pacientes. Uma pesquisa realizada nos Estados Unidos traz novos indícios de que o planeta Marte já teve um oceano.

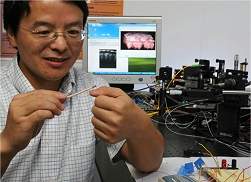

Uma pesquisa realizada nos Estados Unidos traz novos indícios de que o planeta Marte já teve um oceano. Um cientista brasileiro, atualmente na Universidade de Cornell, nos Estados Unidos, utilizou um feixe de luz com apenas 1 miliwatt de potência para mover objetos de silício, abrindo caminho para que nanomecanismos possam ser movimentados a partir de fontes externas de energia.

Um cientista brasileiro, atualmente na Universidade de Cornell, nos Estados Unidos, utilizou um feixe de luz com apenas 1 miliwatt de potência para mover objetos de silício, abrindo caminho para que nanomecanismos possam ser movimentados a partir de fontes externas de energia. A prototipagem rápida não conquistou seu lugar na indústria, nos escritórios de projetos e até no meio artístico por acaso: a possibilidade de fabricar peças complexas a partir de um desenho em computador acelera o desenvolvimento de novos produtos e permite que peças únicas ou em pequenos lotes sejam fabricadas rapidamente e a um custo muito baixo.

A prototipagem rápida não conquistou seu lugar na indústria, nos escritórios de projetos e até no meio artístico por acaso: a possibilidade de fabricar peças complexas a partir de um desenho em computador acelera o desenvolvimento de novos produtos e permite que peças únicas ou em pequenos lotes sejam fabricadas rapidamente e a um custo muito baixo. Uma xícara de chá de um tipo de hortelã tem propriedades analgésicas equivalentes às de alguns remédios vendidos comercialmente, concluiu um estudo feito na Grã-Bretanha por uma pesquisadora brasileira.

Uma xícara de chá de um tipo de hortelã tem propriedades analgésicas equivalentes às de alguns remédios vendidos comercialmente, concluiu um estudo feito na Grã-Bretanha por uma pesquisadora brasileira. Um rejeito da fabricação da vacina da coqueluche promete aumentar a produção de vacinas no Brasil e ainda baratear consideravelmente os custos.

Um rejeito da fabricação da vacina da coqueluche promete aumentar a produção de vacinas no Brasil e ainda baratear consideravelmente os custos.