A redução da ingestão calórica, especialmente na forma de glicose, aumenta a vida útil das células humanas.

A redução da ingestão calórica, especialmente na forma de glicose, aumenta a vida útil das células humanas.Esta é a conclusão de uma pesquisa inédita que acaba de ser publicada no periódico médico FASEB Journal.

Células que vivem mais

Segundo os pesquisadores da Universidade do Alabama, nos Estados Unidos, pegar uma segunda sobremesa pode ser uma má estratégia para quem se interessa em ter uma vida longa e livre do câncer.

Isto porque, conforme eles agora mostraram com precisão, as dietas com poucas calorias - especificamente na forma de glicose - ajudam as células humanas a viver mais.

Vida e morte celular

No estudo, os cientistas usaram células normais e células pré-cancerosas de pulmão humano. Estas últimas estavam em estágios iniciais da formação do câncer.

Os dois conjuntos de células foram cultivados em laboratório e separadas em grupos que receberam doses normais ou reduzidas de glicose (açúcar).

Conforme as células cresceram durante algumas semanas, os pesquisadores monitoraram a sua capacidade de se dividir e o número de células que sobreviviam durante este período.

Eles descobriram que, quando receberam doses menores de glicoses, as células normais viveram mais tempo, e muitas das células pré-cancerosas morreram.

Efeitos epigenéticos

A atividade genética também foi medida nas mesmas condições. A redução da glicose fez com que as células normais tivessem uma maior atividade do gene que determina o nível de telomerase, uma enzima que aumenta a vida útil das células, e uma menor atividade de um gene (p16) que retarda o seu crescimento.

Efeitos epigenéticos (efeitos não devidos a mutações genéticas) foram a principal causa na alteração da atividade desses genes conforme eles reagiam aos menores níveis de glicose.

Fonte da juventude farmacêutica

"A ciência ocidental está à beira de desenvolver uma fonte farmacêutica da juventude", disse Gerald Weissmann, comentando a pesquisa. "Este estudo confirma que estamos na trilha certa para convencer as células humanas a deixar-nos a viver por mais tempo e, talvez, livres do câncer."

"Nossa esperança é que a descoberta de que menos calorias estendem a vida útil das células humanas normais levará a novas descobertas sobre as causas para estes efeitos em diferentes tipos de células e facilite o desenvolvimento de novas abordagens para prolongar a vida dos seres humanos", disse Trygve Tollefsbol, um dos autores do estudo.

"Nós também podemos esperar que estes estudos levem a melhorias na prevenção do câncer, assim como de muitas outras doenças relacionadas com a idade, por meio do controle da absorção de calorias pelos vários tipos de células específicas," conclui ele.

Uma pessoa é abordada na rua por um vendedor que oferece a assinatura de uma revista por três meses grátis.

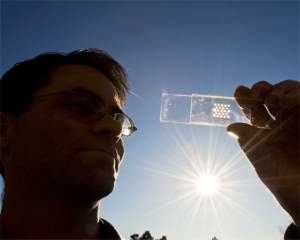

Uma pessoa é abordada na rua por um vendedor que oferece a assinatura de uma revista por três meses grátis. Cientistas do Laboratório Sandia, dos Estados Unidos, criaram um novo tipo de célula solar que, mais do que nenhuma outra, merece de fato ser chamada de "célula."

Cientistas do Laboratório Sandia, dos Estados Unidos, criaram um novo tipo de célula solar que, mais do que nenhuma outra, merece de fato ser chamada de "célula." Por mais que um robô possa se parecer com um ser humano, basta se aproximar dele para ouvir as diferenças: robôs são feitos com motores e engrenagens e, como toda máquina, fazem um bocado de barulho quando se movimentam.

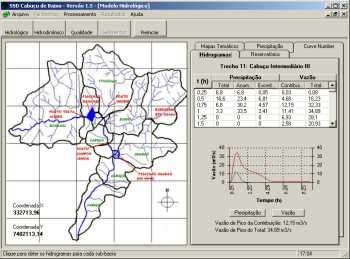

Por mais que um robô possa se parecer com um ser humano, basta se aproximar dele para ouvir as diferenças: robôs são feitos com motores e engrenagens e, como toda máquina, fazem um bocado de barulho quando se movimentam. Enchentes e deslizamentos, que acontecem principalmente em épocas de chuvas, podem ser minimizados se os administradores públicos tiverem em mãos ferramentas que os auxiliem a prever cenários futuros e a tomarem decisões mais precisas.

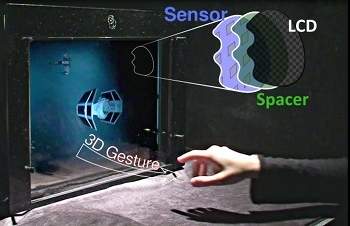

Enchentes e deslizamentos, que acontecem principalmente em épocas de chuvas, podem ser minimizados se os administradores públicos tiverem em mãos ferramentas que os auxiliem a prever cenários futuros e a tomarem decisões mais precisas. Um monitor de LCD comum pode ser modificado para "ver" o mundo à sua frente, em 3D.

Um monitor de LCD comum pode ser modificado para "ver" o mundo à sua frente, em 3D. Há vários conceitos interessantes e promissores sendo avaliados para tentar efetivar esse potencial, incluindo boias submarinas, hidroelétricas marinhas e até "cobras" de borracha.

Há vários conceitos interessantes e promissores sendo avaliados para tentar efetivar esse potencial, incluindo boias submarinas, hidroelétricas marinhas e até "cobras" de borracha. Engenheiros da Universidade de Duke, nos Estados Unidos, criaram uma nova geração de lentes até agora só prevista nas teorias.

Engenheiros da Universidade de Duke, nos Estados Unidos, criaram uma nova geração de lentes até agora só prevista nas teorias. Pesquisadores da Universidade Técnica de Munique, na Alemanha, apresentaram o protótipo de um novo motor diesel que, em comparação com os atuais, pode ser considerado praticamente isento de emissões.

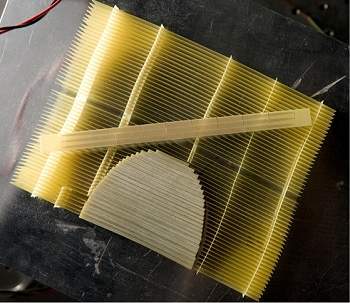

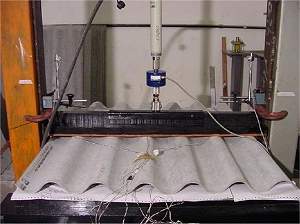

Pesquisadores da Universidade Técnica de Munique, na Alemanha, apresentaram o protótipo de um novo motor diesel que, em comparação com os atuais, pode ser considerado praticamente isento de emissões. As sobras da bucha de sisal, que geralmente são jogadas fora nos processos de fabricação de cordas, podem fornecer uma importante matéria-prima para a indústria de materiais de construção.

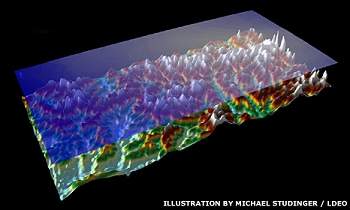

As sobras da bucha de sisal, que geralmente são jogadas fora nos processos de fabricação de cordas, podem fornecer uma importante matéria-prima para a indústria de materiais de construção. Cientistas que mapearam as mais enigmáticas cadeias de montanhas da Terra anunciaram algumas de suas descobertas em uma conferência realizada esta semana nos Estados Unidos.

Cientistas que mapearam as mais enigmáticas cadeias de montanhas da Terra anunciaram algumas de suas descobertas em uma conferência realizada esta semana nos Estados Unidos.

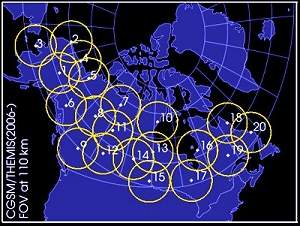

Uma rede de câmeras implantada em torno do Ártico, dando suporte à missão Themis da NASA, fez uma descoberta surpreendente sobre as auroras boreais.

Uma rede de câmeras implantada em torno do Ártico, dando suporte à missão Themis da NASA, fez uma descoberta surpreendente sobre as auroras boreais. O Brasil produz 30 mil toneladas anuais de isoladores elétricos de porcelana de alta e baixa tensão para distribuição de energia - equipamento utilizado como isolante de eletricidade em postes de iluminação, usinas hidrelétricas e, até mesmo em residências.

O Brasil produz 30 mil toneladas anuais de isoladores elétricos de porcelana de alta e baixa tensão para distribuição de energia - equipamento utilizado como isolante de eletricidade em postes de iluminação, usinas hidrelétricas e, até mesmo em residências. O creme dental com baixa concentração de flúor e um pH mais ácido, além de ajudar na prevenção de cáries, evita a ocorrência de fluorose em crianças.

O creme dental com baixa concentração de flúor e um pH mais ácido, além de ajudar na prevenção de cáries, evita a ocorrência de fluorose em crianças.