Se o monitor estiver ligado e você vir um ponto preto (que não deveria estar ali),é provável que todos os subpixels que o compõem esteja desligados permanentemente, num caso típico de pixel morto (dead pixel).

Na situação contrária, em que todos os subpixels ficam permanentemente ligados, o usuário irá notar um ponto branco na tela. Esta situação é denominada hot pixel. Uma situação intermediária, denominada stuck pixel, é aquela em que o pixel problemático exibe uma cor azulada (mas pode ser também vermelho ou verde, dependendo do subpixel que está ligado).

Alguns monitores já vêm com alguns pixels problemáticos de fábrica (em maior ou menor quantidade) e você pode pedir a substituição do equipamento na loja onde o comprou ou junto ao fabricante. Outros, contudo, aparecem durante o uso do equipamento, Quando em número menor, às vezes o usuário nem percebe sua presença. Mas com o passar do tempo, eles começam a incomodar. Felizmente, há maneiras de contornar esse problema.

Leia também:

>> O que fazer quando o computador se recusa a ligar?

>> 40 hábitos, produtos e serviços de TI que já morreram (ou quase)

>> Notebook: configuração do PC portátil lembra a do desktop

>> Cinco coisas que você deve fazer antes de usar um PC novinho

Primeiro, assegure-se que o LCD esteja bem limpo e livre de poeira (se puder contar com um jato de ar comprimido, melhor). Verifique no manual do fabricante que tipo de limpeza deve ser feita e siga-a.

Depois, assegure-se que o PC esteja exibindo imagens no display em resolução nativa – isso irá ajudá-lo na identificação dos pixels mais facilmente. Para isso, clique em Iniciar, Configurações, Painel de Controle, Vídeo e selecione a aba Configurações e selecione o ajuste ideal (o manual do monitor irá mostrar a configuração correta do seu equipamento).

Faça o download e instale o UDPixel para identificar e corrigir problemas. Este programa exige que você também tenha o .Net Framework instalado.

![]()

No UDPixel, aumente a opção Run Cycle para 4 segundos e clique em no botão Run cycle. Você verá o monitor alternar ciclicamente entre o vermelho, verde, azul, branco e amarelo.

Caso exista algum pixel travado, ele será visível em todos os ciclos de cores, com exceção naquele correspondente à cor que estiver travada. Clique no botão Stop para interromper o ciclo de testes. Para múltiplos pixels, incremente o intervalo de Flash (Flash interval) em um (1) para cada pixel encontrado.

Ou então, clique no botão Start. Um pequeno quadrado com 5 pixels de lado será exibido. Posicione-o sobre o pixel problemático e espera entre 15 e 20 minutos. Depois clique em Reset para desligar.

Feito isso, repita o processo do ciclo de cores para verificar se o pixel foi corrigido.

Se o problema persistir, verifique a garantia do seu monitor LCD. Em muitos casos é possível solicitar sua substituição.

Caso isso não seja possível, você pode tentar um processo mecânico, que costuma funcionar. Uma vez identificado o pixel em questão, desligue o monitor e, com a ponta de um objeto pontiagudo (como a caneta stylus de um PDA ou semelhante) envolvida em um pano macio, aplique uma leve pressão sobre o ponto por cerca de 5 a 10 segundos. Ligue o monitor novamente e verifique o pixel uma vez mais.

Se ainda houver pixles com problemas, repita a etapa anterior mais algumas vezes.

Na eventualidade desse procedimento não surtir efeito, dê leves batidas com a tampa arredondada de uma caneta (também envolvida em um pano macio e com o monitor desligado) no local onde o pixel problemático encontra-se. Repita isso algumas vezes antes de ligar o monitor novamente.

Enquanto as células solares orgânicas não se tornam mais duráveis e mais eficientes e as células solares de silício não se tornam mais baratas, a técnica mais atrativa para o aproveitamento da energia solar parece ser a exploração termossolar.

Enquanto as células solares orgânicas não se tornam mais duráveis e mais eficientes e as células solares de silício não se tornam mais baratas, a técnica mais atrativa para o aproveitamento da energia solar parece ser a exploração termossolar. Pesquisadores da USP de São Carlos estão criando ferramentas capazes de reduzir a complexidade linguística dos textos, substituindo palavras raras (menos frequentes) por palavras mais usuais e dividindo e reorganizando orações longas e complexas.

Pesquisadores da USP de São Carlos estão criando ferramentas capazes de reduzir a complexidade linguística dos textos, substituindo palavras raras (menos frequentes) por palavras mais usuais e dividindo e reorganizando orações longas e complexas. O departamento de pediatria do Hospital Universitário de Bruxelas, na Bélgica, desenvolveu um berço capaz de evitar a regurgitação, um problema estomacal que afeta um entre cada cinco bebês e pode causar irritação no esôfago.

O departamento de pediatria do Hospital Universitário de Bruxelas, na Bélgica, desenvolveu um berço capaz de evitar a regurgitação, um problema estomacal que afeta um entre cada cinco bebês e pode causar irritação no esôfago. Pesquisadores da Mayo Clinic, nos Estados Unidos, divulgaram que uma combinação tripla de medicamentos é uma opção promissora para o tratamento de câncer de mama HER2+ com metástase, com a vantagem adicional de não causar perda de cabelo.

Pesquisadores da Mayo Clinic, nos Estados Unidos, divulgaram que uma combinação tripla de medicamentos é uma opção promissora para o tratamento de câncer de mama HER2+ com metástase, com a vantagem adicional de não causar perda de cabelo. Pesquisadores da Universidade Huelva, na Espanha, desenvolveram uma graxa lubrificante para veículos e equipamentos industriais que não utiliza qualquer composto químico contaminante usado nos lubrificantes tradicionais.

Pesquisadores da Universidade Huelva, na Espanha, desenvolveram uma graxa lubrificante para veículos e equipamentos industriais que não utiliza qualquer composto químico contaminante usado nos lubrificantes tradicionais. Cientistas conseguiram obter, pela primeira vez, imagens detalhadas das estruturas químicas de uma molécula, em um estudo que pode auxiliar no desenvolvimento de produtos eletrônicos e até mesmo de remédios em escala molecular.

Cientistas conseguiram obter, pela primeira vez, imagens detalhadas das estruturas químicas de uma molécula, em um estudo que pode auxiliar no desenvolvimento de produtos eletrônicos e até mesmo de remédios em escala molecular. A revista Unesp Ciência é o mais novo veículo de divulgação científica no Brasil. A revista foi lançada nesta semana pela Universidade Estadual Paulista (Unesp) em cerimônia no campus Barra Funda, na capital paulista.

A revista Unesp Ciência é o mais novo veículo de divulgação científica no Brasil. A revista foi lançada nesta semana pela Universidade Estadual Paulista (Unesp) em cerimônia no campus Barra Funda, na capital paulista. Cientistas austríacos estabeleceram uma interação entre luz e um ressonador micromecânico que é forte o bastante para transferir efeitos quânticos para o mundo macroscópico.

Cientistas austríacos estabeleceram uma interação entre luz e um ressonador micromecânico que é forte o bastante para transferir efeitos quânticos para o mundo macroscópico. A couve refogada apresentou as maiores concentrações de flavonóis na pesquisa realizada nos laboratórios da Faculdade de Engenharia de Alimentos (FEA) com quatro tipos de hortaliças. Foram estudadas couve, brócolis, vagem e chicória.

A couve refogada apresentou as maiores concentrações de flavonóis na pesquisa realizada nos laboratórios da Faculdade de Engenharia de Alimentos (FEA) com quatro tipos de hortaliças. Foram estudadas couve, brócolis, vagem e chicória. Foi inaugurado nesta semana o Parque Eólico Praias de Parajuru, no Ceará, a primeira de um total de três usinas eólicas que serão construídas naquele estado.

Foi inaugurado nesta semana o Parque Eólico Praias de Parajuru, no Ceará, a primeira de um total de três usinas eólicas que serão construídas naquele estado. Pesquisadores europeus criaram uma plataforma para comercialização de recursos de processamento e armazenamento que permite a compra e a venda de recursos computacionais padronizados, uma espécie de commodity da era da informação.

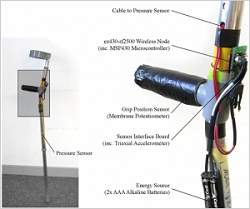

Pesquisadores europeus criaram uma plataforma para comercialização de recursos de processamento e armazenamento que permite a compra e a venda de recursos computacionais padronizados, uma espécie de commodity da era da informação. Engenheiros da Universidade de Southampton, na Inglaterra, desenvolveram uma muleta que incorpora uma avançada tecnologia de sensores para monitorar se o equipamento está sendo usado corretamente.

Engenheiros da Universidade de Southampton, na Inglaterra, desenvolveram uma muleta que incorpora uma avançada tecnologia de sensores para monitorar se o equipamento está sendo usado corretamente.