As multinacionais foram apresentadas ao Brasil como agentes do progresso e da

eficiência. O discurso convenceu parte da sociedade, que apoiou as privatizações. Mas o

que dizer dos escândalos que se sucedem nos EUA com empresas como a WorldCom,

que nos fazem lembrar o velho gangsterismo.

A atual estratégia econômica brasileira tem tido como seu vetor central a atração de

capital estrangeiro, quer financeiro, quer especulativo, quer de investimento direto.

Essa política de atração de capitais se implementou através de um programa de

privatizações generoso para com o capital estrangeiro; pela equalização da empresa

estrangeira à empresa brasileira; pela eliminação de reservas de mercado; pela

liberalização da remessa de lucros, juros, royalties para o exterior; pela eliminação de

requisitos de atuação, tais como índices de nacionalização, associação ao capital

brasileiro, metas de exportação; pela redução de tarifas de importação para

componentes; pela aprovação de legislação favorável aos detentores de patentes; pela

adoção, até 1999, de um câmbio quase-fixo.

As premissas que se encontravam por trás dessas decisões estratégicas eram de que o

investimento direto estrangeiro “modernizaria” a economia brasileira; ampliaria a

capacidade instalada; geraria novos e numerosos empregos; ampliaria a competição no

mercado interno; transferiria e geraria tecnologia; contribuiria para o controle da inflação;

transformaria o Brasil em uma plataforma exportadora e, ademais, de que haveria

abundância duradoura de capital no mundo.

O ingresso da poupança externa permitiria elevar a taxa de investimento da economia

sem ter o governo de executar políticas internas de aumento de poupança privada e

pública, por vezes de difícil execução, e que podem encontrar sérios obstáculos políticos.

Por outro lado, a política de atração de capitais estrangeiros julgou necessária a

desregulamentação da economia na área interna e externa, que corresponderia, na

prática, a uma “abdicação” do Estado de sua competência para executar políticas de

desenvolvimento. Assim, o destino do desenvolvimento econômico brasileiro e a remoção

de estrangulamentos internos à integração da economia e de obstáculos externos à

expansão das exportações passaram a depender das megaempresas multinacionais e do

“livre” jogo das forças de mercado. O destino da sociedade brasileira passou a depender

da disponibilidade mundial de capital e das decisões estratégicas globais dessas

megaempresas, cuja preocupação com o progresso da sociedade brasileira ou de qualquer

outra sociedade periférica é uma preocupação marginal no contexto de suas estratégias

globais, como hoje bem demonstra a catástrofe argentina.

Essa estratégia teve resultados inesperados para seus formuladores e executores. Os

investimentos estrangeiros dirigiram-se principalmente à aquisição de empresas estatais e

de empresas privadas, com pequeno efeito sobre o aumento da capacidade instalada. A

“modernização” da produção não se traduziu em maior capacidade competitiva dos

produtos brasileiros em nível internacional, pois as exportações brasileiras de produtos de

maior valor agregado não cresceram, assim como não cresceram as nossas exportações

de produtos dos chamados setores dinâmicos da economia mundial.

Não houve aumento significativo de geração de tecnologia no Brasil e, pelo contrário, vários centros de pesquisa, tanto de empresas estatais privatizadas como de empresas privadas desnacionalizadas, vieram a ser desativados pelos novos proprietários. A parcela mais significativa do capital estrangeiro foi investida em empresas de serviços, tais como telefonia, bancos e supermercados, que foram privatizadas ou desnacionalizadas e que se tornaram por vezes grandes importadoras, sem gerar exportações. O ingresso das megaempresas aumentou a oligopolização dos mercados e, portanto, a possibilidade de praticar preços abusivos. A contribuição das empresas estrangeiras para o controle da inflação não se verificou como esperava o governo, e até pelo contrário, devido ao aumento significativo de tarifas de empresas privatizadas na área de serviços como telefonia, energia elétrica, rodovias etc.

A contribuição do capital estrangeiro para a construção da infra-estrutura brasileira tem

sido insuficiente. De um lado, a crise de energia (cujos graves efeitos ainda não se

manifestaram plenamente e cujas causas ainda não foram inteiramente superadas)

dispensa comentários. Mas a ela se juntam hoje as dificuldades das empresas de telefonia

e das ferrovias que solicitam apoio financeiro estatal de toda ordem. O “seguro apagão” é

um caso clamoroso, em que os consumidores brasileiros pagam antecipadamente para que

não ocorra um “apagão”, arcando com as conseqüências do “desgoverno” energético.

A crise atual do modelo econômico brasileiro resulta de que suas premissas não se

verificaram, em especial duas. A primeira, que os investimentos diretos estrangeiros

eventualmente gerariam exportações e um volume de divisas capaz de compensar uma

parte substancial das despesas com os itens de transações correntes. Caso esta

premissa não se verificasse, a segunda e implícita premissa era de que haveria uma

massa de capital disponível no mercado mundial sempre interessada em refinanciar o

Brasil, desde que os fundamentos fiscais internos fossem sólidos. Em resumo, acreditavam

e continuam acreditando os autores dessa estratégia que desde que exista um superávit

primário capaz de fazer face a boa parte do serviço da dívida do Estado, quase tudo se

resolve.

Assim, a política econômica poderia se limitar a gerar superávits primários custasse o que

custasse, criando novos tributos e cortando despesas. Necessidades adicionais de

financiamento seriam atendidas colocando títulos públicos ainda que a taxas

astronômicas de juros. Mas, este superávit primário se verifica em reais e não em dólares,

e é útil para servir a dívida em reais, enquanto que o serviço dos capitais externos, as

amortizações e as importações devem ser pagos em dólares.

A política para alcançar um superávit primário substancial levou à estagnação da

economia, ao desemprego, à violência, à marginalização, à precariedade da

infra-estrutura física (estradas, saneamento, energia etc) e social (escolas, hospitais

etc). Portanto, tornaram a economia menos atraente para os investimentos diretos e até

mesmo para os capitais especulativos. A incerteza quanto à capacidade de saldar

compromissos na área externa, devido à demanda crescente por dólares e insuficiente

oferta, leva a flutuações cambiais significativas, mas sempre com viés de alta e,

portanto, à incerteza para os investidores estrangeiros quanto à conversão da sua

remuneração em reais para fim de remessa.

A incerteza na área interna quanto à capacidade do governo de honrar os compromissos

com a dívida interna leva à necessidade de oferecer juros elevados e prazos curtos para

poder “rolar” a dívida, isto é, colocar novos títulos. As taxas elevadas desestimulam os

investimentos produtivos e provocam a estagnação da economia. Esta é a armadilha

fiscal/cambial/social em que o governo colocou a sociedade brasileira para criar os

“sólidos fundamentos” da economia, hoje simplesmente ignorados pelas agências de risco

e os megabancos.

Agora, surge um novo aspecto de interesse para a questão do investimento direto. O

capital estrangeiro direto, em especial as megaempresas multinacionais, foram

apresentados à sociedade brasileira como agentes da modernidade, do progresso, da

competição, da eficiência e, ademais, last but not least, como diriam os anglófilos, de

seriedade e honestidade empresarial. Seus executores seriam uma espécie de semideuses

modernos diante de seus congêneres tupiniquins. Essa competência profissional, essa

dedicação à empresa, essa honestidade de comportamento é que explicariam também a

eficiência daquelas megaempresas e sua superioridade quando comparadas às empresas

nativas.

Os escândalos se sucedem nos Estados Unidos: Enron, World Com, Xerox, Adelphia,

Kmart, Lucent, Tyco, Vivendi etc. etc. etc. Sua característica central é o gangsterismo

sofisticado dos executivos que manipularam a contabilidade, inflaram lucros, promoveram

a alta dos preços das ações, receberam ações, venderam essas ações e enriqueceram

enquanto suas supostas “eficientíssimas” empresas, um “exemplo” para as empresas e

empresários brasileiros, iam à falência, assim como se evaporavam as poupanças dos

pequenos investidores e os empregos dos trabalhadores, eternas vítimas.

Essas operações contaram com a conivência de gigantescas empresas de auditoria que,

aliás, prestavam consultoria àquelas mesmas empresas e a seus executivos e de enormes

corretoras de valores, como a famosa Merryl Lynch. É de se esperar que a contabilidade

das filiais dessas empresas estrangeiras no Brasil não utilize as mesmas práticas de

maquilagem contábil, com o auxílio daquelas mesmas firmas de auditoria que queimaram

documentos para dificultar investigações e que a Comissão de Valores Mobiliários (CVM)

seja mais eficiente do que a SEC (Security and Exchange Commission) diante das mágicas

de contabilidade e de auditoria das filiais dessas empresas no Brasil ...

Esses escândalos parecem cada vez mais revelar uma corrupção sistêmica de que

participam executivos que se movem das megaempresas para a Administração, da

Administração para o FMI /Bird e que levou a um recorde de 368 concordatas em 2001 e

2002 que atingem centenas de bilhões de dólares. E acadêmicos e funcionários de

agências internacionais, cuja competência o Prêmio Nobel Stiglitz considera reduzida,

volta e meia ousam propor a administração direta, por esse tipo de especialistas

estrangeiros “honestos e eficientes”, da economia de países periféricos.

Todavia, foram esses mesmos peritos, acadêmicos, executivos que levaram às crises ao

“propor” e insistir em políticas desastrosas nos países da periferia. Hoje, acham que os

economistas e dirigentes locais não teriam a elevada competência e a honestidade

necessária para conduzir a política econômica de seus países...

A ONG Transparência Internacional poderia bem se ocupar de reavaliar os seus índices e

classificação de países para que reflitam a megacorrupção que ocorre nos Estados

Unidos, com efeitos muito mais severos para a economia mundial, e por conseqüência

para as economias periféricas, ao invés de enfatizar a ocorrência de corrupção nos países

periféricos, cujos dirigentes, aliás, aceitam propinas muitas vezes dessas mesmas

megaempresas envolvidas hoje em escândalos de megacorrupção.

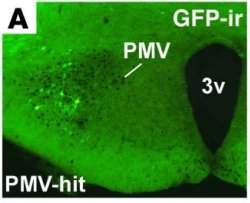

Um grupo coordenado pela neurocientista brasileira Carol Elias deu um passo importante para desvendar os mecanismos bioquímicos de um fenômeno que vem alarmando os médicos: a antecipação da puberdade feminina.

Um grupo coordenado pela neurocientista brasileira Carol Elias deu um passo importante para desvendar os mecanismos bioquímicos de um fenômeno que vem alarmando os médicos: a antecipação da puberdade feminina.

Depois de 10 anos de planejamento, testes de equipamentos e construção, está terminado o Observatório de Neutrinos IceCube.

Depois de 10 anos de planejamento, testes de equipamentos e construção, está terminado o Observatório de Neutrinos IceCube. Um dos desafios dos profissionais envolvidos com a recuperação de pacientes com queimaduras é abreviar o tempo de internação para evitar complicações infecciosas.

Um dos desafios dos profissionais envolvidos com a recuperação de pacientes com queimaduras é abreviar o tempo de internação para evitar complicações infecciosas. Sob as condições adequadas - que incluem um feixe de laser de ultra-alta intensidade e um acelerador de partículas de dois quilômetros de extensão - pode ser possível criar algo do nada.

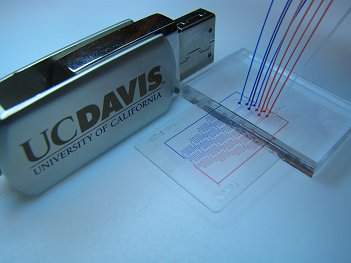

Sob as condições adequadas - que incluem um feixe de laser de ultra-alta intensidade e um acelerador de partículas de dois quilômetros de extensão - pode ser possível criar algo do nada. Dispositivos microfluídicos, como os biochips e os microarrays usam canais microscópicos, escavados em plástico ou vidro, para realizar análises biológicas ou químicas com uma precisão e uma velocidade que não são possíveis com os equipamentos tradicionais.

Dispositivos microfluídicos, como os biochips e os microarrays usam canais microscópicos, escavados em plástico ou vidro, para realizar análises biológicas ou químicas com uma precisão e uma velocidade que não são possíveis com os equipamentos tradicionais. O Google, maior site de buscas do mundo, desenvolveu um novo aplicativo que permite explorar o corpo humano em detalhe, o Google Body Browser.

O Google, maior site de buscas do mundo, desenvolveu um novo aplicativo que permite explorar o corpo humano em detalhe, o Google Body Browser. Se você quiser uma projeção verdadeiramente realística, muito além das imagens geradas nas melhores salas de cinema digital, é melhor apelar para um projetor a laser.

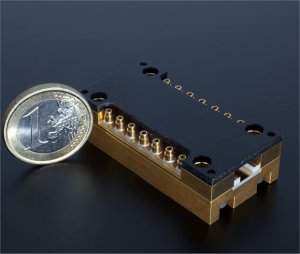

Se você quiser uma projeção verdadeiramente realística, muito além das imagens geradas nas melhores salas de cinema digital, é melhor apelar para um projetor a laser.