A tecnologia digital fácil de usar tornará mais difícil distorcer a história no futuro.

Na próxima terça-feira, um grupo de pesquisadores da Universidade de Washington divulgará o componente inicial de um sistema público para oferecer autenticação a um arquivo de entrevistas em vídeo com os promotores e outros membros do Tribunal Criminal Internacional do genocídio de Ruanda. O grupo também liberará a primeira parte dos arquivos do arquivo ruandês.

Esse sistema pretende estar disponível para uso futuro em preservação digital e autenticação de prestações de contas em primeira mão de crimes de guerra, atrocidades e genocídios.

Tais ferramentas são de vital importância, pois se tornou possível alterar texto, vídeo e áudio digitais de maneiras virtualmente invisíveis a olhos e ouvidos humanos.

Os pesquisadores dizem que a história estava repleta de incidentes de registros escritos envolvendo tratar, deletar e negar. Agora, dizem eles, a autenticidade de documentos digitais como vídeos, transcrições de explicações pessoais e registros de tribunais podem ser incontestavelmente provados pela primeira vez.

"A analogia mais próxima são as histórias revisionistas do Holocausto, onde há afirmações sobre pessoas que não foram colocadas em campos, e sim em fornos", disse Batya Friedman, professora de ciência da computação da Escola de Informação na Universidade de Washington.

Projetar sistemas digitais que podem preservar a informação por muitas gerações é um dos mais incômodos desafios da engenharia. A solução dos pesquisadores é criar uma impressão digital disponível publicamente, conhecida como marca hash criptografada, que tornará possível a qualquer um determinar quais documentos são autênticos e não foram alterados. O conceito de uma marca hash digital foi iniciado na IBM por Hans Peter Luhn, no início dos anos 50. Os pesquisadores da Universidade de Washington são os primeiros a tentar simplificar o aplicativo para usuários não-técnicos e tentar oferecer um sistema completo que preservaria a informação através de gerações.

Tanto pelo rápido passo da inovação, quanto pela tendência dos computadores de se tornarem obsoletos em meses ou anos, a probabilidade de que arquivos digitais sejam legíveis por longos períodos de tempo é muito menos certa até mesmo do que a sobrevivência dos documentos de papel. Os processadores de computador são rapidamente substituídos por modelos incompatíveis, programas de software são desenvolvidos com novos formatos de dados, e mídias de armazenamento digital, sejam fitas digitais, discos magnéticos ou chips de memória de estado sólido, são todas efêmeras demais.

Muitos tecnólogos já estão lutando com a natureza transitória dos arquivos digitais.

Danny Hillis, cientista de computadores, ajudou a fundar o projeto Long Now, em 1996, advertindo sobre a possibilidade de uma "era negra digital". O grupo agora está projetando um relógio que irá "fazer tique-taque" anualmente e é desenhado para ter um ciclo de vida de 10.000 anos. A intenção é que ele seja um contraponto ao ethos "mais rápido/mais barato" do cada vez mais computadorizado mundo atual.

Hillis argumentou que, antes do crescimento da informação digital, as pessoas valorizavam os documentos de papel e gostavam deles. Desde então, se presta cada vez menos atenção à preservação de informações. Hoje a informação é rotineiramente armazenada em mídias que podem durar apenas alguns anos.

Com essa finalidade, outro cientista da computação, Brewster Kahle, fundou em 1996 o Arquivo de Internet, num esforço para preservar um registro completo da World Wide Web e outros documentos digitais. Similarmente, bibliotecários da Universidade de Stanford criaram, em 2000, o LOCKSS, ou Lots of Copies Keep Stuff Safe (Montes de Cópias Mantêm as Coisas Seguras, tradução livre), para preservar jornais na era digital, espalhando cópias digitais de documentos por uma comunidade internacional de bibliotecas via internet.

Entretanto, Friedman distingue seu projeto daqueles que focaram na simples preservação de materiais digitalizados. Ao invés disso, ela disse estar tentando desenhar sistemas digitais completos, que desempenhariam um papel em fortalecer instituições sociais ao longo do tempo ao criar um registro histórico digital que oferecesse continuidade através de ciclos de vida múltiplos.

"Construir um relógio é simbólico", disse ela. "O que é realmente diferente é que estamos tentando solucionar problemas socialmente significativos do mundo real."

Já que problemas como genocídios, HIV e AIDS, fome, desmatamento e aquecimento global não serão resolvidos num único período de vida humano, ela argumenta que os sistemas de informação projetados para assegurar a continuidade por muitas gerações são uma necessidade.

Para fundamentar a pesquisa do grupo numa situação do mundo real, os pesquisadores começaram construindo um arquivo de entrevistas em vídeo com os juízes, promotores e outros membros do Tribunal Criminal Internacional para Ruanda. O objetivo era criar um sistema que asseguraria a segurança das informações por mais de um século.

No último outono, Friedman viajou com um grupo de peritos legais e cineastas a Arusha, na Tanzânia, onde está baseado o tribunal, e a Kigali, na Ruanda, para gravar entrevistas em vídeo.

Após capturar cinco gigabytes de vídeo em 49 entrevistas, o grupo começou a trabalhar num sistema que permitisse aos espectadores provar, por eles mesmos, que os vídeos não foram alterados, mesmo sem dispor de equipamentos poderosos de computação ou uma conexão de alta velocidade à internet.

Apesar do fato de haver aplicativos comerciais que possibilitam provar a hora em que um documento foi criado e verificar possíveis alterações, os pesquisadores queriam desenvolver um sistema disponibilizado de forma gratuita e que tivesse alguma chance de sobreviver a repetidas trocas de tecnologia.

No coração do sistema há um algoritmo usado para computar um número de 128 dígitos conhecido como um hash criptografado da informação digital num certo documento. Mesmo a menor mudança no documento original resultará num novo valor de hash.

Nos últimos anos, pesquisadores começaram a encontrar falhas nos algoritmos de hash atuais – então, em novembro último, o Instituto Nacional de Padrões e Tecnologia iniciou uma competição para criar tecnologias mais fortes de hash. Pesquisadores da Universidade de Washington agora usam um algoritmo moderno chamado SHA-2, mas projetaram o sistema de forma que ele possa ser facilmente substituído por um algoritmo mais avançado.

Seu sistema será distribuído como parte de um CD conhecido como "live CD", permitindo que ele compute ou verifique o hash apenas inserindo o disco num computador. O disco também incluirá componentes de software que tornarão possível visualizar documentos e vídeos que poderão não ser acessíveis a softwares futuros.

O problema é complexo, diz Michael Lesk, professor do departamento de biblioteca e ciência da informação da Universidade Rutgers, porque você precisa ser capaz de provar não só que a informação não mudou em seu formato original, mas também que, se o formato for alterado, o hash digital original ainda seja válido.

A Fundação Long Now está desenvolvendo uma ferramenta de software para converter facilmente documentos entre formatos digitais, diz Stewart Brand, co-fundador do projeto.

"A ideia é conseguirmos transformar qualquer coisa em qualquer outra coisa", diz ele.

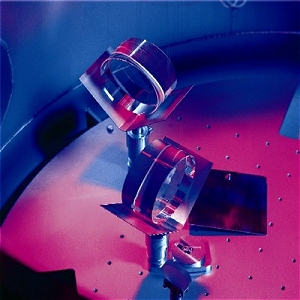

Há sete anos, os cientistas do experimento GEO600, instalado na Alemanha, vêm procurando por ondas gravitacionais. Eles ainda não encontraram nenhuma, mas podem ter feito, por acaso, uma das maiores descobertas da física nos últimos 50 anos.

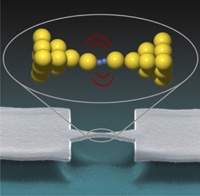

Há sete anos, os cientistas do experimento GEO600, instalado na Alemanha, vêm procurando por ondas gravitacionais. Eles ainda não encontraram nenhuma, mas podem ter feito, por acaso, uma das maiores descobertas da física nos últimos 50 anos. Um pesquisador holandês criou a menor chave mecânica possível de ser fabricada, além de um novo tipo de chave eletrônica de um tipo que nunca havia sido demonstrado.

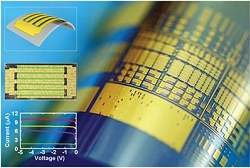

Um pesquisador holandês criou a menor chave mecânica possível de ser fabricada, além de um novo tipo de chave eletrônica de um tipo que nunca havia sido demonstrado. Engenheiros criaram um novo material sensível à luz, totalmente flexível, que poderá revolucionar a fotografia e outras tecnologias de imageamento, eliminando a necessidade das enormes lentes telescópicas dos equipamentos profissionais e acabando com as imagens borradas e fora de foco dos equipamentos mais simples.

Engenheiros criaram um novo material sensível à luz, totalmente flexível, que poderá revolucionar a fotografia e outras tecnologias de imageamento, eliminando a necessidade das enormes lentes telescópicas dos equipamentos profissionais e acabando com as imagens borradas e fora de foco dos equipamentos mais simples. Pesquisa realizada na Faculdade de Ciências Farmacêuticas de Ribeirão Preto (FCFRP) da USP demonstrou que o extrato bruto etanólico e o princípio ativo isolado da casca do caule de Lafoensia pacari, popularmente conhecida como dedaleira - planta típica do cerrado brasileiro, é popularmente conhecida - têm ação anti-inflamatória na asma.

Pesquisa realizada na Faculdade de Ciências Farmacêuticas de Ribeirão Preto (FCFRP) da USP demonstrou que o extrato bruto etanólico e o princípio ativo isolado da casca do caule de Lafoensia pacari, popularmente conhecida como dedaleira - planta típica do cerrado brasileiro, é popularmente conhecida - têm ação anti-inflamatória na asma. Os protótipos dos satélites artificiais CBERS-3 e 4 começaram a ser testados na China. Os testes deverão durar até Abril deste ano. Os dois satélites têm lançamentos previstos para 2010 e 2013, respectivamente.

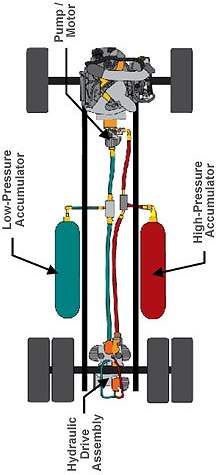

Os protótipos dos satélites artificiais CBERS-3 e 4 começaram a ser testados na China. Os testes deverão durar até Abril deste ano. Os dois satélites têm lançamentos previstos para 2010 e 2013, respectivamente. Saem câmbio, eixos cardã e outros sistemas de transmissão. Em seu lugar, entram sistemas hidráulicos, que levam a força do motor até as rodas por meio de fluidos sob pressão.

Saem câmbio, eixos cardã e outros sistemas de transmissão. Em seu lugar, entram sistemas hidráulicos, que levam a força do motor até as rodas por meio de fluidos sob pressão.