Em busca de uma alternativa para a matriz energética mundial, muitos cientistas acreditam que só a energia das estrelas pode representar um passo decisivo para a humanidade.

Às voltas com a sujeira e os riscos causados pela fissão nuclear, ainda debatendo se os biocombustíveis valem a pena ou não, o mundo se vê às voltas com uma matriz essencialmente baseada no petróleo e seus parentes próximos, o carvão e o gás natural.

Para achar uma saída desse beco, as duas únicas tecnologias com potencial disruptivo são a fotossíntese artificial e a fusão nuclear.

Os experimentos com folhas artificiais estão apenas começando. Mas o homem sonha em domar a fusão nuclear desde que Hans Bethe explicou de onde as estrelas tiravam tanta energia.

Tentativas de produzir a fusão nuclear

A primeira tentativa de produzir a fusão nuclear na Terra não é de boa lembrança: em 1º de Novembro de 1952, os Estados Unidos usaram uma bomba similar à usada em Hiroshima apenas para dar a ignição na primeira bomba de hidrogênio. Funcionou, mas a coisa se mostrou tão perigosamente descontrolada que o projeto foi deixado de lado.

O recorde mundial de fusão nuclear hoje pertence ao reator tokamak do JET (Joint European Torus), no Reino Unido. Com 15 metros de diâmetro e 12 metros de altura, ele consumiu 20 MW para produzir 16 MW - mas a fusão nuclear se sustentou por menos de 10 segundos.

Hoje, todos os esforços para bater esse recorde e gerar energia são pacíficos - ao menos os que se conhece. E os projetos de fusão nuclear não são mais exclusividade dos governos e suas universidades: já há empresas privadas trabalhando na área.

ITER

O maior desses esforços é o ITER, sigla em inglês de Reator Internacional Termonuclear Experimental, que começou a ser erguido em Cadarache, na França.

Com um investimento planejado de US$21 bilhões, o projeto pretende consumir 50 50 megawatts (MW) de energia para dar partida em uma produção de 500 MW. Em 2027, se tudo der certo.

O problema é que ninguém sabe se vai dar certo. Muitos físicos dizem que não vai funcionar. Outros afirmam que o ITER funcionará como um excelente laboratório de física, mas nunca será uma usina de geração de energia eficiente.

É hora de descobrir como o Universo faz as coisas explodirem

O ITER usará um reator do tipo tokamak, que usa um gigantesco campo magnético para confinar um plasma que deverá atingir uma temperatura de 45 milhões de graus Celsius para dar partida na fusão de deutério-trício.

Se funcionar, um quilograma (kg) de combustível de fusão vai gerar tanta energia quanto 10 milhões de kg de carvão.

Outro experimento já atingiu 25 milhões de graus Celsius, ainda abaixo do ponto de partida da fusão. Mas os projetistas do ITER confiam em seu 18 gigantescos ímãs supercondutores, cada um pesando 360 toneladas, para confinar uma quantidade de plasma suficiente para chegar lá.

Ignitor

O Ignitor é um projeto conjunto entre a Itália e a Rússia, bem menos ambicioso que o ITER.

O Ignitor será na verdade uma versão ampliada do Alcator C-Mod, desenvolvido pela equipe do professor Bruno Coppi, do MIT.

O reator, que está sendo erguido nas proximidades de Moscou, terá aproximadamente o dobro do tamanho do Alcator, com uma câmara principal em forma de anel com 1,3 metro de diâmetro - a câmara do ITER terá 6,2 metros de diâmetro.

O Alcator não nasceu para gerar energia, mas como um laboratório para estudar as estrelas.

Ao longo dos anos, os cientistas foram aprimorando seus detalhes técnicos, a ponto de atingirem um estágio no qual eles acreditam ser viável usar a tecnologia para produzir temperaturas suficientes para iniciar a fusão nuclear.

Como estão trabalhando em uma área desconhecida, os cientistas parecem mais interessados em trocar experiências do que em competir. Evgeny Velikhov, responsável pelo lado russo do projeto, também é membro do conselho do ITER.

Mas o Dr. Coppi não se cansa de dizer, entrevista após entrevista, que, mesmo que o Ignitor nunca gere mais energia do que consumir, ainda assim a astrofísica terá muito a ganhar com o experimento.

Sterellator

O tokamak não é o único caminho para tentar domar a fusão nuclear.

O projeto Wendelstein 7-X, do Instituto Max Planck, da Alemanha, está construindo um reator de fusão do tipo stellarator - ele será o maior do mundo desse tipo.

Um tokamak é alimentado por uma corrente de plasma. Essa corrente fornece uma parte do campo magnético responsável por isolar o próprio plasma das paredes do reator. O grande problema é evitar as "disrupções", as instabilidades do plasma circulante pelo torus.

Um reator do tipo stellarator não tem corrente, eliminando de pronto o problema das instabilidades do plasma. Esse tipo de reator tem um desenho esquisito, mas também tem seus próprios problemas, como uma tendência a perder energia.

Cada stellarator foge à sua própria maneira do tipo "clássico", fazendo modificações e otimizações que tentam coibir os defeitos o obter um funcionamento contínuo.

O Wendelstein 7-X terá 50 bobinas supercondutoras, medindo 3,5 metros de altura cada uma, para gerar o campo magnético primário. Para completar o sistema de contenção do plasma será usada uma camada adicional com 20 bobinas planares, colocadas sobre as primeiras, que terão o papel adicional de permitir o controle da intensidade do campo magnético.

O conjunto todo é contido dentro de uma estrutura de 16 metros de diâmetro. Uma usina de refrigeração fornecerá 5.000 Watts de hélio líquido para manter a supercondução dos fios que formam as bobinas.

O Wendelstein 7-X será um reator de pesquisa, sem intenção de produzir energia. Na verdade, a intenção é demonstrar a viabilidade da construção de uma usina de fusão nuclear usando um reator do tipo stellarator. Se tudo ocorrer segundo o cronograma, o reator deverá entrar em funcionamento em 2014.

Fusão nuclear com laser

O projeto europeu Hiper (sigla em inglês de Pesquisa de Energia Laser de Alta Potência) pretende atingir as altas temperaturas necessárias para iniciar a fusão nuclear usando um equipamento de raio laser do tamanho de um estádio de futebol.

Um laser de alta potência vai comprimir átomos de hidrogênio para conseguir uma densidade 30 vezes maior do que a do chumbo.

Um segundo laser vai aumentar a temperatura do hidrogênio comprimido acima dos 100 mihões de graus Celsius - ao menos é o que os cálculos indicam.

Nessas condições, os núcleos do hidrogênio deverão se fundir para formar hélio.

Iniciado em 2008, o Hiper é financiado pela Comissão Europeia e envolve 26 instituições de dez países.

Motor de fusão

Os cientistas da empresa privada Helion Energy são bem mais comedidos do que seus parceiros institucionais.

Seu reator de fusão nuclear é um equipamento cilíndrico de 16 metros de comprimento e pouco mais de um metro de diâmetro.

Chamado de "motor de fusão", o reator não usará supermagnetos supercondutores mantidos em temperaturas criogênicas: ele usará um processo conhecido como configuração de campo reverso.

Em vez de confinar o plasma em uma estrutura toroidal, como no tokamak, o motor de fusão vai acelerar duas pequenas bolas de plasma uma em direção à outra.

Manter o plasma isolado em um aparato linear é muito mais simples do que o formato toroidal, exigindo um campo magnético menos intenso e mais fácil de controlar. É por isso que o reator é tão menor do que seus concorrentes.

Se os cálculos estiverem corretos, a colisão deverá gerar calor suficiente para fundir os núcleos dos átomos, aquecê-los e iniciar a fusão de forma sustentada.

Como a fusão ocorre em um ponto determinado no espaço é mais fácil também recolher os nêutrons gerados. Os nêutrons são essenciais para gerar o combustível da fusão.

E, se eles escaparem, podem tornar radioativas as peças metálicas do equipamento com as quais entrarem em contato - isso acontecerá no ITER, que deverá trocar as partes internas do seu reator periodicamente.

O protótipo do motor de fusão atingiu uma temperatura de 25 milhões de graus Celsius, bem abaixo do necessário. Mas os cientistas calculam que a temperatura necessária será alcançada com um equipamento apenas três vezes maior.

A NASA e o Departamento de Defesa dos Estados Unidos já investiram US$5 milhões na empresa, que agora está procurando parceiros privados para levantar mais US$20 milhões, necessários para construir a versão final do seu motor de fusão.

Fusão geral

A empresa canadense General Fusion está usando uma outra abordagem para tentar obter a fusão nuclear sustentada.

A técnica chama-se fusão de plasma magnetizado e consiste em iniciar a fusão em um plasma comprimido de forma intensa e rápida no interior de uma esfera giratória de metal líquido.

O reator funciona em ciclos sequenciais, com cada compressão do plasma magnetizado produzindo um "disparo" de energia gerada pela fusão.

São quatro ciclos: criação do plasma de deutério e trício, aprisionamento do plasma em um campo magnético, compressão do plasma magnetizado, gerando a fusão e, finalmente, captura do calor gerado pela fusão para uso em uma usina termoelétrica.

Os resultados ainda são modestos: segundo a empresa, o aparato produziu uma temperatura de 5 milhões de graus Celsius durante 1 microssegundo.

Mas a General Fusion tem mais dinheiro para construir versões maiores do seu reator: os US$30 milhões foram levantados entre investidores privados, entre os quais Jeff Bezos, da Amazon.

Fusão secreta

Há uma outra empresa privada na área, chamada Tri Alpha Energy, que não gosta de aparecer e nem divulga seus projetos, mas que aparentemente está usando um conceito criado pelos físicos Norman Rostoker e Hendrik Monkhorst.

A ideia é misturar hidrogênio e boro-11 em um plasma de alta temperatura para gerar a fusão.

O processo de confinamento usa a mesma configuração de campo reverso, mas aparentemente mantendo toda a energia de entrada dentro do reator - os elétrons do combustível seriam confinados eletrostaticamente e os íons seriam aprisionados magneticamente.

Os pesquisadores acreditam que, com o calor e a densidade adequadas, esses íons vão se fundir para liberar energia.

Recentemente circularam boatos de que a empresa teria levantado US$90 milhões, tendo entre seus investidores Paul Allen, cofundador da Microsoft. Mas as empresas de capital de risco apontadas nos boatos não listam a empresa em sua carteira de investimentos.

Em um artigo científico publicado em 2010, seus cientistas afirmam ter alcançado uma temperatura de 5 milhões de graus Celsius durante 2 milissegundos.

Já houve vários boatos sobre a iminência de um teste "no ano que vem", que ainda não aconteceu. Os mais otimistas opinam que uma versão comercial do reator Rostoker/Monkhorst - capaz de produzir mais energia do que consome - não sairá antes de 2020.

Fusão nuclear a frio

Há também propostas mais controversas para a fusão nuclear, embora não voltadas especificamente para a produção de energia.

A principal delas é a chamada fusão nuclear a frio, ou fusão de baixa energia, que mostra os indícios da fusão por meio dos nêutrons gerados no processo - pouquíssimos nêutrons, em comparação com os experimentos que pensam em gerar energia.

A ideia surgiu em 1989, quando Martin Fleishmann e Stanley Pons afirmaram ter verificado a fusão nuclear em uma célula eletrolítica. Mas nenhum outro grupo conseguiu reproduzir o experimento.

A esperança renasceu em 2009, quando Pamela Mosier-Boss e sua equipe modificaram ligeiramente a célula eletrolítica de Fleishmann e Pons e tiveram resultados animadores, ainda que frágeis demais para qualquer uso prático.

Mas a fusão nuclear a frio só voltou a ser levada a sério em 2010, quando a Sociedade Americana de Química promoveu um evento de dois dias exclusivamente para discutir o assunto. Deste o fiasco inicial, quem se atrevia a pesquisar a área preferia trabalhar em silêncio.

Foram mais 50 apresentações de experimentos que apresentaram resultados significativos, suficientes para colocar o assunto em pauta novamente. Mas ninguém sonha em usar a fusão a frio para geração de energia.

Fusão por cavitação

Pelo menos três grupos se envolveram em uma pretensa fusão nuclear em um equipamento de mesa, desde que Rusi Taleyarkhan e seus colegas do Laboratório Nacional Oak Ridge afirmaram ter conseguido iniciar a fusão pelo colapso de microbolhas.

Seth Putterman, da Universidade da Califórnia, fez uma demonstração semelhante em 2005, mas usando o aquecimento de um cristal em um ambiente de deutério. A produção de nêutrons, contudo, foi muito pequena, e os cientistas nunca chegaram a afirmar que a técnica seria útil para a geração de energia.

No mesmo ano, uma equipe da Universidade Purdue afirmou ter confirmado o experimento de Taleyarkhan, baseado na cavitação de microbolhas.

Contudo, depois da contestação de outros cientistas, a Universidade fez uma sindicância e concluiu que Yiban Xu e Adam Butt haviam falseado os resultados.

Uma cirurgia é normalmente uma das primeiras opções no tratamento do câncer.

Uma cirurgia é normalmente uma das primeiras opções no tratamento do câncer.

Uma nova aferição apontou que o relógio atômico do Laboratório de Física Nacional da Grã-Bretanha é o mais preciso do mundo.

Uma nova aferição apontou que o relógio atômico do Laboratório de Física Nacional da Grã-Bretanha é o mais preciso do mundo.

O Gemini-Scout é um robô-batedor, destinado a entrar em minas subterrâneas depois de um acidente, avaliar a situação e passar informações para as equipes de resgate.

O Gemini-Scout é um robô-batedor, destinado a entrar em minas subterrâneas depois de um acidente, avaliar a situação e passar informações para as equipes de resgate.

A técnica pode ser ainda mais velha e ter até 30 anos. O vírus Elk Cloner, programado para infectar computadores Apple II em 1982 ou 1981, usava o mesmo procedimento. Mas há muitas diferenças entre as pragas daquela época e as de hoje.

A técnica pode ser ainda mais velha e ter até 30 anos. O vírus Elk Cloner, programado para infectar computadores Apple II em 1982 ou 1981, usava o mesmo procedimento. Mas há muitas diferenças entre as pragas daquela época e as de hoje.

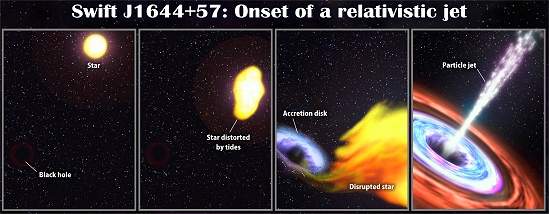

Em Março deste ano, o telescópio Swift da NASA, flagrou um fenômeno cósmico disparando um feixe de raios X incrivelmente forte em direção à Terra, vindo da Constelação do Dragão.

Em Março deste ano, o telescópio Swift da NASA, flagrou um fenômeno cósmico disparando um feixe de raios X incrivelmente forte em direção à Terra, vindo da Constelação do Dragão.

Em busca de uma alternativa para a matriz energética mundial, muitos cientistas acreditam que só a energia das estrelas pode representar um passo decisivo para a humanidade.

Em busca de uma alternativa para a matriz energética mundial, muitos cientistas acreditam que só a energia das estrelas pode representar um passo decisivo para a humanidade.