Há poucos dias, a indústria apresentou o primeiro protótipo de um chip de grafeno, o promissor material que promete não apenas substituir o silício, como levar a miniaturização a novas fronteiras, além de abrir fronteiras totalmente novas em outras áreas de aplicação.

O grafeno é uma folha de carbono, a mais fina que pode existir, com apenas um átomo de de espessura, na qual os átomos formam uma estrutura parecida com uma tela de galinheiro. Entre suas propriedades inusitadas está o fato de ser o material mais forte que existe.

Como fabricar grafenoEntão, o que os cientistas estão esperando para usar esse material e criar chips e novos materiais com desempenho muito superior aos atuais?

O problema é que não é fácil fabricar folhas com um átomo de espessura. Os experimentos feitos até agora - à exceção do método desenvolvido pela Fujitsu para criar o primeiro chip com o novo material - utilizam folhas de grafeno fabricadas artesanalmente, geralmente colocando colando uma fita adesiva sobre uma folha de grafite e removendo-a cuidadosamente.

E, enquanto não for fácil obter o grafeno, as pesquisas não avançarão no ritmo que se espera.

Agora, cientistas do Laboratório Nacional de Física, do Reino Unido, desenvolveram uma técnica que permite a criação de folhas homogêneas de grafeno de dimensões macroscópicas, com qualidades muito próximas do ideal.

A técnica possibilitará, pela primeira vez, colocar de fato as folhas de grafeno nas mãos dos pesquisadores e engenheiros - com o detalhe de que eles conseguirão vê-las a olho nu.

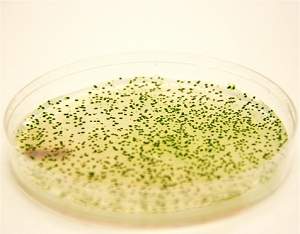

Grafeno em escala industrialAs amostras de grafeno foram produzidas por crescimento epitaxial, um processo usado para o crescimento de cristais, em que uma camada de cristal cresce sobre outra. A base utilizada foi o carbeto de silício, em cima da qual foram criadas as folhas com um átomo de carbono de espessura.

Segundo os pesquisadores, eles já conseguem fabricar amostras de grafeno com 50 milímetros quadrados, o que já é suficiente para a fabricação de um grande número de dispositivos eletrônicos - os núcleos dos processadores mais modernos não são muito maiores do que isso.

Contar com uma amostra de dimensões significativas demonstra que o grafeno pode ser fabricado de forma prática, escalável e em ritmo industrial, algo que não foi conseguido até hoje com os bem mais famosos nanotubos de carbono - que nada mais são do que folhas de grafeno enroladas.

Rumo às aplicações práticas do grafenoO feito também está permitindo que os cientistas meçam e entendam melhor as propriedades do promissor material.

Este foi o segundo passo dado pelos pesquisadores britânicos: a amostra de grandes dimensões permitiu que eles medissem as propriedades elétricas do grafeno com uma precisão sem precedentes, abrindo o caminho para o estabelecimento de normas práticas e precisas para essa nova geração da nanoeletrônica.

Para que produtos delicados como os transistores usados nos computadores funcionem adequadamente e sejam comercialmente viáveis, os fabricantes devem ser capazes de fazer tais medições com incrível precisão, usando um padrão internacional como referência.

A norma internacional de resistência elétrica é fornecida pelo Efeito Hall Quântico, um fenômeno pelo qual as propriedades elétricas em materiais bidimensionais podem ser determinadas com base apenas em constantes fundamentais da natureza.

Avanços práticosAté hoje esse efeito só havia sido demonstrado com precisão suficiente em um pequeno número de semicondutores. Além disso, tais medições exigem temperaturas próximas do zero absoluto, combinadas com campos magnéticos muito fortes. O resultado, pouco prático, é que apenas alguns poucos laboratórios especializados em todo o mundo podem atingir essas condições.

Há muito se fala que o grafeno poderia fornecer um padrão ainda melhor, mas as amostras disponíveis eram insuficientes para provar isso. Ao produzir amostras de tamanho e qualidade suficientes, e demonstrar com precisão sua resistência Hall, a equipe comprovou que o grafeno tem de fato o potencial de substituir os semicondutores convencionais em uma escala maciça.

Além disso, o grafeno apresenta o Efeito Hall Quântico em temperaturas muito mais elevadas do que seus colegas semicondutores. Isto significa que o padrão de resistência do grafeno poderá ser muito mais amplamente usado, já que o número de laboratórios ao redor do mundo que conseguem atingir essas condições mais amenas é muito maior.

Embora tudo possa parecer demasiadamente teórico, o significado desse avanço é muito prático, comprovando que, além de suas vantagens já conhecidas de velocidade e durabilidade, o grafeno agora conta com condições plenas para ser produzido industrialmente, com a consequente redução dos custos dessa promissora tecnologia eletrônica.

"É verdadeiramente sensacional que uma grande área de grafeno epitaxial tenha demonstrado não apenas continuidade estrutural, mas também o grau de perfeição exigido para as medições elétricas precisas, similares às dos semicondutores convencionais, que têm uma história de desenvolvimento muito mais longa," comemora o Professor Alexander Tzalenchuk, do Laboratório Nacional de Física do Reino Unido.

E agora?A equipe de pesquisadores está comemorando os resultados, mas não pretende dar o trabalho por encerrado. Eles planejam demonstrar medições ainda mais precisas, assim como elevar ainda mais a temperatura na qual essas medições podem ser feitas.

Mas a bola agora está também com a indústria. "O desafio para a indústria nos próximos anos será ampliar a escala de fabricação do grafeno de forma prática para atender as demandas por novas tecnologias. Nós demos um passo gigantesco e, assim que esses processos produtivos estiverem disponíveis, nós esperamos que o grafeno ofereça ao mundo uma alternativa mais rápida e mais barata do que os semicondutores convencionais," concluem eles.

O que é Efeito Hall Quântico?O Efeito Hall Quântico surge onde uma corrente elétrica flui através de um material bidimensional em um campo magnético perpendicular e a tensão elétrica no material é medida perpendicularmente aos dois - tanto ao fluxo da corrente quanto ao campo magnético.

Dentro de determinados intervalos periódicos no campo, a taxa dessa tensão transversal à corrente, conhecida como resistência Hall, é determinada somente por uma combinação conhecida de constantes fundamentais - a constante de Planck (h) e a carga do elétron (e).

Devido a essa universalidade, o Efeito Hall Quântico fornece a base para o padrão de resistência, em princípio independente de cada amostra particular de material e das condições da medição.

Até agora, o Efeito Hall Quântico somente havia sido demonstrado com precisão suficiente em um pequeno número de semicondutores, como o silício e o grupo de heteroestruturas III-V da tabela periódica.

Devido às suas propriedades únicas, o grafeno vinha sendo apontado como candidato para fornecer um padrão ainda melhor, mas as amostras de grafeno até então produzidas eram pequenas demais e de qualidade inadequada para permitir a execução das medições.

A pesquisa foi resultado de um esforço conjunto que reuniu cientistas do Laboratório Nacional de Física e Universidade de Lancaster (Reino Unido), universidades de Chalmers e Linkoping (Suécia) e da Escola Politécnica de Milão (Itália).

Uma equipe da Academia Chinesa de Tecnologia Espacial (CAST, na sigla em inglês) está no Instituto Nacional de Pesquisas Espaciais (INPE), em São José dos Campos (SP), para a chamada Revisão Crítica do Projeto (CDR) dos satélites CBERS-3 e 4. As atividades serão realizadas nos dias 2 e 3 de fevereiro em conjunto pelos especialistas brasileiros e chineses.

Uma equipe da Academia Chinesa de Tecnologia Espacial (CAST, na sigla em inglês) está no Instituto Nacional de Pesquisas Espaciais (INPE), em São José dos Campos (SP), para a chamada Revisão Crítica do Projeto (CDR) dos satélites CBERS-3 e 4. As atividades serão realizadas nos dias 2 e 3 de fevereiro em conjunto pelos especialistas brasileiros e chineses. Um novo relatório, preparado pelos cientistas do Conselho Nacional de Pesquisas dos Estados Unidos, levantou as ações necessárias e as opções disponíveis para identificar e enfrentar a ameaça de corpos celestes que ameacem colidir com a Terra.

Um novo relatório, preparado pelos cientistas do Conselho Nacional de Pesquisas dos Estados Unidos, levantou as ações necessárias e as opções disponíveis para identificar e enfrentar a ameaça de corpos celestes que ameacem colidir com a Terra. Paracoccidioidomicose (PCM) - este é nome científico da micose sistêmica, isto é, que ataca órgãos internos do corpo, que mais ocorre na América Latina.

Paracoccidioidomicose (PCM) - este é nome científico da micose sistêmica, isto é, que ataca órgãos internos do corpo, que mais ocorre na América Latina. Um grupo de pesquisadores suíços desenvolveu um novo programa que faz com que as redes de computadores atuem em conjunto de modo a evitar bugs em programas.

Um grupo de pesquisadores suíços desenvolveu um novo programa que faz com que as redes de computadores atuem em conjunto de modo a evitar bugs em programas. Até o fim de 2010, todas as ambulâncias do Serviço de Atendimento Móvel de Urgência (Samu) receberão um aparelho digital de eletrocardiograma e um software de telecomunicação que vai permitir o envio de informações cardíacas dos pacientes nos primeiros minutos do atendimento a uma equipe no hospital.

Até o fim de 2010, todas as ambulâncias do Serviço de Atendimento Móvel de Urgência (Samu) receberão um aparelho digital de eletrocardiograma e um software de telecomunicação que vai permitir o envio de informações cardíacas dos pacientes nos primeiros minutos do atendimento a uma equipe no hospital. Duas pesquisas independentes, que acabam de ser divulgadas nos Estados Unidos, mostram que as bactérias geneticamente modificadas logo poderão ser mais importantes do que as plantas usadas para a produção de biocombustíveis.

Duas pesquisas independentes, que acabam de ser divulgadas nos Estados Unidos, mostram que as bactérias geneticamente modificadas logo poderão ser mais importantes do que as plantas usadas para a produção de biocombustíveis. A Agência Internacional de Energia Atômica (AIEA ) aprovou a participação do Brasil no Projeto de Pesquisa Coordenado (CRP) para desenvolvimento de técnicas para produção de molibdênio-99 utilizando urânio-235 de baixo enriquecimento por fissão neutrônica.

A Agência Internacional de Energia Atômica (AIEA ) aprovou a participação do Brasil no Projeto de Pesquisa Coordenado (CRP) para desenvolvimento de técnicas para produção de molibdênio-99 utilizando urânio-235 de baixo enriquecimento por fissão neutrônica. A terapia fotodinâmica, normalmente usada para o tratamento de alguns tipos de câncer superficiais, também pode ser usada para combater fungos e bactérias, tornando-se assim mais uma aliada no tratamento dentário.

A terapia fotodinâmica, normalmente usada para o tratamento de alguns tipos de câncer superficiais, também pode ser usada para combater fungos e bactérias, tornando-se assim mais uma aliada no tratamento dentário. As leis matemáticas da física funcionam tão bem para os eventos do passado quanto para os eventos do futuro. No entanto, nunca no mundo real a porção de café em uma xícara se desmisturou do leite.

As leis matemáticas da física funcionam tão bem para os eventos do passado quanto para os eventos do futuro. No entanto, nunca no mundo real a porção de café em uma xícara se desmisturou do leite.