sábado, 29 de novembro de 2008

Ranking do Boliche

sexta-feira, 28 de novembro de 2008

EBOOK: Introduction to Algorithms, Second Edition

Nome do Lançamento:Introduction to Algorithms, Second Edition

Tamanho: 12MB

Links: Homepage

Download: Rapidshare

Vítimas de Santa Catarina precisam de ajuda; veja a relação de postos

A água poderá ser entregue na Defesa Civil dos municípios, além dos órgãos de segurança do governo estadual, como polícias Civil e Militar e Corpo de Bombeiros.

No entanto, as quedas de barreiras e bloqueios em estradas estão dificultando a entrega dos materiais. Por conta disso, a Defesa Civil pede que os interessados em ajudar priorizem as doações em dinheiro nas contas bancárias.

Além dos bancos do Bradesco, Besc e Banco do Brasil que já receberam mais de R$ 1,4 milhões em doações, agora a Caixa Econômica Federal também está recebendo as doações, enquanto o Itaú também prometeu disponibilizar uma conta. Por enquanto, as contas para doações são:

- Caixa Econômica Federal - Agência 1877, operação 006, Conta Corrente 80.000-8;

- Banco do Brasil - Agência 3582-3, Conta Corrente 80.000-7;

- Besc - Agência 068-0, Conta Corrente 80.000-0;

- Bradesco Agência 0348-4, Conta Corrente 160.000-1

Em nome da pessoa jurídica é Fundo Estadual da Defesa Civil, CNPJ - 04.426.883/0001-57

A Defesa Civil alerta que não envia mensagens eletrônicas com pedidos de auxílio.

Postos de doações

O posto da PRF (Polícia Rodoviária Federal) de Biguaçu, na região da Grande Florianópolis, está recebendo doações de alimentos não-perecíveis para as vítimas da enchente. A mercadoria arrecadada será entregue à Defesa Civil Estadual.

O Beto Carrero World, no litoral norte do Estado, também montou uma base de arrecadação de alimentos, roupas, medicamentos, colchões e cobertores na entrada do parque. A assessoria de comunicação informou que qualquer doação pode ser enviada à rua Inácio Francisco de Souza, 1.579, na Praia da Aclimação, na cidade de Penha. O telefone é (0xx47) 3261-2222.

As secretarias regionais da região do Alto Vale do Itajaí (Blumenau, Brusque, Itajaí, Jaraguá do Sul, Joinville e Timbó) também montaram bases de arrecadação e distribuição. As pessoas interessadas em doar materiais devem ir nos seguintes locais:

- Colégio Victor Hering

Rua Antônio Cândido Figueiredo, 399, Bairro Vila Nova --Blumenau;

- Fenarreco

Rodovia SC-486, próximo à Havan, centro --Brusque;

- Parque da Marejada

Av. Vicotr Konder, s/n, Bairro Fazenda --Itajaí;

- Arena Multiuso Jaraguá

Rua Gustavo Hagedorn, s/n, Centro --Jaraguá do Sul;

- Colégio Osvaldo Aranha

Rua Lindóia, Bairro Glória --Joinville;

-Depósito da Secretaria Regional

Rua Nereu Ramos, 913, Centro --Timbó.

Doação de Sangue

A Secretaria de Estado da Saúde também alerta para a necessidade de doações de sangue. Entre a segunda (24) e a quarta-feira (26), a demanda por transfusões de sangue mais que dobrou no Centro Hemoterápico de Blumenau.

A secretaria divulgou a relação de locais onde é possível realizar doações de sangue. O horário de atendimento nos postos é das 7h30 às 18h30.

- Hemoesc Florianópolis

Rua: Othon Gama D'eça, 756, centro --Florianópolis. Contato: (48) 3251-9711

- Hemocentro Regional de Chapecó

Rua São Leopoldo, 391, Quadra 1309, bairro Esplanada --Chapecó. Contato: (49) 3329-0550

- Hemocentro Regional de Joaçaba

Avenida 15 de Novembro, 23, centro --Joaçaba. Contato: (49) 3522-2811

- Hemocentro Regional de Lages

Rua Felipe Schmidt, 33 --Lages.

- Centro Hemoterápico de Blumenau

Rua Marechal Floriano Peixoto, 300, anexo ao hospital Santa Isabel, no centro de Blumenau.

Para doar, é necessário, entre outros itens, ter entre 18 e 65 anos, estar em boas condições de saúde e evitar alimentação gordurosa nas quatro horas que antecedem a doação.

São Paulo

A Cruz Vermelha Brasileira e a Comdec (Coordenadoria Municipal da Defesa Civil-SP) anunciaram a criação de postos para arrecadar doações para as vítimas das chuvas que atingem Santa Catarina.

A arrecadação vai funcionar 24 horas na sede da Comdec --na rua Afonso Pena, 130, no bairro Bom Retiro--, e na sede da Cruz Vermelha Brasileira --na avenida Moreira Guimarães, 699, no bairro Saúde. As defesas civis das subprefeituras receberão doações em horário comercial.

Os postos vão receber doações de roupas, calçados, cobertores, fraldas, água potável, material de higiene, alimentos não perecíveis, entre outros. Entre ontem e hoje, a Cruz Vermelha Brasileira recebeu mais de dez toneladas de doações, que serão levadas nesta sexta-feira (28) à Defesa Civil de Santa Catarina.

Além da sede da Cruz Vermelha Brasileira, é possível fazer doações nos seguintes postos da entidade (horário comercial):

- Colégio Santo Ivo

Rua Paço da Pátria, 1705, Alto da Lapa

- Iolanda e Marcelo

Avenida Henrique Franco, 135

- Limoeiro - São Miguel Paulista pelo fone: 2025-7369

- ACM - Associação Cristã de Moços

Avenida das Flores, 453 - Jd. das Flores --Osasco

- Restaurante Mostarda

Av. Luis Carlos Berrini, 483, Brooklin Novo

- Escola Oriental de Massagem e Acupuntura

Avenida Dioderichen, 1000, Jabaquara próximo ao metro Conceição

- Felicita Beauty

Rua Dr. Cesário Mota Jr, 383, Vila Buarque

Consolação

- Supermercado Papini,

Avenida Professor Papini, 232, Cidade Dutra

- Condomíno Jd. Office Tower

Alameda Joaquim Eugênio de Lima, 881, Jardins

A Força Sindical Nacional também está recebendo doações. Eles pedem às aos sindicatos e federações que colaborem com alimentos não perecíveis, roupas, água potável, artigos de higiene e calçados. A Força montou um posto de arrecadação em sua sede em São Paulo, na rua Galvão Bueno, 782, na Liberdade.

O São Paulo Futebol Clube realizará um mutirão de arrecadação entre esta quinta-feira e o sábado (29). A arrecadação acontecerá no portão 1 do Estádio do Morumbi, das 8h às 20h. No domingo (30), dia da partida entre o São Paulo e o Fluminense, todos os portões de acesso ao estádio receberão doações, desde a abertura até o intervalo do jogo.

A CPTM (Companhia Paulista de Trens Metropolitanos) também receberá doações de alimentos não perecíveis, roupas e cobertores nas estações de trem de maior movimento em São Paulo: Luz, Brás, Barra Funda, Osasco, Santo Amaro, Santo André.

As doações ocorrem a partir das 15h desta sexta-feira (28). A empresa se responsabilizará pelo transporte das doações, que serão entregues à Defesa Civil de Santa Catarina. As doações podem ser depositadas nas caixas instaladas nas estações ou entregues a um agente operacional.

Água Potável

A Polícia Militar de São Paulo também está recebendo doações. A prioridade, segundo a assessoria da PM, é para a arrecadação de água potável. Para doar, basta procurar um Batalhão da Polícia Militar mais próximo de sua casa. A relação completa está no site da Polícia Militar.

Também é possível realizar doações no Depósito do Fundo Social da Solidariedade em São Paulo, na avenida Marechal Mário Guedes, 301, Jaguaré (das 9h às 16h).

Roupas

O campus da Univali (Universidade do Vale do Itajaí) de Balneário Camboriú (SC) está confeccionando roupas de cama e camisetas para as vítimas das chuvas na região. A universidade precisa de voluntários para ajudar na confecção das roupas, além de doações de matéria prima como malha, tecidos, elástico e embalagens plásticas.

A Univali observa ainda que os voluntários não precisam saber costurar. Eles podem ajudar no corte, etiquetagem e embalagem das peças. O laboratório de Modelagem e Vestuário fica localizado no bloco 9 do Campus Balneário Camboriú --na quinta avenida, s/n, bairro dos Municípios-- e vai funcionar das 8h30 às 20h. Mais informações pelos fones (47) 3261-2351 ou (47) 3261-1292 ou (47) 3261-1358.

Outros Estados

A Cruz Vermelha Brasileira também está recebendo doações para as vítimas das chuvas de Santa Catarina em outros Estados. O endereço das outras filiais estão no site da entidade.

Recomendações da Defesa Civil

A Sedec (Secretaria Nacional de Defesa Civil), vinculada ao Ministério da Integração Nacional, divulgou nesta quinta-feira uma lista de orientações para os interessados em ajudar. Segundo o órgão, a idéia é evitar problemas gerados pela "doação desorganizada" como a não correspondência das doações com as necessidades reais dos atingidos.

Veja as recomendações:

-Antes de efetuar doações procure informações de necessidades levantadas pela Defesa Civil do seu Estado ou município, ou em quartéis de Bombeiros ou Polícia Militar, por exemplo;

-Atentar para a qualidade do material doado;

-Estabelecer uma comunicação eficaz entre o doador e autoridade de Defesa Civil local onde ocorreu o desastre;

-Consultar as autoridades que estão gerenciando a situação para averiguar a real necessidade de doação de gêneros e da quantidade, antes de iniciar qualquer campanha de arrecadação.

Nobreza do gás hélio pode estar chegando ao fim

Agora, um químico da Universidade Warsaw, na Polônia, afirma ter encontrado uma forma de convencer o gás de sangue azul a formar uma aliança com o oxigênio, para a formação de dois novos compostos.

Reação química com o hélio

Os dois compostos mais famosos previstos anteriormente pela teoria - o HeBeO1 e o HHeF2 - até hoje nunca foram comprovados experimentalmente, o mesmo acontecendo com outras previsões menos conhecidas.

O Dr. Wojciech Grochala afirma que os dois novos compostos que ele acaba de prever teoricamente - o CsFHeO e o NMe4FHeO - deverão ter melhor sorte. Esses compostos são derivados do ânion metaestável [F- HeO], descoberto em 2005 por um grupo de pesquisadores de Taiwan.

Moléculas estranhas

"As moléculas não são tão estranhas quanto possa parecer à primeira vista. A idéia é preservar a característica metaestável da frágil entidade [F- HeO] conectando-a fracamente a um cátion (como o Cs+ ou o NMe4) para atingir uma neutralidade elétrica," explica Grochala.

Mesmo assim, a estabilidade cinética dessas moléculas é extremamente limitada, e a busca por sua sintetização certamente se dará em experimentos muito próximos ao zero absoluto.

Para quem quiser tentar, o Dr. Grochala dá algumas dicas: "A síntese das duas moléculas poderá começar com hipofluoretos raros, CsOF and NMe4OF, incorporados em uma gota de hélio ultrafrio. A excitação por laser da ligação química O-F deverá permitir a inserção de um átomo de hélio nessa ligação para a observação espectroscópica dessas moléculas de vida curta. É claro, tais experimentos são altamente desafiadores, mas é isto que torna a moderna química tão mais divertida."

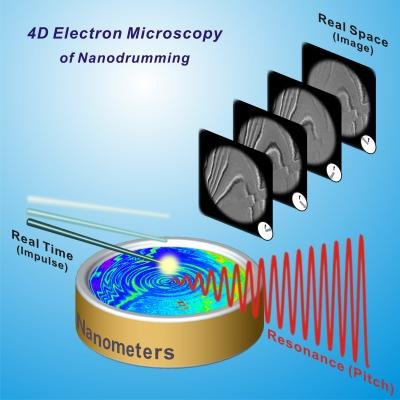

Microscópio 4-D revoluciona a forma como vemos o mundo nano

Acostumados com o cinema e a televisão, poucos se dão conta da revolução que representou a sua criação, quando, pela primeira vez, as pessoas puderam ver o passado gravado para sempre em um rolo de filme.

Acostumados com o cinema e a televisão, poucos se dão conta da revolução que representou a sua criação, quando, pela primeira vez, as pessoas puderam ver o passado gravado para sempre em um rolo de filme.Agora, em um feito similar, cientistas do Instituto Tecnológica da Califórnia criaram um microscópio 4-D, capaz de capturar as três dimensões espaciais mais o tempo - uma descrição pomposa para um filme em escala atômica.

Filmando átomos e moléculas

Apesar dos contínuos avanços na microscopia, esta é a primeira vez que se consegue a gravação de um filme em tempo real, no espaço real, das fugazes alterações na estrutura e na forma da matéria em uma escala de bilionésimos de metro.

A nova técnica, batizada de microscopia eletrônica 4-D, foi desenvolvida pela equipe do professor Ahmed Zewail, ganhador do Prêmio Nobel de Química em 1999 pelo uso de pulsos de laser ultra-curtos para a observação de reações químicas fundamentais, como os átomos se unindo em moléculas e depois se dividindo novamente em átomos. Um fenômeno como este ocorre em uma escala de um femtosegundo, o equivalente a um milionésimo de bilionésimo de segundo.

A dimensão do espaço

As imagens das moléculas em movimento "nos dão a dimensão do tempo, mas o que nós não tínhamos era a dimensão do espaço, a estrutura. Meu sonho desde 1999 era descobrir uma forma de olhar não apenas no tempo mas também no domínio espacial, para ver a arquitetura de um sistema complexo em escala atômica, à medida que ele muda ao longo do tempo, seja da matéria física ou biológica," diz Zewail.

Os microscópios eletrônicos são a melhor ferramenta atualmente para se observar a matéria em escala molecular e atômica, mas eles não são capazes de capturar o comportamento dos átomos simultaneamente no espaço e no tempo.

Controlando elétrons individuais

O que a equipe do professor Zewail fez foi controlar com precisão, no tempo e no espaço, a trajetória de cada elétron emitido pelo microscópio eletrônico. Com isto eles criaram um "imageamento de elétron único" ultra-rápido, introduzindo a quarta dimensão - a espacial - na microscopia eletrônica.

A imagem resultante produzida por cada elétron representa uma fotografia de um femtosegundo num dado momento no tempo. Da mesma forma que os quadros em um filme, as imagens geradas seqüencialmente podem ser montadas em um filme digital mostrando o que acontece em escala atômica.

"Com esta técnica de imageamento 4-D, os movimentos em escala atômica que levam aos fenômenos estruturais, morfológicos e nanomecânicos agora podem ser visualizados diretamente e, quiçá, compreendidos," diz Zewail.

Brasil ganha 101 novos institutos de Ciência e Tecnologia

O Programa dos INCTs (Institutos Nacionais de Ciência e Tecnologia) tem metas abrangentes em termos nacionais, como a possibilidade de mobilizar e agregar, de forma articulada, os melhores grupos de pesquisa em áreas de fronteira da ciência e em áreas estratégicas para o desenvolvimento sustentável do País.

Pesquisa básica e tecnológica

Com a implantação desses centros de excelência, o Ministério da Ciência e Tecnologia pretende impulsionar a pesquisa científica básica e fundamental em níveis competitivos internacionalmente e estimular o desenvolvimento de pesquisa científica e tecnológica de ponta para promover a inovação e o espírito empreendedor, em estreita articulação com empresas inovadoras.

Além de promover o avanço da competência nacional nas diversas áreas de atuação dos Institutos, criando ambientes atraentes e estimulantes para alunos talentosos de diversos níveis, do ensino médio ao pós-graduado, o Programa também se responsabilizará diretamente pela formação de jovens pesquisadores e apoiará a instalação e o funcionamento de laboratórios em instituições de ensino e pesquisa e empresas, proporcionando a melhor distribuição nacional da pesquisa científico-tecnológica, e a qualificação do País em áreas prioritárias para o seu desenvolvimento regional e nacional.

Os Institutos devem ainda estabelecer programas que contribuam para a melhoria do ensino de ciências e a difusão da ciência para a população em geral.

Núcleos estratégicos de pesquisa científica

O Programa de Institutos Nacionais de Ciência e Tecnologia (INCT) investirá cerca de R$ 600 milhões em 101 unidades de pesquisas, que passam a ocupar posição estratégica no Sistema Nacional de Ciência e Tecnologia.

O ministro da Ciência e Tecnologia, Sergio Rezende, informou que o programa, que contava com R$ 523 milhões, recebeu cerca de R$ 70 milhões em reforço financeiro do Banco Nacional de Desenvolvimento Econômico Social (BNDES) e da Petrobras. Este é o maior valor destinado para uma chamada pública para apoio à pesquisa já disponibilizada no Brasil.

Os recursos serão repassados diretamente para o Conselho Nacional de Desenvolvimento Científico e Tecnológico (CNPq/MCT), que financiará os institutos por meio de editais. "Com isso, podemos aumentar o número de institutos atendidos ainda em 2009", comemorou Sergio Rezende.

Avaliação contínua

O ministro destacou que todos os INCTs serão submetidos a avaliações constantes do CNPq. Já as ações do programa serão acompanhadas pelo Centro de Gestão e Estudos Estratégicos (CGEE/MCT). Rezende destacou que as unidades que não apresentarem os resultados esperados, poderão ter os recursos bloqueados. "Não vamos parar as atividades dos INCTs no primeiro ano. Daremos uma espécie de cartão amarelo, para que a unidade possa se enquadrar e buscar os resultados esperados", explicou.

Institutos em todo o país

Os institutos selecionados começam a funcionar ainda este ano e estão distribuídos pelas cinco regiões do País. O Norte sediará oito institutos, que receberão R$ 42 milhões; no Nordeste, 14 institutos terão R$ 59 milhões; no Centro-Oeste, três instituições terão recursos de R$ 18 milhões; na região Sul os 13 institutos selecionados recebem R$ 53 milhões, e no Sudeste, onde se encontram 63 unidades - o maior número de sedes - o aporte chega a R$ 319 milhões.

Os projetos aprovados recebem financiamento por até cinco anos. Na soma dos recursos que serão disponibilizados, também estão incluídos R$ 30 milhões em bolsas, que serão concedidas pela Capes.

Áreas de atuação dos institutos

Os projetos enviados na demanda induzida, ou seja, aqueles indicados como proposta do comitê gestor, recebem 60% dos recursos. São projetos em 19 áreas consideradas estratégicas, como Biotecnologia, Nanotecnologia, Tecnologias da Informação e Comunicação, Saúde, Biocombustíveis, Energia Elétrica, Hidrogênio e Fontes Renováveis de Energia, Petróleo, Gás e Carvão Mineral, Agronegócio, Biodiversidade e Recursos Naturais, Amazônia, Semi-Árido, Mudanças Climáticas, Programa Espacial, Programa Nuclear, Defesa Nacional, Segurança Pública, Educação, Mar e Antártica e Inclusão Social. O restante será utilizado para apoiar as propostas da demanda espontânea de todas as áreas do conhecimento.

Bombinhas para asma com CFC serão proibidas no país

Segundo a Anvisa já existem alternativas ao uso do CFC, o que significa que a medida não trará prejuízos aos pacientes. Um exemplo é o gás hidrofluoralcano (HFA).

"O HFA apresenta eficácia semelhante ao CFC e é vantajoso quanto ao custo", afirma Jorge Samaha, gerente de Pesquisas, Ensaios Clínicos, Medicamentos Biológicos e Novos da Anvisa.

Proteção da camada de ozônio

O fator determinante para a proibição é o fato de que a emissão do CFC pode destruir a camada de ozônio, ocasionando prejuízos ao meio ambiente e à saúde humana.

Na Anvisa, há 12 medicamentos registrados que utilizam o CFC como propelente (para dar impulso). Esses medicamentos são aerossóis utilizados em casos de asma e doenças pulmonares.

O ozônio é um gás presente naturalmente em duas regiões da atmosfera: na troposfera (entre 10 e 16 quilômetros da Terra) e na estratosfera (entre 16 e 50 quilômetros da Terra). Cerca de 90% do gás está na estratosfera.

O início da destruição do ozônio estratosférico se dá por meio de emissão de gases que contenham cloro e bromo. Destruída, a camada de ozônio não absorve a radiação ultravioleta do sol, que é nociva à saúde. A radiação pode causar danos à visão, supressão do sistema imunológico e câncer de pele.

Esclarecimento aos pacientes

Para esclarecer os consumidores, os fabricantes terão até o dia 31 de julho de 2009 para incluir nas bulas e embalagens a seguinte mensagem: Este medicamento contém substâncias que agridem a camada de ozônio e por isso será substituído. Procure o seu médico para orientações.

Clorofluorcarbonos

As empresas fabricantes deverão entrar com o pedido de adequação dos produtos na Anvisa até 31 de julho de 2010. A documentação terá prioridade de análise na Agência.

A medida é válida para os produtos que utilizam gases propelentes do tipo clorofluorcarbonos, que abrangem as seguintes espécies químicas, isoladas ou em mistura: triclorofluormetano (CFC 11), diclorodifluormetano (CFC 12), diclorotetrafluoretano (CFC 14) e outros clorofuorcarbonos com potencial de destruição da camada de ozônio.

Brasil está vencendo a luta contra o câncer infantil

A informação consta da publicação Câncer na Criança e no Adolescente no Brasil: Dados dos Registros de Base Populacional e de Mortalidade, lançada ontem pelo Instituto Nacional de Câncer (INCA), em comemoração ao Dia Nacional de Combate ao Câncer.

Câncer infanto-juvenil no Brasil

A publicação inédita mostra a situação do câncer infanto-juvenil no Brasil, com informações sobre incidência e mortalidade, além de outros dados gerais sobre o assunto, incluindo estudos desenvolvidos no Brasil e no mundo.

A análise do perfil da incidência foi realizada a partir das informações coletadas em 20 centros de tratamento e triagem, os chamados Registros de Câncer de Base Populacional (RCPB) do país, 17 deles localizados em capitais.

O estudo permite contextualizar as principais características do câncer na criança e no adolescente, bem como conhecer os tumores mais incidentes e também os de maior mortalidade na população infanto-juvenil.

Diagnóstico precoce

O INCA coordena um esforço nacional de combate ao câncer infantil e juvenil que reúne várias instituições do Brasil que atuam nessa área. O trabalho tem como eixos fundamentais o diagnóstico precoce, a melhoria da qualidade da assistência e a integração das parcerias para o controle da doença.

Vencendo o câncer infantil

A melhor notícia trazida pela publicação é que a perspectiva da criança com câncer mudou de eixo - passando de 85% de mortalidade para 85% de chances de cura. Portanto, de acordo com a publicação, o tratamento da criança com câncer é um dos maiores exemplos de sucesso da medicina dos últimos 30 anos.

A mudança de perfil, observada pela análise da incidência e mortalidade, sugere uma relação direta com os avanços terapêuticos e com os métodos de diagnóstico precoce, principalmente os registrados durante a década de 70.

As informações da publicação apontam para uma queda da mortalidade pela doença, em todo o mundo, nos últimos 30 anos, principalmente em relação às leucemias, que se apresentam como os cânceres mais incidentes na faixa etária dos 0 aos 18 anos.

Principal causa de morte

É possível observar pelos estudos internacionais, disponíveis na publicação, que as taxas de incidência apresentaram discreto aumento nas últimas décadas. Nos Estados Unidos, de 1975 a 1999, a variação percentual anual foi de 0,4 a 1%. Porém, para o período mais recente, 1987 a 1999, a taxa tem permanecido estável, variando de -0,2% a 1,1%.

A publicação mostra que a política de combate ao câncer infanto-juvenil no país está no caminho certo. O perfil da incidência do câncer em crianças e adolescentes no Brasil é semelhante ao observado nos países em desenvolvimento. O câncer destaca-se ainda como a mais importante causa de óbito dentro da faixa etária de 1 a 18 anos. Este cenário pode ser atribuído às atuais políticas de prevenção de outras doenças infantis.

Assim, no Brasil, excluindo-se as causas externas, o câncer é a principal causa de morte, por doença, na faixa etária de 5 a 18 anos. Em menores de 5 anos, o câncer é uma das dez principais causas de morte.

Brasileiro está entre os mais 'perdidos' em termos de localização, diz pesquisa

A população de Londres é a que concentra o maior número de "perdidos", segundo o estudo da Nokia, que ouviu 12,5 mil pessoas em 13 países. Um em cada três londrinos dá informações erradas quando indagado sobre direções de trânsito.

Além disso, um em cada 10 ouvidos afirmou ser impossível circular por Londres sem se perder. Por esse índice, Londres lidera a lista das cinco cidades de maior concentração de pessoas perdidas, seguida por Paris, Bangcoc, Hong Kong e Pequim.

Informações erradas

No Brasil, segundo comunicado distribuído à imprensa, 1 mil pessoas em oito capitais foram ouvidas. O país reúne, de acordo com o estudo, a maior concentração de pessoas que admitem ter faltado a compromissos por dificuldades em se localizar (8% do total).

Na cidade de São Paulo, 16% dos ouvidos já perderam uma entrevista de emprego por problemas de localização. Em Recife (PE), 13% já perderam uma cerimônia de casamento por não terem encontrado o caminho da igreja.

Entre todos os ouvidos na pesquisa global, o Brasil foi também o que apresentou maior índice de pessoas que se perdem quando estão no exterior (31%).

Apesar dos índices, apenas 5% dos brasileiros entrevistados afirmaram disposição em utilizar um sistema de navegação para se localizar. Além disso, 15% dos brasileiros admitiram dar informações erradas "para parecerem mais sabidos", segundo o comunicado.

Vírus corrige falha do Windows após infectar o sistema

Foi encontrada nesta semana mais uma praga virtual (worm) que explora a brecha de segurança no Windows corrigida de forma emergencial em outubro. O vírus, batizado de Conficker.A, tem uma característica interessante: ele impede que outros vermes infectem o sistema pela mesma falha.

Para fazer isso, o Conficker.A corrige, na memória (de maneira temporária), a falha usada por ele próprio. Outras pragas digitais que exploram o mesmo problema ficarão incapacitadas de infectar o computador, pois não será possível explorar a brecha, pelo menos até o sistema ser desinfectado e reiniciado.

A descoberta desse novo worm foi divulgada pela Microsoft na terça-feira (25). Segundo os especialistas da empresa, o objetivo da praga ao consertar a vulnerabilidade é não deixar que outros vírus, “concorrentes”, infectem o sistema.

O Conficker.A também impede o uso do recurso da Restauração do Sistema e baixa outros arquivos maliciosos para o computador. Por algum motivo, a praga está programada para não infectar computadores ucranianos.

Embora o Conficker.A corrija a falha apenas para afastar concorrentes, houve ao longo dos anos alguns “vírus do bem” que se espalhavam apenas para corrigir as brechas. O mais famoso desses é o Welchia, de 2003. Ele infecta os sistemas Windows usando a mesma vulnerabilidade do Blaster. Uma vez dentro do sistema, o Welchia instalava a correção permanente para o problema e tentava remover o vírus Blaster, se ele estivesse presente. Para controlar as infecções, o Welchia foi programado para desligar-se no dia 1º de janeiro de 2004.

CNPq releva projetos para Institutos Nacionais de Ciência e Tecnologia

Entre 261 propostas enviadas, foram escolhidos 101 projetos que fundamentarão o funcionamento dos Institutos Nacionais de Ciência e Tecnologia ainda este ano por meio de investimentos totais de 600 milhões de reais.

A distribuição geográfica dos projetos privilegiará o eixo Sudeste/Sul, com 13 institutos no Sul e 63 no Sudeste, com aportes financeiros que chegam a 53 milhões de reais e 319 milhões de reais, respectivamente.

O Nordeste sediará 14 institutos, com investimento de 59 milhões de dólares, seguido pelo Norte, com oito institutos e 42 milhões de reais em verba e pelo Centro-Oeste, com três unidades e recursos de R$ 18 milhões.

A lista dos 101 projetos aprovados, em parceria do CNPq co os Ministérios da Saúde e Educação, Petrobrás e Banco Nacional de Desenvolvimento Econômico e Social (BNDES), pode ser consultada no site do CNPq.

Interior de São Paulo recebe sinal da TV Digital no dia 3 de dezembro

A retransmissora EPTV, afiliada à TV Globo, começará a transmitir sua programação em alta definição na próxima quarta-feira (03/12), dias antes do primeiro aniversário do sistema brasileiro de TV Digital.

No primeiro momento, o sinal cobrirá toda a cidade de Campinas, com a retransmissora admitindo planos de aumentar a cobertura para municípios vizinhos, como Valinhos, Hortolândia, Sumaré e Monte Mor.

Campinas é a sétima cidade brasileira a receber o sinal da TV Digital, após São Paulo, Belo Horizonte, Rio de Janeiro, Goiânia, Curitiba e Porto Alegre.

Ao contrário de todas as outras, no entanto, o sinal veiculado pela EPTV marca a estréia da TV Digital longe das capitais.

Adiamento em Santa Catarina

Pouco antes do anúncio da EPTV, o canal gaúcho RBS afirmou que adiaria o lançamento do sinal da TV Digital em Santa Catarina por tempo indeterminado após as chuvas que atingiram diversas regiões do Estado.

Marcadas originalmente para essa terça-feira (25/11), a transmissão foi postergada pela incapacidade técnica da veiculação do sinal no momento e pelo "comprometimento da RBS em divulgar informações sobre os acontecimentos", segundo sua assessoria.

Além das chuvas, que causaram a morte de 86 pessoas por enchentes e desabamentos de terra, segundo a Defesa Civil de Santa Catarina, problemas com a agenda do Ministro das Comunicações, Hélio Costa, também inviabilizam o lançamento.

A RBS pretende iniciar a transmissão na segunda quinzena de dezembro, mas admite que a data pode mudar.

quinta-feira, 27 de novembro de 2008

Programa insere imagens e vídeos em filmes

Mudar a história não é mais uma exclusividade de governos ditatoriais inspirados na distopia de George Orwell. Apagar personagens que se tornaram incômodos, ou mesmo criar inimigos justificadores de políticas pouco justificáveis, agora é também uma possibilidade real para os cidadãos comuns graças a um programa criado por pesquisadores da Universidade de Stanford, nos Estados Unidos.

Inserindo fotos em um filme

Imagine que você tem um filme muito querido, que adora compartilhar com as pessoas mais chegadas. Só que, incidentalmente, você acaba de mudar de sogra. Pode ser interessante retirar alguma fotografia da parede ou do criado-mudo e que insiste em aparecer todas as vezes que você vê o filme.

Isto agora é possível, e relativamente simples, graças a um programa de inteligência artificial criado pelos estudantes Ashutosh Saxena e Siddharth Batra, orientados pelo professor Andrew Ng.

Inserindo um filme em outro filme

O programa é capaz de inserir uma imagem sobre qualquer superfície plana na cena de um filme - seja uma parede, o teto, uma estante ou qualquer outra. A cena inserida tanto pode ser uma textura, capaz de eliminar um quadro da parede, uma uma outra imagem, para substituir um quadro que esteja na parede, quanto um filme. Ou seja, é possível inserir um filme dentro de outro filme.

Isto permite que você exercite suas próprias pretensões de interpretação à la Tom Hanks, podendo participar de um evento ao lado do Presidente da República, da entrega da Copa do Mundo ou, quem sabe, subir no pódio ao lado dos maiores medalhistas olímpicos.

Lucros no YouTube

Os pesquisadores afirmam também que o programa poderá render bons lucros para aqueles que gostam de postar vídeos no YouTube, e que agora poderão inserir logotipos de empresas em pontos discretos de suas filmagens, cobrando por isto.

Os pesquisadores afirmam que é impossível prever todas as possibilidades de uso de seu novo programa. Mas eles têm algumas dicas. "Suponha que você seja um estudante vivendo em uma república e suponha que você queira mandar um filme para os seus pais. Você pode colocar um belo poster do Albert Einstein na parede. Mas, se você quiser mandar o filme para seus amigos, você pode colocar um poster da Playboy lá."

Manipulação de filmes

A tecnologia incorporada no programa está em um algoritmo capaz de analisar o vídeo, com atenção especial na área onde o usuário pretende inserir a nova imagem ou filme.

A cor, textura e iluminação da nova imagem são alteradas para se mesclar perfeitamente com o ambiente mostrado no filme. As sombras vistas no filme original também são vistas na nova imagem. O resultado é uma foto ou vídeo que parece ser uma parte integrante da cena original, em vez de uma imagem colada artificialmente.

O novo programa é um melhoramento do Make3D, criado na mesma Universidade e capaz de transformar fotografias em ambientes virtuais.

Cientistas precisam decidir se energia líquida é ou não uma boa métrica

Energia líquida

Energia líquida é uma métrica utilizada por alguns cientistas para tentar estimar a sustentabilidade e a capacidade dos combustíveis alternativos em substituir o petróleo.

Mas diversos artigos recentes publicados em periódicos científicos demonstram que a comunidade científica como um todo está indecisa sobre os méritos do conceito de energia líquida como uma ferramenta para avaliar os biocombustíveis.

Enfoque holístico

Para acabar definitivamente com a guerra de artigos contra e a favor da energia líquida como uma ferramenta válida de análise, o professor Dale afirma ser necessário adotar um enfoque mais holístico que leve em consideração questões como a emissão de gases causadores do efeito estufa, a substituição do petróleo e o crescimento econômico, principalmente quando as discussões envolverem os países em desenvolvimento.

Cálculo da eficiência dos combustíveis

Segundo Dale, é necessário que a comunidade científica estabeleça parâmetros claros por meio dos quais se possa calcular a eficiência dos combustíveis, usando não apenas uma, mas várias métricas que possam ser usadas de forma conjunta para traçar um quadro mais amplo da situação.

"A eleição do novo presidente do Estados Unidos, que apóia abertamente os biocombustíveis, irá colocá-los fortemente na agenda. Nós precisamos resolver esta questão de uma métrica apropriada de uma vez por todas para que possamos nos concentrar no problema concreto - criar alternativas viáveis de combustíveis e reduzir nossa dependência dos combustíveis fósseis," afirma Dale.

Nanorrevestimento se aproxima do lubrificante ideal

Um dos objetivos da atual missão do ônibus espacial Endeavour está sendo lubrificar as juntas que fazem girar os painéis solares da Estação Espacial Internacional, a fim de que eles possam estar sempre voltados para o Sol e capturem mais energia. O atrito, contudo, está fazendo com que eles desperdicem quase todo o ganho com esse posicionamento inteligente.

Um dos objetivos da atual missão do ônibus espacial Endeavour está sendo lubrificar as juntas que fazem girar os painéis solares da Estação Espacial Internacional, a fim de que eles possam estar sempre voltados para o Sol e capturem mais energia. O atrito, contudo, está fazendo com que eles desperdicem quase todo o ganho com esse posicionamento inteligente.Este não é um problema exclusivo dos equipamentos no espaço. Na verdade, o atrito talvez seja o maior problema de qualquer máquina, em qualquer lugar. Sempre que duas partes mecânicas estão sujeitas à fricção, mais energia será despendida para movimentá-las. E, ao longo do tempo, isso significará uma redução na sua vida útil.

Lubrificante ideal

Existem inúmeras formas de lubrificar essas superfícies, mas os engenheiros estão sempre procurando o "lubrificante ideal," aquele que faça com que os equipamentos movimentem-se com o gasto mínimo de energia e sofrendo o menor índice de desgaste possível.

Engenheiros dos Laboratórios Ames, nos Estados Unidos, acreditam ter dado mais um passo rumo a esse lubrificante ideal. Eles usaram a nanotecnologia para criar um revestimento que pode ser aplicado às peças mecânicas sujeitas ao atrito, diminuindo esse atrito de forma surpreendente e praticamente não exigindo manutenções posteriores.

Cerâmica lubrificante

A base do nanorrevestimento é uma cerâmica formada pelos elementos boro, alumínio e magnésio - ela foi batizada de cerâmica BAM, as iniciais dos três elementos. Ao acrescentar o diboreto de titânio, os pesquisadores conseguiram aumentar ainda mais seu rendimento.

Embora seja possível construir as peças mecânicas a partir da própria cerâmica, é muito mais barato construi-las com os materiais convencionais, geralmente aço, e revesti-las com um material que lhes proteja contra o atrito.

Nanorrevestimento

Para testar o nanorrevestimento, os engenheiros utilizaram uma técnica chamada deposição por laser pulsado para depositar uma finíssima camada da liga na superfície interna dos pistões de bombas hidráulicas, um equipamento de grande uso na indústria e em máquinas e tratores de grande porte.

Os testes iniciais mostraram um decréscimo do atrito em relação à superfície não-tratada de pelo menos uma ordem de magnitude. O nanorrevestimento também se mostrou superior aos revestimentos de diamante e ao diboreto de titânio isoladamente.

Várias indústrias já se interessaram pelo nanorrevestimento antiatrito e estão testando sua aplicação em seus próprios equipamentos. O próximo trabalho da equipe será o desenvolvimento de métodos de aplicação do revestimento mais econômicas e mais facilmente aplicáveis no ambiente industrial do que a deposição por laser pulsado.

Para conhecer outro avanço recente no campo dos lubrificantes, veja Lubrificantes de cristal líquido prometem mundo com menos atritos.

MIS lança cartilha que ensina os pais a protegerem navegação dos filhos

Entre as dicas educacionais, os documentos orientam os pais a instruir os filhos a nunca marcarem encontros com amigos virtuais e também que os conhecidos podem não ser quem dizem que são. “A educação em geral deve abordar os elementos modernos da sociedade. Portanto, nossas crianças devem ter estes 'contatos' com a conscientização na internet”, afirma o representante da Microsoft no MIS, Djalma Andrade.

O coordenador do MIS, Igor Rocha, opina que os pais ainda não estão devidamente conscientes quanto aos riscos. “Eles não fazem por mal, porque para a 'Geração Y' é importante estar antenado com a tecnologia.”

De acordo com o diretor executivo da Câmara-e.net, Gerson Rolim, o MIS está coordenando, há alguns meses, uma ação de adesão de novos parceiros, além dos já conectados ao MIS e ao movimento Navegue Protegido, base do conteúdo da cartilha. “Estamos conversando com representantes da iniciativa privada, da sociedade civil e do Governo e ONGs ligadas ao tema”, explica.

O MIS aponta que trabalhará para incluir instituições como as Associações Comerciais e o Sebrae nesta ação de conscientização das LANs Houses, locais em que as crianças e adolescentes estão longe do controle dos pais. “Quanto à fiscalização, devido à enorme quantidade e dispersão das LANs, acredito que seríamos mais efetivos trabalhando diretamente nos provedores de acesso e acionando as LANs apenas após identificado algum problema de conteúdo ilícito ali”, opina.

Carlos Felix Ximenes, representante do Google no MIS, diz que além de alertar os pais para o fato de o Orkut ser um ambiente idealizado para adultos, têm sido criadas barreiras de alerta na rede social. "Ao clicar em um conteúdo que pode ser agressivo, o Orkut avisa sobre o risco.”

Pesquisadores desenvolvem bateria de lítio que dura 8 vezes mais

O significativo aumento na capacidade foi possível graças ao uso de partículas porosas e tridimensionais de silício no eletrodo negativo. Estas partículas foram feitas de sílica e fluoreto de hidrogênio no lugar de grafite, como é feito no processo tradicional de fabricação.

Ainda que as vantagens do novo material fossem conhecidas, o silício expandia quando entrava em contato com o lítio. A equipe de Cho Jae-phil apostou em partículas porosas para resolver esse problema e aproveitar as vantagens da combinação de sílica e fluoreto de hidrogênio.

Os pesquisadores pediram patentes para quatro tecnologias na Coréia do Sul, Estados Unidos e União Européia. Segundo o professor Cho, a produção comercial para baterias com a nova tecnologia seria de quatro anos. A idéia é incorporar a descoberta no desenvolvimento de painéis solares.

Estudo: 71% dos brasileiros enviam dados corporativos a e-mail pessoal

O dado deve ser considerado um alerta diante da possibilidade de vazamento de informações, segundo Roberto Regente, diretor geral da RSA para América Latina.

De acordo com o executivo, como não é possível detectar se o usuário é bem intencionado ou não, as empresas devem recorrer a medidas de segurança para proteger as informações que saem do ambiente corporativo. "Quando um trabalho está no endereço de e-mail pessoal do colaborador, podemos afirmar que ele está em uma rede perigosa, como é a internet", explica.

Contudo, embora a mobilidade seja essencial para a agilidade dos negócios, o fato de obter informações desprotegidas pode ser considerado como um dos principais desafios no momento em que as empresas irão definir as suas políticas de segurança.

"Primeiramente, é necessário que elas procurem a sua identidade corporativa", afirma Regente. Além disso, ainda de acordo com o executivo, outro fator importante seria definir quais tipos de risco a mobilidade poderia causar para a companhia para assim, concluir as suas medidas de segurança e controle.

Ao mesmo tempo, a pesquisa ressalta que as organizações deveriam incorporar tecnologias de segurança mais convenientes, invisíveis e em camadas, capazes de reduzir os fatores que levam os funcionários a quebrar as regras e violar as políticas de segurança da própria empresa.

O estudo aponta que 94% dos colaboradores estão familiarizados com as políticas de segurança de TI de suas organizações, mas 53% sentiram necessidade de contorná-las para conseguir trabalhar.

Força do DLP

Regente aponta o DLP (prevenção de dados, da sigla em inglês) como uma tendência em tecnologia, no Brasil e no mundo, em 2009.

A pesquisa mostra ainda que 89% dos entrevistados freqüentemente realizam negócios remotamente por uma rede privada virtual. Além disso, 58% acessam o e-mail do trabalho via computador público e 65% acessam o e-mail do trabalho via wireless público.

Cerca de 80% dos colaboradores afirmaram que saem do local de trabalho transportando um dispositivo móvel com informações confidenciais relacionadas ao seu trabalho, como um laptop, smartphone ou flash drive USB.

O risco de vazamento de dados aparece quando o estudo revela que um em cada 10 funcionários perdeu um laptop, smartphone ou drive USB contendo informações corporativas, principalmente no México, atingindo 29% dos entrevistados. Os Estados Unidos apresentaram o índice mais baixo, com 5% de perdas.

A pesquisa contou com a participação de 417 entrevistados. Entre eles, 46% são profissionais de TI de empresas dos setores financeiros e de tecnologia. Mais da metade faz parte de empresas com mais de cinco mil funcionários.

Mozilla terá terceiro beta do Firefox 3.1 para corrigir bugs

Até então, a Mozilla tinha limitado o número de betas da versão 3.1 a apenas dois. Entre as novidades do próximo beta, está o modo de navegação privada e um mecanismo JavaScript mais veloz chamado “TraceMonkey”.

De acordo com o diretor do Firefox, Mike Beltzner, o terceiro beta é necessário para que a empresa sinta o quão graves são as falhas ainda existentes no navegador.

Por enquanto, a Mozilla lançou apenas o primeiro beta, enquanto a segunda versão beta do Firefox deve ser lançada no início de dezembro.

“Acreditamos que podemos fazer isso sem maiores impactos em nossa agenda de lançamentos”, afirma Beltzner, garantindo que o beta extra não atrasará o lançamento da versão final do Firefox 3.1, que deve ser lançada no primeiro trimestre de 2009.

Golpe usa phishings em nome do Orkut para espalhar cavalos-de-tróia

O golpe se trata do envio de uma mensagem pessoal ao usuário, em português, sob o tema 'paquera'. O phishing se passa por uma notificação do Orkut e oferece 3 diferentes links para um mesmo arquivo malicioso.

Nos links, supostamente seria possível bloquear e-mails de notificação ou acessar o perfil do paquera.

O cavalo-de-tróia abre uma página 'legítima' do Orkut, mas na verdade se instalará no PC da vítima para roubar senhas.

quarta-feira, 26 de novembro de 2008

Criada microfábrica química, do tamanho de um chip

Os Biochips, ou microlaboratórios - verdadeiros laboratórios de análises clínicas do tamanho de um chip de computador - aproximam-se cada vez mais da utilização prática no dia-a-dia.

Os Biochips, ou microlaboratórios - verdadeiros laboratórios de análises clínicas do tamanho de um chip de computador - aproximam-se cada vez mais da utilização prática no dia-a-dia.Mas sua utilidade vai muito além dos exames médicos, podendo viabilizar a criação de verdadeiras microfábricas, capazes de sintetizar compostos químicos de altíssimo valor agregado - uma área conhecida como química fina.

Microfábricas químicas

Agora, o pesquisador holandês Dawid Zalewski deu um passo importante rumo ao uso dos biochips de forma industrial, criando microlaboratórios que funcionam em processo contínuo, como os processos industriais normais. Até agora, os biochips somente funcionavam "em lote", processando pequenas quantidades de químicos de cada vez.

Em 15 minutos, o microlaboratório criado por Zalewski processa 25.000 vezes mais líquido do que os melhores biochips atuais, o que o qualifica como uma verdadeira microfábrica química.

Laboratórios em um chip

Os laboratórios em um chip - também conhecidos pela expressão em inglês lab-on-a-chip - são capazes de separar diversos compostos químicos, inclusive substâncias biológicas - o que cria a categoria dos biochips.

O processo mais utilizado em seu funcionamento é a eletroforese por capilaridade. Nesta tecnologia, a mistura a ser separada é inserida nos microcanais do microlaboratório, aos quais é aplicada uma alta tensão. A tensão faz com que os componentes da mistura movam-se ao longo dos microcanais.

O tamanho, o formato e a carga elétrica das moléculas afetam a velocidade com que elas se movem ao longo dos microcanais. Os componentes que se movem mais rápido chegam primeiro ao fim dos microcanais, onde são coletados.

A operação separa os diversos elementos da mistura original, na medida que eles chegam do outro lado em seqüência. Mas toda a mistura inicial deve chegar ao outro lado antes que o processo possa ser reiniciado com um novo lote de material.

Eletroforese contínua

O que o Dr. Zalewski fez foi desenvolver uma nova forma de eletroforese por capilaridade que é capaz de separar as substâncias continuamente. Ele batizou a técnica de eletroforese de fluxo contínuo sincronizado.

A separação das substâncias é feita de forma inteiramente eletrocinética, sem a utilização de partes móveis ou componentes mecânicos - como as microbombas utilizadas em diversos tipos de biochips.

A técnica usa uma variação adicional na tensão elétrica aplicada, perpendicular ao campo elétrico original. Com isto, as substâncias não são separadas apenas na direção horizontal, mas também na vertical.

Como a diferença adicional na tensão não é constante, variando ao longo do tempo, as substâncias puras saem em um movimento de onda. O coletor - a parte do microlaboratório que coleta as substâncias puras - move-se para baixo e para cima acompanhando esse movimento ondulatório. Um segundo coletor permite que a microfábrica separe duas substâncias puras simultaneamente.

Robôs éticos e morais - seis estratégias a seguir

Ética robótica

O assunto está sendo levado tão a sério que os pesquisadores norte-americanos Wendell Wallach e Colin Allen lançaram o livro Moral Machines: Teaching Robots Right from Wrong, Máquinas Morais: Ensinando aos Robôs o Certo a partir do Errado, em tradução livre.

Em vez de criar novos "mandamentos" para os robôs, a exemplo das Leis de Asimov, os autores procuraram se dirigir mais diretamente aos humanos responsáveis pela construção dessas máquinas que um dia pretende-se serem dotadas de uma inteligência capaz de permitir-lhes substituir os humanos em tarefas do dia-a-dia.

Estratégias para a construção de robôs seguros

Wallach e Allen traçaram em seu livro seis estratégias para evitar que os robôs transformem-se de ajudantes em riscos ambulantes para os próprios seres humanos.

- Mantenha os robôs em situações de baixo risco, nunca permitindo que eles tomem decisões cujas conseqüências não possam ser previstas de antemão;

- Submeta os robôs a regras, como as Três Leis da Robótica, de Asimov, que são adequadas, mas insuficientes. Há várias situações em que um robô não poderá decidir adequadamente como seguir as regras. Por exemplo, como um robô cirurgião julgará que um médico está ajudando um paciente e não tentando matá-lo? Ou então, como um robô decidirá qual ordem seguir se dois seres humanos lhe derem ordens conflitantes?

- Não dê armas aos robôs - um alerta que vem um pouco tarde, uma vez que os Estados Unidos já utilizam ativamente robôs em conflitos armados, dando-lhes inclusive a capacidade de decidir quanto atirar em alguém;

- Incorpore princípios éticos na programação dos robôs, do tipo, "Trate os outros como você gostaria de ser tratado".

- Eduque os robôs como se educa as crianças. Já existem tentativas desse tipo - veja Robô humanóide vai aprender a falar como uma criança e Robô-criança poderá aprender a falar.

- Ensine os robôs a lidar com as emoções, tornando-os capazes de obter informações não-verbais dos humanos com que eles interajam.

Alongamento e faixa japonesa aliviam dores de gestantes

A faixa-suporte, uma antiga tradição da cultura japonesa, foi testada em 17 grávidas que realizaram pré-natal em três centros de saúde de Campinas (SP). Já os exercícios de alongamento tiveram 16 voluntárias dos mesmos locais.

"Os dois grupos de grávidas relataram o alívio da dor após o início dos testes. Isto significa que ambos os métodos poderiam ser recomendados para quem está sofrendo com o incômodo na gestação", destaca a autora da pesquisa, Flávia Silva Novaes, da Universidade Estadual de Campinas (Unicamp).

Lombalgia sem medicamentos

O objetivo da pesquisa, ao propor as duas alternativas para o alívio das dores nas costas, é contemplar um público que não pode ingerir medicações em razão do estado em que se encontra.

Além disso, estimativas apontam que 50% das gestantes sofrem com lombalgia. O problema pode resultar, inclusive, na perda das capacidades funcionais. "O aumento do peso da barriga já consiste em um problema para a grávida realizar suas atividades domésticas. Com dor, este quadro fica ainda pior", argumenta.

Queimação e pontadas

Após a aplicação dos testes por três semanas, no último trimestre de gestação, Flávia utilizou escalas de dor, numérica e de carinhas para avaliar a evolução do quadro e saber em que medida os métodos foram eficientes, para traçar um perfil de cada voluntária.

Pelo relato, na maioria das gestantes - cerca de 80% -, a dor lombar teve início entre o quarto e sexto mês de gravidez. A maioria também apontou que a dor era diária, principalmente nos períodos vespertino e noturno. Segundo os relatos, as grávidas sentiam "queimação", incômodo e pontadas.

Atividades físicas e faixa para grávidas

A seqüência de exercícios de alongamento foi elaborada pela própria pesquisadora, fundamentada na literatura e na vivência profissional de atividades físicas para gestantes. Eles foram aplicados durante 30 minutos, três vezes por semana.

Já no caso da faixa-suporte, o uso foi diário. Ela foi colocada entre o quadril e a parte mais baixa do abdômen. A faixa pode ser confeccionada com tecido de algodão, com seis metros de comprimento e 30 centímetros de largura. De fácil colocação, a gestante pode ajustá-la de forma a ficar mais confortável.

"Seu custo é baixo e ela pode ser confeccionada pela própria grávida. Até por isso, resolvi realizar os testes em pacientes de Centro de Saúde, por acreditar ser uma opção para as freqüentadoras", esclarece a educadora física.

Recentemente, uma outra pesquisa demonstrou que exercícios físicos durante a gravidez melhoram o coração da mãe e do bebê.

INCA mantém restrições ao exame de toque retal

O Instituto Nacional do Câncer (INCA) emitiu nova nota a respeito dos exames de toque retal e PSA para prevenção do câncer de próstata, na qual o Instituto reafirma sua postura anterior, contrária à recomendação dos exames para homens sem sintomas, mas dizendo que os exames podem ser feitos de comum acordo entre médico e paciente.

Segundo a nota, os exames fazem parte da conduta médica quando pacientes do sexo masculino procuram um urologista. Estes exames, que podem diagnosticar doenças benignas ou malignas da próstata, devem continuar a ser feitos quando o médico, em concordância com o paciente, julgar necessário.No restante do comunicado, o INCA reafirma a posição formulada no comunicado anterior, pautando-se nas evidências científicas para afirmar que não se deve fazer uma recomendação em larga escala para a população - o chamado rastreamento. Para isso, o órgão cita os estudos científicos no qual se baseou para fazer suas afirmações.

Veja abaixo a íntegra da nota:

O exame de toque retal, a dosagem do antígeno prostático específico (PSA, na sigla em inglês), ultra-som e biópsias fazem parte da conduta médica quando pacientes do sexo masculino procuram um urologista. Estes exames, que podem diagnosticar doenças benignas ou malignas da próstata, devem continuar a ser feitos quando o médico, em concordância com o paciente, julgar necessário.

O rastreamento, por sua vez, é uma política de saúde pública que consiste em convocar toda a população que atenda a critérios específicos para fazer determinados exames. O emprego do rastreamento deve estar norteado por evidências técnicas e científicas de qualidade.

Em relação ao câncer de próstata, por não haver, até o momento, evidências científicas para que o rastreamento seja recomendado como política de saúde pública, o Instituto Nacional de Câncer recomenda que não se organizem ações de rastreamento para essa doença e que homens que demandem espontaneamente a realização de exames sejam orientados por seus médicos. O INCA continuará acompanhando o debate científico sobre o tema.

Estudos científicos

O Instituto Nacional de Câncer (INCA) não recomenda o rastreamento do câncer de próstata baseado em achados de cinco grandes estudos internacionais que concluem que a prática não reduz a mortalidade causada pela doença.

Estudo americano de 2007 diz "não existir evidência suficiente para recomendar ou para não recomendar o exame rotineiro do câncer de próstata com PSA e toque retal, uma vez que as evidências de sua efetividade são inexistentes, de baixa qualidade ou conflitantes e que o balanço entre benefícios e danos não pode ser determinado".

O canadense, de 1994, concluiu que há pobre evidência para incluir ou excluir o toque retal e satisfatória evidência para excluir o PSA e o ultra-som trans-retal do exame periódico de homens assintomáticos acima de 50 anos.

Um terceiro, europeu, de 1999, contra-indica o rastreamento para o câncer da próstata "frente à ausência de evidências demonstrando os benefícios desta tecnologia e aos riscos consideráveis do tratamento deste câncer em fase inicial".

Dois grandes estudos internacionais em curso que investigam o impacto do rastreamento do câncer de próstata na mortalidade não apresentam ainda conclusões definitivas. Ambos têm constatado excesso de diagnósticos de câncer de próstata nos grupos rastreados e a maior probabilidade de detecção de tumores com melhor prognóstico. Os resultados divulgados reiteram a necessidade de maior tempo de seguimento para demonstrar se haverá ou não redução da mortalidade do câncer de próstata com o rastreamento.

Referências

- Canadian Task Force on Preventive Health Care, 1994

(http://www.ctfphc.org/)- U.S. Preventive Service Task Force, 2007

(http://www.ahrq.gov/clinic/uspstf/uspsprca.htm)- International Network of Agencies for Health Technology Assessment, 1999

(http://www9.euskadi.net/sanidad/osteba/

datos/d_99-3_prostate_cancer_screening.pdf)- Health Technology Assessment , 1997

(http://www.hta.ac.uk/fullmono/mon102.pdf)

Compulsão por games quase nunca é 'vício', diz especialista

Keith Bakker, do Centro Smith & Jones, em Amsterdã, na Holanda, já tratou centenas de jovens desde que a clínica foi inaugurada, em 2006.

Mas o centro está mudando a maneira como cuida de seus pacientes depois de perceber que jogar videogame compulsivamente é um problema mais social do que psicológico.

Usando o tradicional modelo baseado na abstinência, a clínica foi bem-sucedida na maioria dos casos em que os jovens também apresentavam outros tipos de vício, como o abuso de drogas ou álcool.

Mas Bakker diz acreditar que os vícios múltiplos afetam apenas 10% dos jogadores compulsivos. Para os outros 90% que dizem passar pelo menos quatro horas por dia diante do videogame, o fundador da clínica duvida que o aconselhamento psicológico seja o melhor tratamento.

"Esses garotos chegam ao centro com alguns sintomas parecidos com os de outros tipos de vício ou dependência química", afirma Bakker, em entrevista à BBC.

"Mas quanto mais lidamos com eles, menos tendo a crer que possamos chamar o problema de vício. O que a maioria deles precisa é dos pais e dos professores", avalia. "É um problema social."

Intervenção

Segundo o fundador da clínica de Amsterdã, a intervenção pode ser a única maneira de quebrar o círculo vicioso para os mais jovens. Isso às vezes significa literalmente tirar a criança do computador por um tempo até ela se dar conta de seus hábitos e começar a ver que existem outras opções na vida.

"É uma escolha", diz Bakker. "Esses jovens sabem exatamente o que estão fazendo e simplesmente não querem mudar. Se ninguém ajudá-los, nada vai acontecer."

Ele afirma que, se houvesse um comprometimento maior dos pais e educadores em ouvir o que as crianças dizem, problemas como isolamento e frustração poderiam ser cortados pela raiz, levando esses jovens do mundo virtual de volta ao mundo real.

A clínica agora começou a modificar seu programa de tratamento, concentrando-se mais em realizar atividades que desenvolvam as habilidades sociais e de comunicação dos pacientes, para ajudá-los a se reintegrar à sociedade.

"O problema do jogo compulsivo é resultado da maneira como vivemos hoje em dia", afirma Bakker. "Cerca de 80% dos jovens que passam por nossa clínica sofreram abusos de colegas de escola e se sentem isolados. Muitos de seus sintomas podem ser resolvidos voltando às velhas noções de comunicação."

Ao oferecer aos pacientes um espaço onde eles se sentem aceitos e ouvidos, a clínica diz ter descoberto que a maioria conseguiu abandonar o jogo e reconstruir suas vidas.

Saiba o que é e como escolher a memória RAM do seu computador

O que é memória RAM

A sigla RAM vem de Random Access Memory, que em português significa “memória de acesso randômico” (aleatório). Na memória RAM os dados não são armazenados de forma seqüencial, como num disco rígido. Isso permite um ganho de desempenho, pois o sistema operacional não precisa se preocupar com a ordem dos dados, apenas com a posição deles.

A memória RAM é usada pelo sistema operacional e pelos softwares para carregar os arquivos e efetivamente usá-los. Ela armazena os programas e dados que estão sendo usados em determinado momento pelo computador. Enquanto você lê este texto, por exemplo, seu navegador de internet usa uma parcela da memória RAM de seu computador. Ao fechar o programa, a memória que estava sendo usada fica disponível para outros aplicativos. Ou seja: a RAM é volátil, pois armazena o conteúdo enquanto a informação em questão estiver em uso.

Importância da memória RAM

Um computador com pouca memória, ou memória de qualidade ruim, pode ter o desempenho comprometido, principalmente no uso de aplicativos mais pesados e jogos.

Cada programa consome certa quantidade de memória RAM. O Word, por exemplo, consome cerca de 99 MB; o MSN usa cerca de 50 MB, e o Windows Media Player consome 30 MB. Os navegadores usam cerca de 30 MB, mas aumentam o consumo quando você abre novas abas ou janelas.

Os sistemas operacionais têm um recurso usado para aliviar o consumo da RAM. Trata-se da memória virtual, que usa um espaço no HD (disco rígido) para armazenamento temporário de arquivos e programas. A memória virtual é útil, mas lenta. Para conhecer mais e entender como ela funciona, recomendo a leitura desta coluna, em que falei bastante sobre o assunto, e também esta outra, em que apresento meios de melhorar o desempenho de computadores populares.

O desempenho do PC começa a ser afetado quando a memória RAM chega ao seu limite – então, o sistema operacional passa a usar a memória virtual. Nesse momento, é perceptível um aumento no uso do HD, identificado pelo led presente no gabinete do computador (ele passa a piscar de forma mais intensa). É comum que, nesse momento, as telas fiquem momentaneamente congeladas, dificultando as atividades. Nesses casos, é recomendado é fechar alguns programas para reduzir o consumo de memória e até mesmo reiniciar o sistema.

Quantidade de memória

A máxima "quanto mais, melhor" se aplica neste caso. Mas como nem sempre essa filosofia pode ser colocada em prática (principalmente por conta dos gastos ou limitações citadas abaixo), vou dar dicas relacionadas aos diferentes perfis de usuários de tecnologia.

Antes disso, é importante conhecer algumas limitações no uso desse tipo de memória. O Windows XP de 32 bits, usado pela maioria das pessoas, tem um limite de 3GB de RAM. Para que o sistema reconheça mais que isso, é necessário usar o Windows XP 64 bits, desde que o processador tenha este mesmo barramento, ou o Vista, que também trabalha com esse valor de 64 bits. O Linux reconhece mais de 3 GB, mediante a configurações.

Computador no trabalho - uso básico

Para quem usa editores de textos, apresentações, planilhas eletrônicas e internet corporativa, recomendo 1 GB, caso o computador tenha o sistema operacional Windows XP ou Linux. Se a máquina rodar Windows Vista, o ideal é de 1 GB a 2 GB.

Computador no trabalho - uso intenso

Muitos profissionais usam suas máquinas para rodar programas de editoração eletrônica, de design, para trabalhar com grandes massas de dados em planilhas eletrônicas ou bancos de dados locais. Nesses casos, recomendo pelo menos 2 GB de RAM no Windows XP e Linux. Se a máquina rodar Windows Vista, o ideal é 3 GB.

Computador doméstico - uso básico

A regra aqui é a mesma para aqueles que fazem uso básico na máquina do trabalho (editores de textos, apresentações, planilhas eletrônicas e internet): 1 GB no caso do Windows XP ou Linux, de 1 GB a 2 GB no caso do Windows Vista.

Computador doméstico - uso intenso

Para quem quer o máximo em desempenho, jogar os games mais avançados e trabalhar com sobra de hardware, recomendo pelo menos 3 GB no Windows XP e Linux e pelo menos 4 GB no Windows Vista.

Tipos de memória

O formato da memória RAM é determinado pelo fabricante da placa-mãe, sendo que cada placa aceita apenas um tipo de memória. Claro que esses formatos são padronizados pelo mercado e variam na capacidade de armazenamento, velocidade de acesso e tipo de slot que podem ser encaixados. Num passado recente, existiam formatos como DRAM, SDRAM, RDRAM e outras, mas atualmente o formato mais usado é o DDR e suas evoluções DDR2 e DDR3 (veja detalhes abaixo).

Para saber mais detalhes da placa-mãe na hora da compra, pergunte ao vendedor o tipo de memória suportada (DDR2, DDR3, etc) e quantos slots -- local na placa-mãe onde ficam os pentes de memória -- disponíveis existem. Essas informações são muito importantes na hora de fazer o upgrade da máquina.

Assim como acontece nos processadores, em que a freqüência determina a velocidade de processamento das informações, a freqüência também é importante na RAM: neste caso, ela determina a velocidade com que o dados são trocados entre a memória e os demais dispositivos como processador, disco rígido, etc.

Fique atento às faixas de freqüência da memória que a placa-mãe suporta e também a freqüência das memórias que estão sendo adquiridas ou já estão no PC. Qualquer atualização requer memórias de mesmo formato e freqüência.

Formato DDR

É comum em computadores mais antigos -- atualmente, não são mais fabricadas placas com este formato de memória. Elas têm freqüências que vão de 100 MHZ até 400 MHZ e seus módulos (nomenclatura que identifica formatos e freqüências, facilitando localizar qual memória comprar) são: PC1600, PC2100, PC2400, PC2700 e PC3200.

Formato DDR2

É o padrão mais usado atualmente. Trata-se de um modelo que funciona em pares, ou seja, precisa de dois pentes idênticos de memória para funcionar. A freqüência varia de 400 MHZ até 1066 MHZ e os módulos são: PC2-3200, PC2-4200, PC2-5300, PC2-6400 e PC2-8500.

Formato DDR3

Os PCs mais poderosos do mercado contêm esse formato. Ele visa o alto desempenho por trabalhar com freqüências mais elevadas e é uma das tecnologias mais modernas. A freqüência varia de 800 MHZ até 1600 MHZ e os módulos são: PC3-6400, PC3-8500, PC3-10600 e PC3-12800.

Quantidade de memória em uso

Um programa bom para ver o tipo de memória utilizado no seu computador é o CPU-Z 1.48. Ele mostra uma visão geral, com o tipo (formato), quantidade de memória total do computador e freqüência. Além disso, permite que o usuário veja slot a slot -- no PC usado no teste, existem 4 slots e dois deles estão ocupados. Esse programa é ideal para ver o os dados na hora de realizar o upgrade da sua máquina.

Pentes

As placas de memória RAM são popularmente conhecidas como pentes. Cada pente tem uma capacidade, medida em Megabytes (MB). Se a memória for DDR2, é preciso combinar os pentes de forma simétrica, ou seja, não é possível colocar um pente de 1 GB em um PC que já possui 2 pentes de 512 MB. Em outros formatos, como o DD3, não se faz necessária essa combinação de pares.

Recomenda-se sempre termos no PC pentes de mesma freqüência, formato e capacidade. Um exemplo: para termos 4 GB de memória, podemos ter 4 pentes de 1 GB ou 2 pentes de 2 GB.

Marcas

A marca da memória RAM faz diferença na hora da compra. As chamadas genéricas são mais baratas, porém menos confiáveis. Computadores de alto desempenho e de uso em missão crítica jamais devem usar alternativas genéricas. As principais marcas do mercado são: Corsair, Kingston e Samsung.

Fonte: Fernando Panissi

Procon: empresas não estão prontas para nova lei de call centers

A fundação enviou questionários para 68 empresas do Estado de São Paulo com 14 perguntas objetivas ("sim" ou "não"). Cada companhia teve cinco dias úteis para responder ao questionário. Os resultados não são nada animadores: as empresas que estão mais bem preparadas atingiram índice de adequação de 70%, segundo o Procon.

A NET e a Telefônica, por exemplo, registraram índices de adequação de 40% e 30%, respectivamente. Para a fundação, o resultado preocupa pois essas empresas têm números altos de usuários no Estado. A Telefônica lidera há anos o ranking de reclamações fundamentadas em São Paulo.

Além disso, várias das empresas consultadas ignoraram o questionário. Entre as companhias que sequer responderam às perguntas estão a Azul Linhas Aéreas, Ocean Air, Itaú Saúde, Pró-Saúde, Blue Life, Porto Seguro, Cartão da Casa, Losango, Panamericano, Finasa, Bradesco, Mercantil, PSA, Banco Ford, Banco GM, CTBC, Caixa Econômica Federal (CEF) e Vivo.

Outra parte enviou o questionário fora do prazo e teve suas respostas consideradas inválidas. São elas: Banco BMG, Cartão Carrefour, Eletropaulo, Golden Cross, Trasmontano e Unimed. No total, isso significa que 35,3% das empresas consultadas não responderam ao levantamento.

Os dados da pesquisa feita pelo Procon foram enviados ao Ministério da Justiça, que vai acompanhar o atendimento prestado por essas empresas a seus clientes assim que as novas regras de atendimento em call centers entrar em vigor.

Submarino volta a funcionar após período de instabilidade

Usuários que tentaram acessar o Submarino se depararam com uma área incompleta e uma mensagem que informa “Página não encontrada”.

A assessoria de imprensa do Submarino informou que o site passou por uma "instabilidade momentânea" e que a situação estava sendo normalizada.

Pesquisar doenças na web aumenta ansiedade de internauta, diz estudo

Hipocondríaco, em linhas gerais, tem a ver com o medo de que sintomas comuns e pequenos possam estar relacionados a doenças sérias. No caso dos ‘cibercondríacos’, sintomas raros assustam os usuários que lêem sobre uma doença.

A conclusão se deve ao fato de muitos resultados associarem dores de cabeça a tumores cerebrais, da mesma forma que se associam à ausência de cafeína. A diferença é que as chances de um tumor de fato existir são infinitamente menores, aponta o The New York Times.

Ao pesquisar por sintomas específicos de uma doença, os usuários rapidamente se viram ansiosos, revela o levantamento. Cerca de um terço dos entrevistados continuaram as pesquisas em busca de quadros médicos sérios.

O estudo da Microsoft foi conduzido com as experiências de buscas médicas de 515 pessoas.

terça-feira, 25 de novembro de 2008

REVISTAS: Mundo Estranho Especial

Nome do Lançamento: Revista Mundo Estranho: Como as coisas funcionam

Tamanho: 27MB

Links: Homepage

Download: Multi-Servidor

REVISTAS: VEJA nº 2088

Nome do Lançamento: Revista Veja, 26 de Novembro de 2008

Tamanho: 29MB

Links: Homepage

Download: Multi-Servidor

Mudanças climáticas podem aumentar gelo no hemisfério norte

Nos últimos milhões de anos, o clima da Terra tem passado por um estado transitório, variando entre um regime estável e outro, com extremos nos intervalos, aponta estudo publicado na revista Nature.

Nos últimos milhões de anos, o clima da Terra tem passado por um estado transitório, variando entre um regime estável e outro, com extremos nos intervalos, aponta estudo publicado na revista Nature. Desaquecimento global

Segundo a pesquisa, feita por cientistas da Universidade de Edimburgo, na Escócia, e da Universidade de Toronto, no Canadá, atualmente o planeta está se aproximando de um estado de glaciação em latitudes médias no hemisfério Norte que poderá ocorrer no futuro geológico próximo.

Os autores destacam que há cerca de 3 milhões de anos têm havido flutuações climáticas intensas, alternando entre frios glaciais e extremos de calor interglacial.

Mudanças climáticas naturais

Tais alterações têm sido interpretadas como sendo principalmente respostas não-lineares do sistema climático a mudanças súbitas e cíclicas na órbita terrestre, combinadas com variações nos níveis de dióxido de carbono na atmosfera.

Mas o escocês Thomas Crowley e o canadense William Hyde apontam que essas flutuações cada vez mais pronunciadas, apesar de terem sido dirigidas por variações orbitais, seriam indicativas principalmente da "natureza transitória" própria ao sistema climático terrestre.

Um sistema que de tempos em tempos passaria por uma transição para um novo e estável estado climático. "O aumento na variabilidade no último milhão de anos indica que o sistema climático [terrestre] está se aproximando de um segundo ponto de bifurcação climático [no período], depois do qual entraria em transição novamente para um novo estado estável", descreveram.

Recaída

Segundo modelos computacionais usados na pesquisa, o próximo ponto de bifurcação climático ocorreria nos próximos 10 mil a 100 mil anos e envolveria uma grande expansão da camada de gelo no hemisfério Norte. Mas os autores destacam que as variações nos níveis de dióxido de carbono promovidas pela ação humana poderiam interromper essa transição natural de modo irreversível.

Confirmado: a matéria é resultado de flutuações do vácuo quântico

A teoria de que a matéria não tem fundações tão firmes quanto sugerem termos como "concreto" e "sólido" não é tão nova. Mas esta é a primeira vez que os cientistas conseguiram demonstrar que a matéria se origina de meras flutuações do vácuo quântico.

Modelo Padrão da Física

Uma equipe internacional de físicos demonstrou de forma conclusiva que o Modelo Padrão da física das partículas - a teoria que descreve as interações fundamentais das partículas elementares para formar toda a matéria visível no universo - explica com precisão a massa dos prótons e dos nêutrons.

"Mais de 99% da massa do universo visível é formado por prótons e nêutrons," afirma o estudo, publicado na revista Science. "Esses dois tipos de partículas são muito mais pesados do que os quarks e glúons que as constituem, e o Modelo Padrão da física deve explicar essa diferença."

O que faz com que a matéria seja matéria?

Cada próton e cada nêutron é formado por três quarks. Ocorre que esses três quarks juntos respondem apenas por 1% da massa de todo os prótons ou nêutrons. A explicação conclusiva que faltava era: Então, o que responde pelo restante da massa dessas partículas? Em outras palavras, "O que faz com que a matéria seja matéria?"

O Dr. Andreas S. Kronfeld explica que, como os núcleos atômicos formam quase todo o peso do mundo, e como esses núcleos são compostos de partículas chamadas quarks e glúons, "os físicos acreditam há muito tempo que a massa do núcleo atômico tem sua origem na complicada forma com que os glúons se ligam aos quarks, conforme as leis da cromodinâmica quântica (QCD - Quantum ChromoDynamics)."

Partículas virtuais

Os glúons são uma espécie de "partículas virtuais," que surgem e desaparecem de forma aleatória. O campo formado por essas partículas virtuais seria responsável pela força que une os quarks - a chamada força nuclear forte.

Ocorre que, como o número de interações reais e virtuais entre quarks e glúons é estimada na casa dos trilhões, é incrivelmente difícil, ou até mesmo impossível, usar as equações da QCD (cromodinâmica quântica) para calcular a força nuclear forte.

Os pesquisadores então criaram uma nova técnica, batizada por eles de Rede QCD, na qual o espaço é representando na forma de uma rede discreta de pontos, como os pixels de uma tela de computador. Este modelo permitiu que os cientistas incorporassem toda a física necessária e deu a eles o controle das aproximações numéricas e da taxa de erros nos cálculos da massa dos hádrons - prótons, nêutrons e píons.

A rede QCD reduz toda a complexidade das equações virtualmente insolúveis em um conjunto de integrais, que puderam ser programadas para solução em um programa de computador.

Isto permitiu que, pela primeira vez, os físicos incluíssem em seus cálculos as interações quark-antiquark, uma das maiores complexidades da força nuclear forte. Agora, além dos glúons, eles sabem que a massa dos quarks-antiquarks se origina da flutuação do vácuo quântico.

Diferença entre acreditar e saber

Conforme os pesquisadores, agora é possível eliminar a expressão "os físicos acreditam", substituindo-a por "os físicos sabem", quando o assunto é a QCD.

Segundo o Dr. Kronfeld, os cálculos revelaram que, "mesmo se a massa dos quarks for eliminada, o massa do núcleo não varia muito, um fenômeno algumas vezes chamado de 'massa sem massa'."

Toda a matéria do universo é virtual

A forma como a natureza cria a massa dos quarks é um dos assuntos de maior interesse dos físicos que irão trabalhar no Grande Colisor de Hádrons, o LHC,, que deverá começar a funcionar em 2009.

O LHC vai tentar confirmar experimentalmente a existência do chamado campo de Higgs, que explica a massa dos quarks individuais, dos elétrons e de algumas outras partículas. Ocorre que o campo de Higgs também cria a massa a partir das flutuações do vácuo quântico.

Ou seja, com a atual confirmação de que a massa dos glúons e quarks-antiquarks tem sua origem na flutuação do vácuo quântico, se o LHC confirmar a existência do campo de Higgs, então a conclusão inevitável será de que toda a matéria do universo é virtual, originando-se de meras flutuações de energia.

Descoberta a melhor forma para estudar. E aprender.

Combine em um só dois ditados bem conhecidos - "A prática leva à perfeição" e "Tempo é tudo" - e você terá algo muito parecido com as descobertas publicadas no último exemplar da revista Psychological Science.

O espaçamento adequado entre as aulas, dizem os pesquisadores, pode melhorar dramaticamente o aprendizado. E maiores intervalos entre as sessões de estudo resultam em melhor lembrança da matéria estudada.

De forma inverso, estudar rapidamente na véspera - seja estudar matemática para fazer uma prova ou um idioma pouco antes de embarcar para uma viagem - não funciona no longo prazo.

Orientação para os estudantes

"Não parece mais que seja prematuro que os psicólogos forneçam algumas regras amplas para aqueles que desejam usar o tempo de estudo da forma mais eficaz possível a fim de promover a maior retenção a longo prazo," escrevem os pesquisadores Hal Pashler e John Wixted, da Universidade da Califórnia, em San Diego.

Na pesquisa, mais de 1.000 voluntários participaram de três aulas. Na primeira eles ouviram fatos verdadeiros, mas obscuros, sobre a Noruega e a União Européia. A segunda sessão consistiu em uma revisão dos mesmos fatos. O tempo entre as aulas variou de poucos minutos a vários meses. O tempo de estudo foi mantido constante em todas as condições. Depois de um certo tempo, que durou até um ano para alguns participantes, todos foram testados para avaliação do conhecimento recebido nas primeiras duas aulas.

Como aumentar o aprendizado

Quando o intervalo entre a segunda aula e o teste foi aumentado, como era de se esperar, a lembrança dos fatos piorou - refletindo a curva do esquecimento familiar aos pesquisadores.

A descoberta interessante, contudo, foi que o aumento do tempo entre as duas aulas reduziu a taxa de esquecimento. Esta redução no esquecimento foi muito grande - algumas vezes aumentando a probabilidade de que a informação seria relembrada na última sessão em até 50%.

"A descoberta de que um maior espaçamento entre as sessões de estudo pode aumentar a lembrança mais tarde era esperada, baseado em pesquisas anteriores feitas ao longo do último século. Entretanto, os resultados do nosso estudo revelam um número de novos fatos que não eram conhecido," explica Pashler.

Tempo de aprender e tempo de revisar

"Em primeiro lugar, o estudo usou intervalos de tempo muito maiores do que nas pesquisas anteriores, e aconteceu que os efeitos foram maiores do que os observados nos estudos anteriores, que usaram períodos de tempo muito mais curtos.

"Em segundo lugar, os resultados mostraram que há um valor ótimo para o hiato entre a aula inicial e o teste final, e que esse espaçamento ótimo varia com o intervalo de retenção final: quando mais longo for o intervalo final, maior será o período ótimo entre o estudo e o teste," afirmam os pesquisadores.