Pesquisadores reunidos na 4ª Conferência Nacional de Ciência, Tecnologia e Inovação (CNCTI), em Brasília, apresentaram, nesta quinta-feira (27/5), um diagnóstico dos principais desafios para a ciência no país.

Produção acadêmicaApoio à ciência fundamental, retomada das altas taxas de formação de doutores, aumento do impacto internacional e investimentos focados nos centros de excelência estão entre os tópicos destacados pelos participantes da plenária "A ciência básica e produção do conhecimento: um desafio para o Brasil". A conferência se encerra nesta sexta-feira (28/5).

De acordo com Carlos Henrique de Brito Cruz, diretor científico da FAPESP, um dos conferencistas, o Brasil tem ficado ano após ano, desde o início da década de 1990, entre os quatro países com maior crescimento em número de artigos científicos publicados. Em termos qualitativos, também houve progressos importantes, com artigos de pesquisadores brasileiros tendo cada vez mais destaque em importantes revistas internacionais.

"A ciência nacional tem experimentado uma ascensão vigorosa em quantidade e qualidade. Um dos nossos desafios, nesse contexto, é a questão do impacto dessa ciência produzida no Brasil. A evolução do número de citações é crescente, mas ainda está abaixo da média mundial", destacou.

Doutores brasileirosOutro desafio, segundo Brito Cruz, é retomar o aumento na taxa de crescimento da formação de doutores. Até 2003, o número de doutores formados crescia cerca de 18% anualmente. Desde então, passou a crescer a aproximadamente 5% ao ano.

"Os números mostram que existe alguma restrição importante operando no sistema brasileiro, 'puxando o freio de mão' da formação de doutores. É preciso multiplicar por três o número de pesquisadores para o Brasil atingir patamares semelhantes ao da Espanha, por exemplo", afirmou.

Sabedoria para a humanidadeBrito Cruz destacou também o desafio de apoiar a ciência fundamental. Segundo ele, o mundo vive um momento excessivamente utilitarista e há uma pressão para que as pesquisas sirvam para fazer as empresas mais competitivas, curar doentes ou gerar riquezas. No entanto, é preciso valorizar a ciência que tem a função de tornar a humanidade mais sábia.

"Não se pode privilegiar uma vertente. É preciso ter as duas coisas. A FAPESP tem uma excelente experiência nesse sentido, oferecendo formas de apoio voltadas para projetos ousados que necessitam de cinco anos ou mais para serem realizados. A ciência básica, por não ser utilitarista, eventualmente pode precisar de prazos mais longos, especialmente em certas áreas", explicou.

Brito Cruz defendeu que a pesquisa básica receba apoio institucional. "Se o Brasil quer ter uma ciência competitiva, as instituições precisam dar ao pesquisador apoio semelhante ao oferecido pelos concorrentes. O cientista deve se preocupar em fazer ciência, não em fazer prestação de contas, ou buscar visitantes no aeroporto", disse, sob aplausos do auditório lotado.

Recursos pulverizadosSergio Danilo Junho Pena, professor da Universidade Federal de Minas Gerais (UFMG), destacou que o Brasil chegou ao 13º lugar em número de publicações - tendo ultrapassado recentemente a Holanda e a Rússia -, mas está apenas em 24º no ranking de citações. Segundo ele, vários fatores explicam o descompasso entre a força da ciência nacional e sua influência no cenário internacional.

"Um desses fatores é que a nossa pesquisa está baseada na pós-graduação. O aluno precisa partir de um projeto, com um fim já em mente e com um prazo imposto para terminar. A pesquisa resultante é muito conservadora, desprovida de inovação", disse.

Além disso, segundo Pena, outro desafio a ser enfrentado é a pulverização de recursos. "Há uma tentativa de tentar forçar o investimento pulverizado para privilegiar estados com menos recursos. Mas o correto seria investir onde já há excelência, para evoluir mais ainda no conjunto", defendeu.

Demanda criacionistaOutro desafio a ser enfrentado seria repensar o tipo de demanda feito pelas agências de fomento, que exigem projetos com começo, meio e fim perceptíveis para os avaliadores.

"Chamo isso de demanda criacionista, porque parte do pressuposto de que a ciência tem um 'design inteligente'. A metodologia da ciência não é um desenho, ela ocorre naturalmente, por seleção natural de ideias. Precisamos ser evolucionistas nesse sentido", disse.

Pena citou o cientista Linus Pauling, que dava a receita para a concepção de boas ideias: ter muitas ideias e jogar fora as ruins.

"Para identificar as ideias ruins, é preciso ter experimentação e, para isso, é preciso ter recursos. Na pesquisa de risco, é preciso apostar de vez em quando em ideias inovadoras e não apenas naquilo que já se mostra bom a priori. A solução adequada seria voltar o foco, pelo menos em alguns casos, para a trajetória do pesquisador e não exclusivamente para o projeto", disse.

Presença internacional da ciência brasileiraJacob Palis, presidente da Academia Brasileira de Ciências (ABC), chamou a atenção para a contribuição das fundações de amparo à pesquisa (FAPs) para a ascensão da ciência brasileira. "As FAPs atuam em conjunto e apresentam várias propostas de políticas públicas envolvendo órgãos da esfera federal", disse.

Para Palis, o maior desafio será multiplicar por três, até 2020, o contingente de pessoal envolvido com ciência, de técnicos de laboratório a doutores. "Temos que acelerar esse processo sem perder qualidade. Isso exigirá um esforço muito grande da comunidade científica e empresarial. Será preciso aumentar os investimentos em ciência para atingir, em dez anos, um patamar de cerca de 2% do PIB", afirmou.

Segundo Palis, a presença internacional da ciência brasileira aumenta continuamente e o país passou a atuar em instâncias como o G8+5 de Academias de Ciência, o Fórum Internacional de Ciência e Tecnologia para a Sociedade (STS Forum), a Academia de Ciências para o Mundo em Desenvolvimento (TWAS), o International Council for Sciences (ICSJU), a Rede Interamericana de Academias de Ciências (Ianas), o Interacademy Panel e o Interacademy Council.

"Possivelmente, em 2013 também estaremos no Fórum Mundial de Ciências. A cooperação internacional é vital para o nosso avanço científico", disse.

Redesenho institucional e conceitualSegundo Jailson Bittencourt de Andrade, do Instituto de Química da Universidade Federal da Bahia, no fim do século 20 as fronteiras entre as várias disciplinas foram apagadas, especialmente nos casos da química, biologia, física e matemática. Os principais desafios científicos, segundo ele, estão nessas fronteiras e não mais nos núcleos duros das disciplinas.

"O grande desafio é fazer um redesenho institucional e conceitual do sistema de pesquisa. Do lado conceitual, o foco não deve ser mais as disciplinas. Do lado institucional, é preciso repensar os departamentos que formam as universidades e, hoje, estão em sua maior parte obsoletos, formando barreiras à interdisciplinaridade", disse.

Segundo Andrade, a agenda do século 21 envolve a sustentabilidade e a inovação, em um contexto no qual os sistemas de energia, água, meio ambiente e alimentos estão integrados.

"Essa agenda implica uma visão sistêmica e conectada entre ciência básica e tecnológica. Nessa agenda, é preciso educar para inovar e inovar para educar", defendeu.

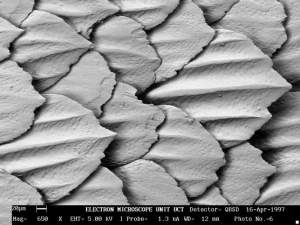

Um grupo de cientistas alemães anunciou recentemente estar tentando copiar o truque de uma samambaia para manter-se seca para criar um revestimento biônico para navios, ajudando-os a economizar até 1% de todo o combustível fóssil consumido no planeta.

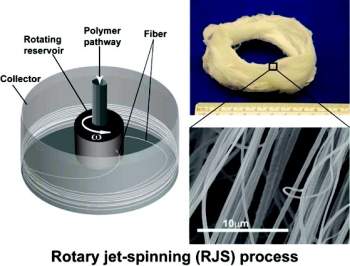

Um grupo de cientistas alemães anunciou recentemente estar tentando copiar o truque de uma samambaia para manter-se seca para criar um revestimento biônico para navios, ajudando-os a economizar até 1% de todo o combustível fóssil consumido no planeta. Com um conceito que pode ser classificado em algum lugar entre uma máquina de algodão-doce e uma centrífuga de alta rotação, engenheiros da Universidade de Harvard, nos Estados Unidos, criaram uma nova tecnologia capaz de fabricar nanofibras com alta produtividade.

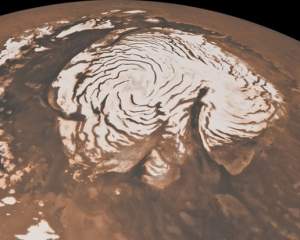

Com um conceito que pode ser classificado em algum lugar entre uma máquina de algodão-doce e uma centrífuga de alta rotação, engenheiros da Universidade de Harvard, nos Estados Unidos, criaram uma nova tecnologia capaz de fabricar nanofibras com alta produtividade. Um mistério de quase 40 anos em Marte pode agora estar sendo resolvido. Cientistas conseguiram reconstruir a formação de duas características inusitadas no polo norte do planeta: uma série de espirais e um abismo maior do que o Grand Canyon.

Um mistério de quase 40 anos em Marte pode agora estar sendo resolvido. Cientistas conseguiram reconstruir a formação de duas características inusitadas no polo norte do planeta: uma série de espirais e um abismo maior do que o Grand Canyon. Em 1905, Albert Einstein não publicou apenas a sua Teoria da Relatividade Restrita.

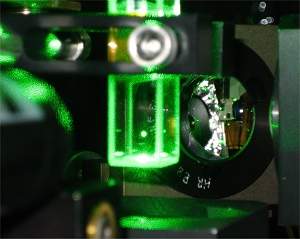

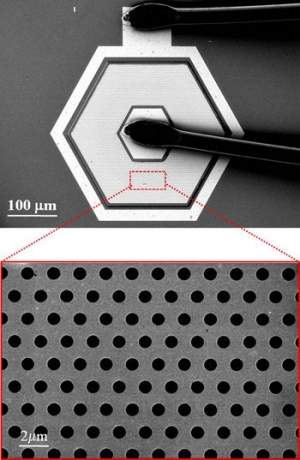

Em 1905, Albert Einstein não publicou apenas a sua Teoria da Relatividade Restrita. Pesquisadores do Instituto Politécnico Rensselaer, nos Estados Unidos, desenvolveram um novo tipo de microlente - sem lente...

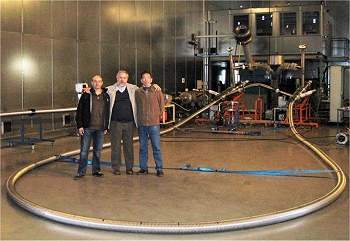

Pesquisadores do Instituto Politécnico Rensselaer, nos Estados Unidos, desenvolveram um novo tipo de microlente - sem lente... Pesquisadores da Universidade Autônoma de Barcelona, na Espanha, construíram um cabo supercondutor que bateu o recorde mundial de intensidade de corrente elétrica, atingindo 3.200 amperes a 24.000 volts.

Pesquisadores da Universidade Autônoma de Barcelona, na Espanha, construíram um cabo supercondutor que bateu o recorde mundial de intensidade de corrente elétrica, atingindo 3.200 amperes a 24.000 volts. Cientistas da Universidade de Bochum, na Alemanha, modificaram geneticamente uma drosófila (mosca-da-fruta) para torná-la capaz de "sentir o cheiro" da luz azul.

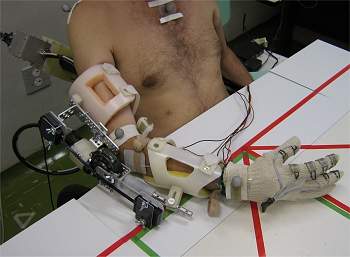

Cientistas da Universidade de Bochum, na Alemanha, modificaram geneticamente uma drosófila (mosca-da-fruta) para torná-la capaz de "sentir o cheiro" da luz azul. Pesquisadores brasileiros desenvolveram um sistema híbrido para membros superiores (braço, antebraço e mãos) que auxilia as atividades motoras de pessoas tetraplégicas.

Pesquisadores brasileiros desenvolveram um sistema híbrido para membros superiores (braço, antebraço e mãos) que auxilia as atividades motoras de pessoas tetraplégicas. Uma luva colorida e uma webcam. Este é todo o hardware necessário para operar um novo sistema de computação baseada em gestos, criada por um estudante do MIT, nos Estados Unidos.

Uma luva colorida e uma webcam. Este é todo o hardware necessário para operar um novo sistema de computação baseada em gestos, criada por um estudante do MIT, nos Estados Unidos. Um conceituado cientista britânico, tido com um dos pioneiros do mapeamento do genoma humano, alertou que se for concedida a patente da primeira forma de vida criada artificialmente, ela poderá dar ao seu criador o monopólio sobre um amplo campo da engenharia genética.

Um conceituado cientista britânico, tido com um dos pioneiros do mapeamento do genoma humano, alertou que se for concedida a patente da primeira forma de vida criada artificialmente, ela poderá dar ao seu criador o monopólio sobre um amplo campo da engenharia genética. O game "Rock band 3", prometido para o final do ano, terá um novo instrumento. Além de guitarra, baixo, bateria e do microfone, os jogadores poderão escolher o teclado para executar as músicas disponíveis.

O game "Rock band 3", prometido para o final do ano, terá um novo instrumento. Além de guitarra, baixo, bateria e do microfone, os jogadores poderão escolher o teclado para executar as músicas disponíveis.