Os desenvolvedores da Microsoft tiveram boas idéias quando projetaram o Vista, mas implementações mal feitas transformaram esses grandes conceitos em recursos ruins.

Para ser justo, o Vista herdou a maioria dessas boas intenções de versões anteriores do Windows – mas ou falhou em aperfeiçoá-los ou sequer tentou.

A seguir, listamos oito formas de resolver alguns dos problemas mais irritantes do Vista. Comecemos com uma, absolutamente exclusiva da versão mais recente do sistema operacional da Microsoft, e que é quase que universalmente odiada.

Controle de Conta do Usuário

As pessoas fazem certas coisas no Windows - como instalar aplicativos destrutivos e editar o Registro do sistema operacional – que com certeza merecem o aviso “Você tem certeza de que quer realizar essa ação?”. Tais situações podem até exigir que você seja um administrador antes de poder continuar.

Mas o Controle de Conta do Usuário (CCU, ou UAC, pela sigla em inglês) do Vista, não consegue dar resposta suficiente aos usuários; freqüentemente, ele não oferece maneiras de saber o porquê de algum ato ser considerado perigoso.

E, pior, os desenvolvedores do Vista obrigam que as pessoas cliquem numa caixa de diálogo do CCU até para ajustar o relógio e fazer um backup.

Eis três formas imperfeitas de acabar com as perturbações do CCU. O inconveniente comum a todas elas é que sempre que você dá boot no PC, o Vista avisa que o CCU está desligado. Você pode ignorar os avisos, da mesma forma que ignorava o CCU propriamente dito.

Você pode desligar por completo o CCU no painel de controle

Apenas desligue: Essa solução simples funciona bem numa conta de administrador, mas faz com que contas padrão fiquem quase inutilizáveis. Selecione Iniciar, Painel de Controle, Contas de usuários e clique em Ativar ou Desativar o Controle de Conta de Usuário. Na próxima tela, desmarque Utilizar o Controle de Conta do Usuário para ajudar a proteger o computador. Clique OK e reinicie.

TweakUAC: permite desativar a inconveniência na sua

própria conta e deixá-la intocada para as outras

Use o TweakUAC: Esse programa gratuito consegue desligar o CCU em contas de administrador e ao mesmo tempo deixá-lo ativado em todas as outras. Basta rodar o programa, selecionar Switch UAC to the quiet mode (Mudar CCU para o modo silencioso) e clicar OK.

Ajuste os detalhes de seu CCU: Isto só funciona nas versões Business ou Ultimate do Vista. Selecione Iniciar, digite secpol.msc e tecle Enter. Navegue no painel à esquerda até a pasta Configurações de segurança\Diretivas locais\Opções de segurança. No painel à direita, role a tela para baixo até ver nove opções de como o CCU deve se comportar. Se você não está certo do que essas configurações podem mudar, veja o guia do Walker News.

Se você não se importa em fazer as coisas na mão, pode

ajustar as configurações usando o Security Policies

Firewall de mão única

Os firewalls inclusos no Windows sempre sofreram do mesmo problema: apesar de bloquearem material suspeito que entra, não fazem nada com aquilo que seu PC envia.

Uma vez que um PC infectado pode enviar spam em massa e encaminhar o número de seu cartão de crédito para alguém sem as melhores intenções, essa é uma melhoria importante.

O Vista tentou arrumar tal problema ao acrescentar um firewall capaz de monitorar e bloquear tráfico de saída. Mas - acredite - o recurso fica desligado por padrão. E os desenvolvedores do SO esqueceram de colocar esses controles em um local visível: a caixa de diálogo das configurações de firewall do Windows. Duas soluções:

Ligue a proteção de saída: Clique em Iniciar, digite firewall e selecione Firewall do Windows com segurança avançada. Clique em Propriedades do Firewall do Windows. As primeiros três abas das quatro que aparecem na caixa de diálogo contém um menu drop-down Conexões de saída. Em todas as três selecione Bloquear.

Obtenha um firewall melhor: mesmo com a proteção de mão dupla ativada, o firewall do Windows é um vigia frágil. Por outro lado, o gratuito Comodo Firewall Pro se saiu muito bem em testes independentes, mesmo se comparado a produtos comerciais de renome, como o Norton Internet Security.

Você sempre poderá substituir o firewall incluso no Windows

por um freebie de qualidade, como o Comodo

Desinstalador de programas e recursos

Instalar um programa do Windows geralmente significa permitir que a rotina de instalação do software finque suas garras profundamente no sistema operacional. E remover esses programas em geral implica rodar um desinstalador que elimina a funcionalidade do aplicativo, mas deixa pra trás as garras fincadas.

Quando você remove um programa usando a ferramenta do

Windows, você deixa um caminhão de bugigangas no PC

O Vista renomeou o velho applet Adicionar e Remover Programas do Painel de controle como Programas e recursos, mas os desenvolvedores não mudaram nada nele. Tudo o que ele faz é abrir o desinstalador do aplicativo que se quer apagar.

Como melhor alternativa, baixe o Revo Uninstaller, gratuito. Assim como a função Programas e Recursos do Vista, o Revo oferece uma interface conveniente para abrir os desinstaladores próprios de cada programa. Mas, após isso, o Revo limpa a bagunça que ficou pra trás.

Lista de itens recentes

Outra execução desastrosa de uma boa idéia remonta ao Windows 95 – e ainda não foi consertada. Claro, é muito bom ter uma lista dos arquivos que você usou automaticamente atualizada e convenientemente localizada.

Mas os desenvolvedores do Windows não conseguiram perceber que existem alguns tipos de arquivo aos quais você retorna, e outros que não. É muito provável que se abra novamente um .doc, mas talvez não um .jpeg.

Talvez um fotógrafo tenha essa situação invertida. Mas simples parâmetros pré-definidos de usuários podem resolver ambos os problemas.

ActualDoc: separe seus itens recentes por categorias

Já que a Microsoft não nos deu essa opção, use o ActualDoc, da Flexigensoft. Essa ferramenta poderosa fornece listas separadas para documentos, fotos e outros tipos de arquivos. O programa pode ainda proteger as listas com senha para preservar sua privacidade.

A versão Pro, que custa 20 euros, oferece categorias definidas por usuários e outras ferramentas.

Captura de telas

O Vista teve uma melhoria significativa em relação ao XP no que diz respeito a captura de telas. A ferramenta Snipping Tool pode capturar uma janela única, um retângulo ou um formato de livre escolha.

Mas mesmo assim não pode mostrar o que o ponteiro do mouse está fazendo, além de ficar devendo um cronômetro de disparo. Sem ele, fica muito difícil pegar uma imagem de um menu drop-down.

WinSnap: melhora os recursos de Print Screen do Vista, por 25 dólares

Por 25 dólares, o WinSnap permite capturar o ponteiro do mouse, e você pode estabelecer um atraso (em milésimos, se você quiser ser preciso). Um recurso particularmente legal: ele pode capturar as múltiplas janelas de um aplicativo ao mesmo tempo em que ignora todo o resto que estiver na tela (apesar de que nem sempre isso funciona direito).

O programa tem ainda ferramentas para ajustar a cor e visual da tela capturada. E é portátil, ou seja, você não precisa instalá-lo.

Fonte: PcWorld

O horário de verão entrará em vigor no Brasil a partir do dia 19 de outubro (domingo), à 0h, e vai até o dia 15 de fevereiro de 2009. Neste período, o horário nas regiões Sul, Sudeste e Centro-Oeste deverão ser adiantados em uma hora. E a Microsoft avisa que está colocando à disposição dos usuários um HotFix para alterar o relógio do Windows automaticamente.

O horário de verão entrará em vigor no Brasil a partir do dia 19 de outubro (domingo), à 0h, e vai até o dia 15 de fevereiro de 2009. Neste período, o horário nas regiões Sul, Sudeste e Centro-Oeste deverão ser adiantados em uma hora. E a Microsoft avisa que está colocando à disposição dos usuários um HotFix para alterar o relógio do Windows automaticamente. Na segunda feira, dia 22, começou a primavera, e coincidentemente surgiu uma pequena mancha solar. Tão pequena que já no dia 24 ela tinha desaparecido, durando dois dias ou menos. Manchas solares vêm e vão e possuem um ciclo de 11 anos, alternando períodos de alta intensidade, caracterizado por um grande número delas, e períodos de baixa atividade solar, quando poucas manchas aparecem no Sol. Estamos justamente em um período de mínimo solar, com poucas manchas visíveis.

Na segunda feira, dia 22, começou a primavera, e coincidentemente surgiu uma pequena mancha solar. Tão pequena que já no dia 24 ela tinha desaparecido, durando dois dias ou menos. Manchas solares vêm e vão e possuem um ciclo de 11 anos, alternando períodos de alta intensidade, caracterizado por um grande número delas, e períodos de baixa atividade solar, quando poucas manchas aparecem no Sol. Estamos justamente em um período de mínimo solar, com poucas manchas visíveis.

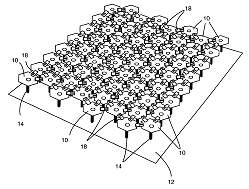

Utilizando uma técnica de construção inspirada na forma como são fabricados os hologramas, engenheiros estão desenvolvendo um novo tipo de antena que irá deixar a fuselagem dos aviões mais limpa e aerodinâmica.

Utilizando uma técnica de construção inspirada na forma como são fabricados os hologramas, engenheiros estão desenvolvendo um novo tipo de antena que irá deixar a fuselagem dos aviões mais limpa e aerodinâmica.

A Bolsa de Valores de São Paulo (Bovespa) encerrou a segunda-feira (29) com baixa de 9,36%, aos 46.028 pontos - uma queda de cerca de 40% em relação ao pico histórico dos negócios, atingido em maio deste ano.

A Bolsa de Valores de São Paulo (Bovespa) encerrou a segunda-feira (29) com baixa de 9,36%, aos 46.028 pontos - uma queda de cerca de 40% em relação ao pico histórico dos negócios, atingido em maio deste ano.

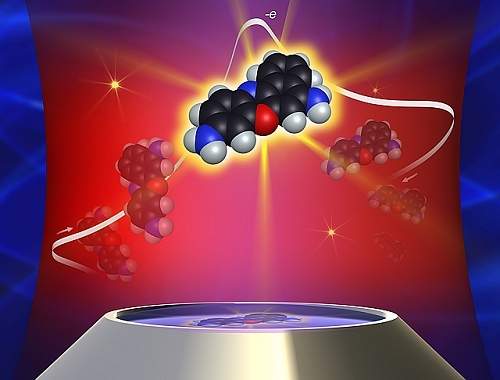

Em Abril do próximo ano, astrônomos da NASA terão pela primeira vez a oportunidade de observar por breves instantes - 8 minutos no total - uma camada secreta do Sol.

Em Abril do próximo ano, astrônomos da NASA terão pela primeira vez a oportunidade de observar por breves instantes - 8 minutos no total - uma camada secreta do Sol. Se você pensa que vai fugir dos livros e dos estudos na graduação de gastronomia, pode esquecer. O curso exige criatividade, inovação e muitas horas de vastas pesquisas pelo sabor inesquecível ou por uma apresentação de mestre.

Se você pensa que vai fugir dos livros e dos estudos na graduação de gastronomia, pode esquecer. O curso exige criatividade, inovação e muitas horas de vastas pesquisas pelo sabor inesquecível ou por uma apresentação de mestre. Você vai ao supermercado e compra um congelado. Chega em casa e: surpresa! O alimento não está lá essas coisas. Pode ter havido descongelamento na hora de transportar a carga, problemas de armazenagem ou outras inúmeras hipóteses de falhas. O fato é que, em cada etapa, desde a produção até o consumo, há engenheiros de alimentos envolvidos. E são eles, junto de profissionais da química, biologia, nutrição, que podem melhorar a qualidade do produto industrializado que chega à sua mesa.

Você vai ao supermercado e compra um congelado. Chega em casa e: surpresa! O alimento não está lá essas coisas. Pode ter havido descongelamento na hora de transportar a carga, problemas de armazenagem ou outras inúmeras hipóteses de falhas. O fato é que, em cada etapa, desde a produção até o consumo, há engenheiros de alimentos envolvidos. E são eles, junto de profissionais da química, biologia, nutrição, que podem melhorar a qualidade do produto industrializado que chega à sua mesa. Um profissional responsável pela conservação, preservação e proteção das áreas florestais do país. É desta maneira que o professor Fábio Poggiani, diretor do curso de engenharia florestal da Escola Superior de Agricultura Luiz de Queiroz da Universidade de São Paulo (Esalq/USP), define a função do engenheiro florestal.

Um profissional responsável pela conservação, preservação e proteção das áreas florestais do país. É desta maneira que o professor Fábio Poggiani, diretor do curso de engenharia florestal da Escola Superior de Agricultura Luiz de Queiroz da Universidade de São Paulo (Esalq/USP), define a função do engenheiro florestal. Imaginar o mundo sem energia elétrica hoje em dia é uma tarefa árdua. Atividades simples, como pegar a água na geladeira, ler um livro à noite antes de dormir ou aquecer um copo de leite no microondas seriam impossíveis sem a figura do engenheiro eletricista. A carreira, com inúmeras áreas de atuação.

Imaginar o mundo sem energia elétrica hoje em dia é uma tarefa árdua. Atividades simples, como pegar a água na geladeira, ler um livro à noite antes de dormir ou aquecer um copo de leite no microondas seriam impossíveis sem a figura do engenheiro eletricista. A carreira, com inúmeras áreas de atuação. Projetar uma aeronave, construí-la e cuidar de sua manutenção periódica são as três principais funções de um engenheiro aeronáutico. Com escassez de profissionais no mercado de trabalho – porque apenas duas universidades públicas brasileiras oferecem o curso – a carreira de engenharia aeronáutica está em expansão e os profissionais são cada vez mais disputados. Há outros cursos oferecidos por instituições particulares, mas, de acordo com os professores ouvidos pela reportagem, essas outras graduações são menos valorizadas.

Projetar uma aeronave, construí-la e cuidar de sua manutenção periódica são as três principais funções de um engenheiro aeronáutico. Com escassez de profissionais no mercado de trabalho – porque apenas duas universidades públicas brasileiras oferecem o curso – a carreira de engenharia aeronáutica está em expansão e os profissionais são cada vez mais disputados. Há outros cursos oferecidos por instituições particulares, mas, de acordo com os professores ouvidos pela reportagem, essas outras graduações são menos valorizadas.