O Brasil foi uma das primeiras grandes economias a superar a crise global, deve crescer mais de 7% neste ano, vem reduzindo a pobreza e melhorando em vários indicadores sociais.

Mas o país chegará algum dia a se tornar uma nação considerada desenvolvida? E o que falta para isso acontecer?

"O Brasil precisa melhorar a qualidade da educação pública", diz o editor para as Américas da revista britânica The Economist, Michael Reid.

"É necessário que o Brasil amplie a sua classe média", afirma o economista Jim O'Neill.

"O Brasil precisa aumentar a taxa de poupança interna para acima de 30% do PIB", sugere o comentarista econômico do jornal britânico Financial Times.

A poucos dias das eleições presidenciais, esses e outros especialistas estrangeiros, ouvidos pela BBC Brasil, listaram os desafios que o país ainda enfrenta para chegar à condição de nação desenvolvida.

Economistas, acadêmicos, representantes de organizações internacionais, think- tanks e organizações não-governamentais afirmam que o Brasil ainda tem muito a fazer em áreas que incluem redução da desigualdade, a melhoria da educação, reformas nas instituições públicas, combate à corrupção, combate à violência e até mesmo respeito ao meio ambiente e aos direitos humanos.

"O Brasil está vivendo um momento excepcional, fruto de décadas de trabalho árduo. Porém nenhum desenvolvimento acontece sem obstáculos, e os desafios permanecem", diz o economista senegalês Makhtar Diop, diretor do Banco Mundial para o Brasil.

Pobreza e desigualdadeA economia brasileira se consolidou como a 8ª maior do mundo neste ano, mas o país ainda é apenas o 72º do mundo em renda per capita, atrás de países como Argentina (50º), México (53º), Turquia (57º), Venezuela (66º) e Irã (68º), segundo dados do Banco Mundial.

Nos últimos oito anos, segundo dados do IBGE (Instituto Brasileiro de Geografia e Estatística), o crescimento econômico ajudou a tirar mais de 20 milhões de pessoas da pobreza. Mas dados do Banco Mundial mostram que o Brasil ainda tinha, em 2007, 12,7% de sua população vivendo abaixo da linha de pobreza, com menos de US$ 2 por dia. Há 30 anos, esse porcentual era de 31,1%.

Para efeito de comparação, a China, que em 1981 tinha 97,8% de sua população vivendo abaixo da linha de pobreza, chegou a 2005 com 36,3%. Segundo os critérios do Banco Mundial, o percentual de pobres nos principais países desenvolvidos é próximo de zero.

O Brasil também continua sendo um dos mais desiguais do mundo - de acordo com o coeficiente de Gini, calculado pelo Programa das Nações Unidas para o Desenvolvimento (PNUD), o Brasil tem a 11ª maior desigualdade entre ricos e pobres no mundo.

"A desigualdade é o maior problema do Brasil. A desigualdade enfraquece o crescimento econômico e gera altos níveis de criminalidade e insegurança", observa o americano Barry Ames, diretor do departamento de ciência política da Universidade de Pittsburgh e especialista em Brasil do Centro de Estudos Latino-Americanos da instituição.

O coeficiente de Gini tem uma variação entre 0 (mais igual) e 1 (mais desigual). O coeficiente do Brasil é 0,550, melhor apenas do que Honduras, África do Sul, Bolívia, Colômbia, Angola, Haiti, Afeganistão, Botsuana, Guiné Equatorial e Namíbia.

Os países menos desiguais do mundo, segundo o PNUD, são Dinamarca e Japão, com coeficientes 0,247 e 0,249, respectivamente. Os Estados Unidos, país mais desigual entre os países desenvolvidos, está apenas em 89º no ranking global, com coeficiente 0,408.

País de classe médiaO crescimento econômico e a redução da pobreza tiveram como efeito um fenômeno que para muitos analistas mostra o Brasil no caminho de ser um país predominantemente de classe média, característica da grande maioria dos países desenvolvidos.

Segundo um estudo publicado neste mês pela Fundação Getúlio Vargas (FGV), a classe C passou no ano passado a representar mais da metade da população brasileira (50,5%), com a incorporação de 29 milhões de pessoas entre 2003 e 2009, e ultrapassou as classes A e B em pode de compra.

"Se há uma única diferença entre uma economia tipicamente desenvolvida e uma em desenvolvimento, é talvez o tamanho de suas classes médias", diz o britânico Jim O'Neill, que como economista-chefe do banco Goldman Sachs cunhou o acrônimo BRIC para identificar os quatro gigantes emergentes Brasil, Rússia, Índia e China.

Mas os sinais positivos da economia brasileira são seguidos por problemas persistentes identificados mais comumente como "problemas de terceiro mundo", como é o caso da corrupção.

Em um ranking anual sobre percepção de corrupção divulgado pela ONG Transparência Internacional no fim do ano passado, o Brasil obteve uma avaliação levemente pior do que no ano anterior, apesar de ter subido cinco posições no ranking de 182 países, ocupando a 75ª posição.

O Brasil aparece à frente da China (79ª posição) e apenas algumas posições atrás da Itália (63ª), país que faz parte do G7, o grupo que reúne os sete países mais industrializados do mundo. Os Estados Unidos aparecem na 19ª posição, e a Nova Zelândia lidera o ranking.

Para a diretora-executiva da Transparência Internacional, Huguette Labelle, se quiser chegar ao nível de nação desenvolvida o Brasil precisa avançar nessa área. "O desafio do Brasil agora é fortalecer suas instituições, fazê-las ainda mais transparentes e melhorar suas prestações de contas ao público em todos os níveis de governo", afirma Labelle.

Educação e saúdeIndicadores sociais em áreas como educação e saúde também mostram o longo caminho que o país ainda precisa percorrer para atingir o status de país desenvolvido.

A taxa de analfabetismo no país, que em 1960 chegava a 40%, caiu a 9,7% no ano passado, segundo dados do IBGE, enquanto o acesso à educação básica foi praticamente universalizado no país, com uma elevação do acesso à escola de 86,6% em 1992 para 97,9% em 2008, entre as crianças de 7 a 14 anos.

Além disso, no período entre 1998 e 2008, o número de alunos matriculados no ensino superior no país mais que dobrou, passando de 2,1 milhões para 5,1 milhões, segundo o Ministério da Educação.

Mas se os números absolutos mostram uma evolução, a qualidade do ensino ainda deixa a desejar. Um estudo elaborado pela OCDE (Organização para a Cooperação e Desenvolvimento Econômico) em 2007 mostrou os alunos brasileiros entre os piores em conhecimentos de matemática, capacidade de leitura e ciências entre 57 países analisados.

"A melhoria da qualidade da educação pública é sem dúvida um dos pontos necessários para que o Brasil possa ser elevado à categoria de país desenvolvido", observa o jornalista Michael Reid, editor para as Américas da revista britânica The Economist.

Para o brasilianista Gonzálo Gómez Dacal, diretor do Centro de Estudos Brasileiros da Universidade de Salamanca, na Espanha, somente com a melhoria da qualidade da educação pública em todos os níveis que o Brasil será capaz de aproveitar "os recursos intelectuais de toda a população, especialmente da capacidade de criação das pessoas inteligentes que formam parte das camadas mais desfavorecidas da população".

Qualidade de vidaNa área da saúde, mais uma vez, a universalização conseguida pelo Sistema Único de Saúde convive com questionamentos sobre a qualidade do atendimento e dos programas de prevenção.

A expectativa de vida do brasileiro subiu de 66 anos, em 1991, para 72,4 em 2010, segundo dados da ONU, deixando o país no 92º lugar do ranking mundial sobre esse indicador.

O país também conseguiu reduzir a mortalidade infantil em mais de 60% nos últimos anos, de 52,04 mortes por mil nascimentos em 1990 para 19,88 a cada mil em 2010.

Ainda assim, o Brasil ainda é o 90º do ranking nesse indicador, muito aquém de países como Grécia (6,7 mortes por mil nascimentos), Estados Unidos (6,3) ou Portugal (5) e mais longe ainda dos países com menos mortes - Islândia (2,9), Cingapura (3) ou Japão (3,2).

Segundo dados do Fundo das Nações Unidas para a Infância (Unicef), pouco menos de um décimo da população brasileira ainda não tem acesso a água potável tratada, mas na área rural, essa proporção aumenta para 4 em cada 10 moradores. O acesso a esgoto chega a apenas 77% da população, e apenas 37% na área rural.

A condição brasileira é melhor do que a de outro gigante emergente, a China, que tem 88% da população com acesso a água tratada e 65% com acesso a esgoto, mas ainda está muito aquém de países desenvolvidos como Estados Unidos, (99% com acesso a água e 100% com acesso a esgoto) ou Portugal (99% e 99%).

Avanços e desafiosAs estatísticas mostram que o Brasil vem avançando nos últimos anos, em algumas áreas a passos largos e em outras a passos curtos, mas que o caminho para chegar a ser um país desenvolvido ainda é longo.

"As condições de base estão dadas para que o país se torne uma potência", afirma o representante no Brasil do BID (Banco Interamericano de Desenvolvimento), José Luis Lupo, para quem a concretização desse potencial depende de ações do governo por reformas.

"O Brasil enfrenta desafios importantes para se transformar de um país 'de renda média' para uma economia inovadora e movida pelo conhecimento", afirma a consultora suíço-americana Suzanne Rosselet-McCauley, vice-diretora do Centro Mundial de Competitividade da escola suíça de administração IMD, uma das cinco principais da Europa.

"Ainda está para ser visto se o país pode evitar a 'armadilha do rendimento médio' ao manter seus ganhos de estabilidade macroeconômica e política e se beneficiar de níveis mais altos de crescimento", avalia.

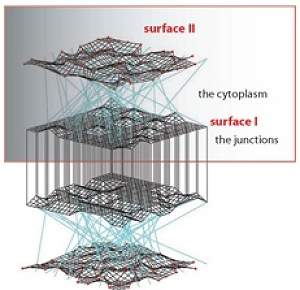

Engenheiros, arquitetos e biólogos da Universidade da Pensilvânia, nos Estados Unidos, juntaram-se para criar um novo material que tornará as casas e os edifícios capazes de reagirem às mudanças no clima.

Engenheiros, arquitetos e biólogos da Universidade da Pensilvânia, nos Estados Unidos, juntaram-se para criar um novo material que tornará as casas e os edifícios capazes de reagirem às mudanças no clima. Em escalas minúsculas, o espaço 3D com o qual estamos acostumados pode simplesmente deixar de existir, dando lugar a linhas simples, uma espécie de Flatland, o mundo plano vislumbrado na novela de Edwin Abbott, escrita em 1884.

Em escalas minúsculas, o espaço 3D com o qual estamos acostumados pode simplesmente deixar de existir, dando lugar a linhas simples, uma espécie de Flatland, o mundo plano vislumbrado na novela de Edwin Abbott, escrita em 1884. Uma equipe de cientistas da Universidade Rutgers, nos Estados Unidos, descobriu um material cujas propriedades magnéticas podem ser inteiramente controladas por um campo elétrico externo.

Uma equipe de cientistas da Universidade Rutgers, nos Estados Unidos, descobriu um material cujas propriedades magnéticas podem ser inteiramente controladas por um campo elétrico externo. O vírus da AIDS age sobre os glóbulos brancos, essenciais para a proteção contra as doenças comuns. O rápido desenvolvimento do HIV, que segundo a opinião da maioria é a doença causadora da AIDS, tem levado alguns especialistas a afirmarem que o vírus foi criado pelo homem com a finalidade de reduzir a população do Terceiro Mundo.

O vírus da AIDS age sobre os glóbulos brancos, essenciais para a proteção contra as doenças comuns. O rápido desenvolvimento do HIV, que segundo a opinião da maioria é a doença causadora da AIDS, tem levado alguns especialistas a afirmarem que o vírus foi criado pelo homem com a finalidade de reduzir a população do Terceiro Mundo. A produção conjunta de etanol e biodiesel, proposta por pesquisadores da USP, tem potencial para reduzir as emissões de gás carbônico (CO2) e melhorar o balanço energético, produzindo mais combustível a partir de uma quantidade menor de insumos.

A produção conjunta de etanol e biodiesel, proposta por pesquisadores da USP, tem potencial para reduzir as emissões de gás carbônico (CO2) e melhorar o balanço energético, produzindo mais combustível a partir de uma quantidade menor de insumos. A diferença na passagem do tempo para objetos que se deslocam em velocidades diferentes é um dos aspectos mais discutidos e menos compreendidos da Teoria da Relatividade de Einstein.

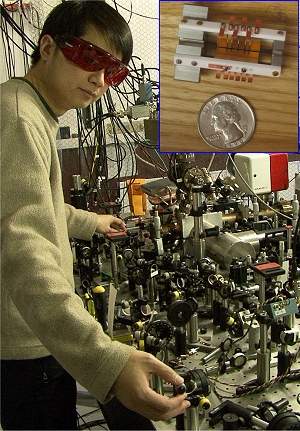

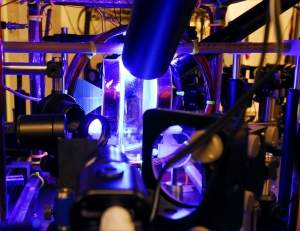

A diferença na passagem do tempo para objetos que se deslocam em velocidades diferentes é um dos aspectos mais discutidos e menos compreendidos da Teoria da Relatividade de Einstein. Cientistas do Instituto de Tecnologia da Geórgia, nos Estados Unidos, fizeram avanços em três elementos-chave necessários para os sistemas de informação quântica.

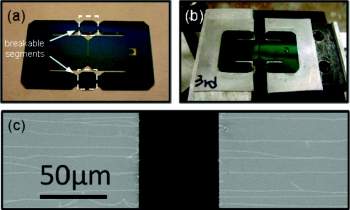

Cientistas do Instituto de Tecnologia da Geórgia, nos Estados Unidos, fizeram avanços em três elementos-chave necessários para os sistemas de informação quântica. Os nanotubos de carbono andaram meio sumidos, um pouco eclipsados pelo sucesso inesperado do grafeno, seu parente muito próximo.

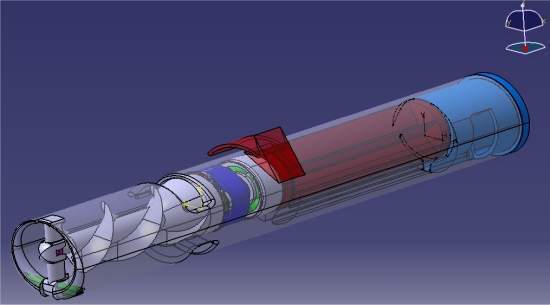

Os nanotubos de carbono andaram meio sumidos, um pouco eclipsados pelo sucesso inesperado do grafeno, seu parente muito próximo. Um grupo de médicos e engenheiros da Universidade de Viena, na Áustria desenvolveu uma microbomba capaz de manter o coração humano funcionando em condições críticas.

Um grupo de médicos e engenheiros da Universidade de Viena, na Áustria desenvolveu uma microbomba capaz de manter o coração humano funcionando em condições críticas. A medição direta dos efeitos da gravitação quântica é praticamente impossível. O motivo é que eles têm origem em locais inacessíveis ao homem, como em buracos negros. Além disso, seus efeitos são extremamente sutis.

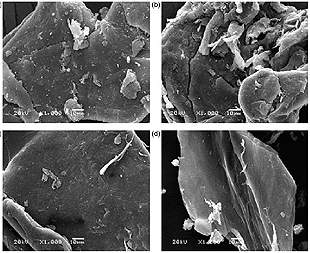

A medição direta dos efeitos da gravitação quântica é praticamente impossível. O motivo é que eles têm origem em locais inacessíveis ao homem, como em buracos negros. Além disso, seus efeitos são extremamente sutis. A quitosana - uma fibra retirada do exoesqueleto de crustáceos - pode ser uma nova aliada da ciência na despoluição dos rios e efluentes despejados pela indústria.

A quitosana - uma fibra retirada do exoesqueleto de crustáceos - pode ser uma nova aliada da ciência na despoluição dos rios e efluentes despejados pela indústria.