terça-feira, 29 de junho de 2010

Memória óptica é lida na forma de um holograma tridimensional

O feito foi possível graças a uma realização anterior da mesma equipe, quando eles desenvolveram uma técnica pioneira para parar e controlar a luz de um laser, manipulando elétrons no interior de um cristal resfriado a -270 graus Celsius - veja Memória óptica armazena e recupera pulsos de luz individuais.

Holograma read-once

Agora os cientistas alcançaram uma eficiência e uma precisão sem precedentes em sua memória óptica, permitindo que as delicadas propriedades quânticas da luz sejam armazenadas, manipuladas e lidas.

"A luz que entra no cristal é retardada ao longo do caminho até parar, onde ela permanece até que a deixemos caminhar de novo", explica o pesquisador Morgan Hedges, da Universidade Nacional da Austrália. "Quando nós a deixamos ir, capturamos essencialmente tudo o que quisermos na forma de um holograma tridimensional, com uma precisão até o último fóton."

"Devido à inerente incerteza da mecânica quântica, algumas das informações desta luz serão perdidas no momento em que elas forem medidas, o que nos dá um holograma que só pode ser lido uma vez. A mecânica quântica garante que esta informação possa ser lida somente uma vez, tornando-o perfeito para comunicações seguras."

As mesmas qualidades de eficiência e precisão tornam a memória altamente promissora para a computação quântica, que tem o potencial para ser muitas vezes mais rápida do que a computação tradicional.

Entrelaçamento e relatividade

Os pesquisadores afirmam ainda que o armazenamento de dados usando luz vai permitir a realização de experimentos inéditos de física quântica fundamental - por exemplo, como o bizarro fenômeno do entrelaçamento quântico interage com a teoria da relatividade.

"Nós poderemos entrelaçar o estado quântico de duas memórias, ou seja, de dois cristais," explica o coordenador da equipe, Dr. Matthew Sellars. "Segundo a mecânica quântica, a leitura de uma memória entrelaçada irá alterar imediatamente o que está armazenado na outra, não importando quão grande seja a distância física entre elas.

Segundo a relatividade, a forma como o tempo passa para uma memória é afetada pela maneira como ela se move. Com uma boa memória quântica, um experimento para medir esses efeitos fundamentais de interação poderia ser tão simples como colocar um cristal no banco de trás do meu carro e sair para dar uma volta," exagera o cientista.

Juntando as peças

A equipe do Dr. Sellars já havia realizado um experimento que "parou" a luz em um cristal por mais de um segundo, mais de 1.000 vezes mais do que era possível anteriormente.

Ele afirma que a equipe agora está tentando juntar os sistemas, combinando a alta eficiência com tempos de armazenamento que durem horas.

Indianos projetam moto movida por turbina a ar comprimido

Cientistas indianos divulgaram um projeto conceitual de uma motocicleta movida por uma turbina a ar comprimido.

Cientistas indianos divulgaram um projeto conceitual de uma motocicleta movida por uma turbina a ar comprimido.A fabricante de automóveis indiana Tata já possui modelos comerciais de automóveis movidos a ar comprimido.

Em outra abordagem, pesquisadores suíços estão trabalhando em um motor misto que é capaz tanto de queimar gasolina ou etanol, quanto de ser alimentado por ar comprimido - veja Veículos híbridos ganham impulso com motor pneumático.

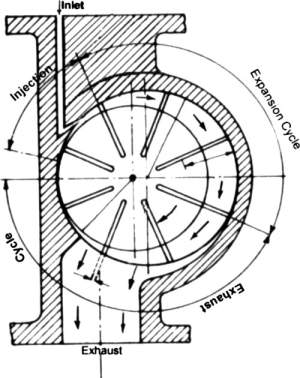

A maioria desses projetos consiste em injetar o ar comprimido nos cilindros de um motor, em tudo o mais parecido com um motor a combustão tradicional.

Moto elétrica sem bateria

Mas a ideia do Dr. Bharat Raj Singh e seus colegas do Instituto de Tecnologia de Lucknow é usar o ar comprimido para girar uma turbina. Segundo eles, o conceito poderá resultar em um veículo mais compacto, mais leve e ainda mais silencioso.

O conceito, segundo eles, também pode ser ampliado para ser empregado em automóveis.

Segundo os cientistas, o uso da turbina a ar comprimido poderia reduzir a poluição das áreas urbanas em até 60%, uma vez que os automóveis são os maiores geradores de poluentes quando queimam combustíveis fósseis.

Em seu estudo, os cientistas indianos descobriram que o rendimento da turbina pode ser amplamente melhorado pelo controle preciso da pressão de entrada do ar comprimido e pelo ângulo em que o jato de ar incide sobre a "hélice" interna que faz o eixo da turbina girar.

Motocicleta movida a ar

Mas o projeto não está pronto para ser implementado. O maior desafio a ser enfrentado pelos pesquisadores será a ampliação da capacidade do tanque de ar comprimido, mantendo-o compacto e leve o suficiente para ser utilizado em uma motocicleta.

Os tanques atuais seriam suficientes para acionar a turbina por cerca de 40 minutos, o que se traduz em uma autonomia de 30 quilômetros para a motocicleta movida a ar.

Além da possibilidade de literalmente encher o tanque, os pesquisadores planejam desenvolver um sistema que permita sua troca rápida, permitindo o reabastecimento por meio da troca do cilindro por outro cheio, o que poderá ser feito em postos de troca em mesmo em casa.

Colheita mecanizada de cana resulta em ganho ambiental

A conclusão é de um estudo realizado por pesquisadores da Escola Superior de Agricultura Luiz de Queiroz (ESALQ) da USP, em Piracicaba (SP), que acaba de ser publicado na revista científica Global Change Biology Bioenergy.

Balanço de carbono do etanol

Além de destacar a importância de sistemas agrícolas conservacionistas na produção de bioetanol, o trabalho descreve o balanço completo de carbono do etanol de cana-de-açúcar no Brasil.

O estudo enfatiza pontos positivos em relação à agricultura como, por exemplo, ao invés de emitir gás carbônico durante o processo de colheita da cana, retirar esse gás da atmosfera e estocá-lo no solo, ou seja, provocar o sequestro de carbono.

O artigo faz esses balanços e estabelece relações entre a cana colhida manualmente e a cana colhida mecanicamente, enfatizando a produção da cana em si e o seu processamento para a fabricação do etanol.

"Nós trabalhamos de uma forma mais ampla, com o que chamamos de análise de ciclo de vida em relação à sustentabilidade do biocombustível. No caso do etanol, estudamos desde a produção da cana e, eventualmente, alguma mudança de uso da terra que possa ter existido, até a combustão do etanol," ressalta o engenheiro agrônomo Marcelo Valadares Galdos, um dos autores do artigo.

"Existem vários estudos no Brasil que revelam que há uma redução de 60% a 90% de emissões em relação à produção de etanol se comparados à de gasolina", acrescenta o pesquisador.

Porém, um fato muito importante na avaliação do engenheiro agrônomo é que os estudos realizados na Esalq vão além daquilo que já existe publicado, que é justamente o fato de o texto ter um desdobramento no qual é inserido o papel do solo.

"Os estudos que já existem só incluem as emissões, o que é um aspecto negativo. Incluindo avaliações do solo, tentamos mostrar um dos pontos principais que consiste no fato dele próprio abater uma parte dessas emissões. Somente no primeiro metro de profundidade, o solo tem três vezes mais carbono do que na atmosfera", assegura Galdos.

Sequestro de carbono

Com base no conhecimento dos solos brasileiros e suas diferenças, é possível apontar em que regiões e climas é possível sequestrar carbono e por quanto tempo isso pode ser feito, uma vez que eles também têm um limite de carbono que podem sequestrar.

"Hoje, temos informações de que solos mais pobres em carbono possuem um amplo espaço para aumentar esse teor e, o que queremos enfatizar é que isso deve-se à potencialidade da cana-de-açúcar. É um benefício realmente", enfatiza o estudioso.

Outro dado importante incorporado ao balanço foi a questão da fuligem, que antes não era considerada em trabalhos similares. "Esse material particulado da cana-de-açúcar provoca aquecimento global e por isso incluímos no nosso balanço, pois pesquisas anteriores só incluíam os principais gases de efeito estufa como o dióxido de carbono, o metano e o óxido nitroso", lembra o pesquisador.

Queima da cana versus colheita mecanizada

Sobre os processos de colheita manual e colheita mecanizada, Galdos explica que "a queima implica em um menor aporte de matéria orgânica e nutrientes no solo. Portanto, ao colher a cana mecanicamente, sem queima, deixando-se a palhada sobre o solo, o ganho ambiental é duplo: deixa-se de emitir gases do efeito estufa que agravariam o aquecimento global, além de melhorar a qualidade do solo".

O engenheiro afirma também que "parte do carbono contido na palhada fica retido no solo e pode compensar emissões de gases de efeito estufa na produção da cana-de-açúcar no campo e de etanol na usina".

O pesquisador lembra ainda que sob certas condições, esse carbono retido no solo pode ser maior do que as emissões no processo de produção de cana-de-açúcar e de etanol".

No balanço feito por Galdos, com colaboração de pesquisadores da USP, da Universidade do Estado de Ohio (Estados Unidos) e do Instituto de Pesquisas para o Desenvolvimento (França), ficou claro que a colheita mecanizada é mais vantajosa, pois ela provoca apenas um quarto das emissões que causam o efeito estufa, além de sequestrar mais carbono para o solo.

"Nós fizemos os cálculos comparando os sistemas de colheita manual e mecanizada, para chegar a um balanço e comparar quais seriam as vantagens e desvantagens de um e de outro em relação ao potencial causador do aquecimento global ou até ajudar a reduzir as emissões. A cana colhida crua não provoca emissões pela queima de biomassa", diz ele.

Nesse aspecto, o pesquisador considera importante destacar que as usinas estão se organizando para acelerar esse processo de substituição de cana queimada por cana crua. "Mostrar boas práticas de manejo pode abrir portas para exportação de etanol. Esse aspecto mercadológico de sustentabilidade na produção do etanol pode gerar grandes benefícios ambientais", finaliza.

Microscópio permite ver coração de pulga batendo

Um microscópio que está sendo mostrado em Londres permite observar o coração de uma pulga d'água batendo.

O microscópio está exposto em uma feira de inovações da ciência, engenharia e tecnologia da Royal Society, entidade britânica de promoção da ciência que está completando 350 anos em 2010.

Tumores cancerígenos

O equipamento permite examinar espécies em vários níveis de foco.

No caso da pulga d'água, é possível ver sua carapaça, dar um zoom em seu coração e em seu olho, e observar até mesmo células do inseto individualmente.

Os criadores do microscópio acreditam que ele poderá ter várias utilidades, como por exemplo examinar tumores cancerígenos.

Sistema óptico sem fios revoluciona comunicações submarinas

"Esta combinação de recursos torna possível operar robôs submarinos a partir de navios na superfície sem a necessidade de uma conexão física com o robô," explica Norman E. Farr, que liderou a equipe que desenvolveu a nova tecnologia de comunicação submarina.

Robôs submarinos

Os robôs submarinos são largamente utilizados na exploração petrolífera e nas pesquisas científicas marinhas. Apesar de eficientes, seu custo de operação é alto, exigindo a presença constante de um navio.

O fato de exigir a conexão de um cabo para transmitir os dados coletados também restringe a área de cobertura desses submarinos robóticos.

A nova tecnologia, ao permitir a transmissão de dados e vídeo de alta qualidade, em alta velocidade, diretamente através da água do mar, promete revolucionar a coleta de dados marinhos, reduzindo custos e simplificando as operações.

Transmissões acústicas

Comparada com a comunicação pelo ar, feita pelas transmissões em radiofrequência, a comunicação debaixo d'água é severamente limitada porque a água é essencialmente opaca à radiação eletromagnética, exceto na faixa visível.

Mesmo assim, a luz penetra apenas algumas centenas de metros e somente nas águas mais claras.

Isso levou ao desenvolvimento das técnicas acústicas, que hoje são o modo predominante de comunicação entre os navios e os submarinos autônomos e robóticos.

Embora permitam comunicações de longa distância, os sistemas acústicos transmitem dados em velocidades baixas e com retardos, devido à velocidade relativamente lenta do som na água.

Comunicação óptica pela água

Agora, Farr e sua equipe desenvolveram um sistema de comunicação óptica que complementa e se integra com os sistemas acústicos para permitir taxas de transmissão de dados de até 10 a 20 megabits por segundo, com um alcance de 100 metros, usando transmissores e receptores pequenos e de baixo custo, que podem ser alimentados por uma pequena bateria.

O avanço irá permitir a transferência quase instantânea de dados e vídeo, em tempo real, dos robôs submarinos para os navios na superfície ou para os laboratórios.

Os dados em tempo real permitirão que os pesquisadores aproveitem melhor os mergulhos, reagindo rapidamente às imagens e aos dados coletados pelos sensores e outros dispositivos dos robôs.

Sistema óptico-acústico

Segundo os pesquisadores, o novo sistema é seguro porque, quando o veículo sai do alcance óptico, ele ainda estará dentro da faixa acústica, podendo ser controlado da forma tradicional.

Como permite a realização das comunicações sem os pesados equipamentos de manipulação e ancoragem hoje usados, "o sistema óptico-acústico promete viabilizar pesquisas com barcos menores e com menos pessoal para executar as missões submarinas," afirma Farr.

Em última análise, prossegue Farr, o sistema irá "permitir-nos ter veículos [em locais submarinos específicos] esperando para responder a um evento. É uma revolução."

Brasileiros desenvolvem pés de café naturalmente sem cafeína

No entanto, a ideia de explorar comercialmente o café descafeinado natural foi frustrada pela baixa produtividade da planta, proveniente da Etiópia.

Agora, utilizando uma técnica para induzir as sementes à mutação, o mesmo grupo de cientistas da Universidade Estadual de Campinas (Unicamp) e do Instituto Agronômico, de Campinas (SP), obteve, a partir de um cafeeiro já utilizado comercialmente, sete plantas mutantes que combinam a produtividade e a ausência de cafeína.

Cafeeiro sem cafeína

Segundo Paulo Mazzafera, coordenador do estudo, o experimento utilizou sementes do cafeeiro comercial Catuaí Vermelho, da espécie Coffea arabica, que foram tratadas com dois tipos de mutagênicos.

As cerca de 28 mil plantas resultantes da germinação foram analisadas por um método que identificava a presença ou ausência de cafeína.

"Com o tratamento, obtivemos sete tipos de cafeeiros que são praticamente desprovidos de cafeína. São plantas bastante vigorosas que em breve produzirão flores. Vamos fazer toda a análise bioquímica e molecular dessas plantas e procuramos uma empresa brasileira interessada em implantar comercialmente esse café naturalmente descafeinado", disse Mazzafera.

O cientista explica que o campo experimental onde foi feito o experimento tem atualmente 250 plantas. Com as sementes disponíveis é possível plantar cerca de 5 hectares para testes.

"Se der tudo certo, vamos fazer mudas com essas sementes e levar tudo a campo em 2011", disse Mazzafera.

Café descafeinado

Segundo o pesquisador, o interesse comercial pelo café descafeinado é pequeno no Brasil, diferentemente do que ocorre em outros países. Cerca de 1% do café comercializado em território brasileiro é descafeinado. Enquanto isso, na Europa e nos Estados Unidos, a divulgação dos efeitos adversos da cafeína tem provocado um aumento crescente do mercado de café descafeinado.

"O café descafeinado corresponde a cerca de 10% do total do café comercializado no mundo. Certamente, é um mercado muito interessante e muito valorizado. A alternativa de um café desse segmento que não tem necessidade de passar por processos industriais para ser descafeinado é bastante promissora em termos de mercado", destacou.

Existem três processos para produção do café descafeinado. O método que emprega o solvente clormetano, o método suíço, que utiliza água para retirar a cafeína, e o método de gás carbônico supercrítico. "No método suíço, a água retira a cafeína, mas leva junto muitos elementos importantes do café. De qualquer maneira, o ponto central é que esses processos encarecem o produto", explicou Mazzafera.

Autofecundação

As plantas obtidas pelo processo só apresentaram um problema: a estrutura da flor do café normalmente garante que a planta tenha uma alta taxa de autofecundação - próxima de 95% -, mas a flor da planta mutante abre precocemente, quando ainda está imatura, e, com isso, pode não ter a mesma taxa de autofecundação.

"Como a flor abre antes, em tese ela pode receber pólen de plantas com outros teores de cafeína. O problema, no entanto, não é tão grave, porque podemos plantar lotes de café formados exclusivamente com a planta mutante, segregados dos lotes com as plantas normais. Ou podemos colocar abelhas nas plantações do material com baixo teor de cafeína, provocando assim um aumento da taxa de autofecundação entre elas", disse Mazzafera.

Um dos principais resultados do método que envolveu indução à mutação foi a economia de tempo. "O melhoramento genético tradicional poderia demorar muitos anos para chegar a gerar plantas descafeinadas produtivas", disse.

O processo mutagênico utilizado para a obtenção das plantas descafeinadas foi patenteado. "No Brasil, não podemos patentear o material, por isso patenteamos o processo. No momento em que uma companhia brasileira se interessar em implantar o café descafeinado natural, poderemos fazer uma patente internacional relativa aos produtos provenientes desse café, cobrando royalties para quem for produzir", disse.

Ministério da Saúde lança tecnologia brasileira para diagnosticar vírus H1N1

A partir de agora, o país tem capacidade de produzir os reagentes biomoleculares utilizados nos laboratórios para detectar a doença e se tornar mais independente do mercado internacional.

O kit será fabricado por um consórcio entre a Fiocruz, por meio do Instituto de Tecnologia em Imunbiológicos (Biomanguinhos) e do Instituto Carlos Chagas (ICC), com o Instituto de Tecnologia do Paraná (Tecpar). O investimento do governo federal no projeto foi de R$ 3,36 milhões.

Diagnóstico da influenza

O Brasil terá capacidade de produzir 80 mil testes por mês para o diagnóstico de Influenza H1N1, o suficiente para atender a demanda nacional. Durante a primeira onda da pandemia, entre abril e dezembro de 2009, foram realizados 73.121 testes.

Com a vacinação de mais de 82,7 milhões de pessoas até esta quarta-feira, 23 de junho, a expectativa é que caia o número de casos graves e mortes suspeitas pela doença. O exame é indicado para pacientes internados com suspeita de gripe pandêmica, em casos de surtos em comunidade fechadas e para investigar óbito.

O primeiro lote fabricado pelos laboratórios do consórcio conta com 30 mil testes para detectar a doença em pacientes internados com suspeita de gripe pandêmica. Os reagentes biomoleculares servem para multiplicar o material genético do vírus (RNA viral) de modo a tornar possível sua identificação.

Kit brasileiro

O teste brasileiro é, pelo menos, 55% mais barato que os insumos importados. O material produzido em outros países custa entre R$ 100 e R$ 150, enquanto o kit nacional custa R$ 45, aproximadamente.

Além disso, a tecnologia desenvolvida no país representa uma novidade e um avanço em relação ao diagnóstico fabricado no exterior. Ele apresenta características que tornam o teste ainda mais confiável e mais rápido. O tempo de análise é reduzido pela metade: passa de oito para quatro horas.

"Com esse projeto, o Brasil sai à frente na qualificação do diagnóstico de gripe H1N1. É uma tecnologia superior e mais segura que poderá, inclusive, ser exportada futuramente a outros países", comemorou o ministro da Saúde, José Gomes Temporão.

O kit nacional reúne em apenas um produto (que contém dois tubos) os reagentes biomoleculares utilizados para detecção do vírus. Em países como Estados Unidos, França e Alemanha - principais fornecedores mundiais de insumos para diagnóstico de H1N1 - esses materiais são vendidos separadamente e misturados pelos profissionais do laboratório. Agora, sem necessidade desse procedimento, diminuirá o risco de falha humana e desperdício na manipulação dos insumos.

Gripe pandêmica

O teste será distribuído aos três laboratórios de referência para o diagnóstico da gripe H1N1: Fiocruz, Instituto Evandro Chagas (Pará) e Instituto Adolf Lutz (São Paulo); e a três Laboratórios Centrais de Saúde Pública (Lacen) localizados no Distrito Federal, no Paraná e na Bahia. Por enquanto, o teste nacional não estará disponível para laboratórios particulares.

Esses seis laboratórios contam com novas plataformas tecnológicas para o diagnóstico da gripe pandêmica. Elas fazem parte de um projeto-piloto brasileiro para detectar o vírus H1N1 e que, futuramente, também será utilizado para diagnosticar outras doenças, como aids, dengue, hepatite, meningites e outros problemas respiratórios. A proposta do governo federal é expandir as plataformas a outros Lacens depois que o projeto-piloto for consolidado, montando uma rede nacional de diagnóstico.

As plataformas são formadas por três máquinas - dois robôs e um computador - que realizam todas as etapas de identificação do vírus H1N1 de forma automatizada, sem interferência humana. Atualmente, a tecnologia utilizada nos laboratórios habilitados para o exame é menos automatizada e, portanto, mais lenta.

segunda-feira, 28 de junho de 2010

É Notícia: Kennedy Alencar entrevista Dilma Rousseff

Caixas eletrônicos podem virar caça-níqueis nas mãos de hackers

Barnaby Jack, chefe de pesquisa da empresa de segurança IOActive Labs, irá demonstrar os métodos de "caça-níquel" nos caixas eletrônicos durante a conferência de segurança Black Hat, em Las Vegas, no final de julho.

"Os caixas eletrônicos não são tão seguros como gostaríamos que fossem", disse Jeff Moss, criador da conferência Black Hat e membro do Conselho Consultivo de Segurança do presidente norte-americano Barack Obama. "Barnaby listou uma série de ataques diferentes que fazem todo o dinheiro sair."

Jack se recusou a apresentar as técnicas antes da conferência.

Os bancos podem ficar preocupados quando ele falar, temendo que bandidos adotem seus métodos. Moss disse, no entanto, que o público vai se preocupar com o problema enfrentado pelos operadores de caixa eletrônicos, o que deve levá-los a reforçar a segurança.

Uma das principais formas de ataque é feita através de portas de comunicação, algumas vezes acessíveis a partir de fora de um caixa eletrônico, disse Moss.

"Queremos que todos saibam que há maneiras possíveis de transformar essas máquinas em caça-níqueis, assim buscarão atualizar e modernizar as máquinas", acrescentou.

Joe Grand, especialista em segurança de hardware, disse que não ficou surpreso ao saber da pesquisa de Jack.

"As pessoas estão começando a perceber que os equipamentos de hardware possuem vulnerabilidades de segurança. Medidores de estacionamento, caixas eletrônicos, tudo o que é eletrônico pode ser quebrado", disse Grand. "Muitas vezes um equipamento de hardware é apenas um computador em uma caixa diferente".

Morte de uma estrela é simulada em 3D pela primeira vez

Embora as supernovas venham sendo estudadas teoricamente por meio de modelos de computador há várias décadas, os processos físicos que ocorrem durante essas explosões são tão complexos que até agora os astrofísicos só conseguiam simular partes do processo. E apenas em uma ou duas dimensões.

Simulação 3D de uma supernova

Agora, pesquisadores do Instituto Max Planck de Astrofísica, na Alemanha, fizeram a primeira simulação em computador totalmente tridimensional, cobrindo o colapso do núcleo de uma supernova ao longo de um período de várias horas após o início da explosão.

Com isto, eles conseguiram esclarecer o surgimento das assimetrias que emergem do fundo do núcleo denso durante a fase inicial da explosão e dobram-se em heterogeneidades observáveis durante a explosão da supernova.

Supernova na Via Láctea

Embora a grande energia da explosão de uma supernova torne-a visível a grandes distâncias pelo Universo, elas são relativamente raras. Em uma galáxia do tamanho da nossa Via Láctea, em média, apenas uma supernova ocorre a cada 50 anos.

Cerca de vinte anos atrás, uma supernova pôde ser vista até mesmo a olho nu. A SN 1987A surgiu na Nebulosa da Tarântula, na Grande Nuvem de Magalhães, nossa galáxia vizinha. Essa proximidade relativa - "apenas" cerca de 170.000 anos-luz de distância - permitiu muitas observações detalhadas em diferentes bandas de comprimento de onda ao longo de semanas e até meses.

Projéteis de níquel

Uma das descobertas surpreendentes e inesperadas na supernova SN 1987A, e verificada em outras supernovas subsequentes, foi o fato de o níquel e o ferro - elementos pesados que se formam perto do centro da explosão - misturam-se em grandes aglomerados ejetados para além do envoltório de hidrogênio da estrela.

Verdadeiros projéteis de níquel foram observados propagando-se a velocidades de milhares de quilômetros por segundo, muito mais rápido do que o hidrogênio e do que o previsto por cálculos hidrodinâmicos em uma dimensão (1D) - ou seja, que foram estudados verificando-se apenas o perfil de expansão radial, do centro para fora.

Na verdade, descobriu-se que a evolução do brilho (a chamada curva de luz) da SN 1987A e das demais supernovas de colapso de núcleo, só podia ser compreendida se grandes quantidades de material pesado do núcleo (em particular níquel radioativo) fossem misturadas no envelope estelar externo, e elementos leves (hidrogênio e hélio) fossem levados para dentro do núcleo.

Simulações posteriores em duas dimensões (2D, ou seja, com a suposição de simetria axial) realmente mostraram que a estrutura esférica do envoltório da estrela é destruído durante a explosão, gerando uma mistura de material em larga escala.

Supernovas de colapso de núcleo

Mas o mundo real é tridimensional e nem todos os aspectos observados podiam ser reproduzidos pelos modelos 2D.

Os novos modelos de computador feitos pelos cientistas alemães agora mostram pela primeira vez a ruptura completa em três dimensões, desde o primeiro milissegundo após a explosão começar no interior do núcleo, até três horas depois, quando o choque irrompe da estrela progenitora.

"Nós descobrimos desvios substanciais em nossos modelos 3D em relação aos trabalhos anteriores em 2D", diz Nicolay Hammer, o principal autor do trabalho, "especialmente diferenças no crescimento das instabilidades e na propagação dos aglomerados. Não são apenas pequenas variações, o efeito determina a evolução de longo prazo e, em última instância, o grau de mistura e aparência observável das supernovas de colapso de núcleo."

As simulações estão muito mais de acordo com os dados observados da SN 1987A, sobretudo a velocidade das massas de matéria arremessadas ao espaço.

"Embora acreditemos que as diferenças entre os modelos 2D e o novo modelo 3D sejam provavelmente genéricas, muitas características [de outras supernovas] dependerão fortemente da estrutura da estrela progenitora, da energia total e da assimetria inicial da explosão," prevê Thomas Janka, coautor do estudo.

USP cria sistema de criptografia caótica para a internet

Pesquisadores da USP de São Carlos e de Ribeirão Preto desenvolveram um novo sistema de criptografia que promete maior segurança às transações bancárias e no comércio via internet.

Pesquisadores da USP de São Carlos e de Ribeirão Preto desenvolveram um novo sistema de criptografia que promete maior segurança às transações bancárias e no comércio via internet.A iniciativa irá dificultar a ação de hackers e espiões em suas tentativas de quebrar códigos de segurança na internet, por exemplo. A criptografia também é importante na codificação de arquivos em notebooks, que podem ser perdidos ou roubados.

"O sistema é inovador porque combina o método tradicional de criptografia com uma parametrização dinâmica obtida de sistemas caóticos. Até onde sabemos, é a primeira vez que esta abordagem foi feita. Com isso, conseguimos produzir um algoritmo computacional com melhorias na segurança e também na velocidade", afirma o professor Odemir Martinez Bruno, do Instituto de Física de São Carlos (IFSC) da USP.

"Um dos aspectos inovadores do novo sistema é justamente a integração entre os conceitos da física e matemática à computação", afirma Bruno, lembrando que o novo método está em processo de obtenção de patente.

Como a criptografia funciona

O professor explica que a criptografia embaralha letras, números e símbolos para codificar textos e somente pessoas autorizadas podem decodificar e recuperar o texto original. Tradicionalmente, a criptografia utiliza operações lógicas ou aritméticas simples para o embaralhamento.

Na prática, quando um usuário digita os dados de seu cartão de crédito numa transação comercial via internet, as informações são "embaralhadas" de maneira que um invasor não consiga decifrar os códigos. "Somente o banco será capaz de decifrar as informações", explica o professor.

No entanto, hoje em dia boa parte dos algoritmos aplicados na criptografia já foram quebrados. "Esse duelo entre códigos estabelecidos e os que tentam quebrá-los dura mais de dois mil anos. Tanto que a criptografia foi amplamente usada em operações militares. Muitas batalhas e mesmo guerras, foram vencidas ou perdidas pelo sucesso ou fracasso da criptografia", lembra o pesquisador.

"Atualmente, a criptografia desempenha um importante papel na economia moderna. Ela é responsável por garantir a segurança nas transações comerciais em meios eletrônicos, por exemplo", descreve Bruno.

Efeito borboleta

Pesquisas envolvendo a criptografia e sistemas caóticos já foram objeto de estudos e, nas últimas décadas, algoritmos de criptografia baseados na teoria do caos foram criados. Entretanto, esses algoritmos apresentavam severas limitações, tornando-os inseguros e demasiadamente lentos para aplicações comerciais.

Mas, o sistema desenvolvido pelos pesquisadores da do IFSC e da FFCLRP permite maior agilidade nas operações com os algoritmos e o embaralhamento é maior. "A combinação feita entre a criptografia tradicional e sistemas caóticos permitiu melhorias na segurança e maior velocidade", explica Bruno.

A teoria do caos explica o comportamento aparentemente errático e imprevisível de determinados sistemas naturais. Esses sistemas são não-lineares e seu comportamento depende fortemente de como são inicializados.

Nos sistemas caóticos, pequenas diferenças são fortemente amplificadas. Isto é bem ilustrado pelas correntes de ar atmosféricas, onde o bater de asas de uma borboleta em São Paulo pode produzir uma nevasca em Moscou - o chamado efeito borboleta.

Criptografia caótica

O sistema caótico produz uma sequência de números pseudoaleatório. Se os parâmetros iniciais do sistema caótico forem exatamente os mesmos, a sequência será sempre a mesma.

Na criptografia caótica, utilizada pelos pesquisadores brasileiros, estas sequências são utilizadas para embaralhar as mensagens.

O projeto teve início há cerca de três anos e possibilitou a criação do Grupo de Criptografia. Além do professor Odemir Martinez Bruno, integram o grupo o professor Alexandre Souto Martinez, do Departamento de Física e Matemática da Faculdade de Filosofia, Ciências e Letras de Ribeirão Preto (FFLCRP) da USP, e o bolsista Anderson Gonçalves Marco.

A pesquisa está em fase final e a Agência USP de Inovação busca empresas interessadas em licenciar o produto.

Brasil quer criar seu próprio modelo climático

Nobre, que também é coordenador executivo do Programa FAPESP de Pesquisa sobre Mudanças Climáticas Globais e membro do Painel Intergovernamental de Mudanças Climáticas (IPCC) da Organização das Nações Unidas, falou sobre os desafios e obstáculos para o desenvolvimento de modelos climáticos no país no Faculty Summit 2010 América Latina, evento promovido pela FAPESP e pela Microsoft Research.

Complexidade do clima

Ele destacou a complexidade das pesquisas climáticas, que envolvem variadas áreas do conhecimento - como física, química, biologia e hidrologia -, além de detalhes como influências do solo, da vegetação, dos oceanos e da própria atmosfera, entre outros.

"Desenvolver um modelo computacional para simulações climáticas que considere cenários futuros e projeções para vários anos é uma tarefa muito complexa. Envolve uma imensa quantidade de variáveis e depende de capacidade de processamento igualmente grande", disse à Agência FAPESP.

Diante desses desafios, por que o Brasil decidiu desenvolver um modelo próprio, quando há muitos já prontos em outros países? "O primeiro motivo é que precisamos desenvolver a capacidade do país nessa área", disse.

Segundo Nobre, formar novas gerações de pesquisadores em clima e ter autonomia nessa área é estratégico para um país que baseia boa parte de sua economia em agricultura e lidera a produção de bioenergia, com destaque para o etanol da cana-de-açúcar.

Outro motivo é se manter na vanguarda da modelização do clima. "Precisamos desenvolver também as novas gerações de modelos climáticos", apontou.

Modelo climático brasileiro

A autonomia brasileira na área também beneficia outros países, especialmente os latino-americanos vizinhos, que partilham de sistemas climáticos próximos. A troca de informações seria útil também para nações africanas. Esses fatos justificariam a defesa de um aumento na colaboração entre pesquisadores do "Sul", incluindo a Índia.

No entanto, o desenvolvimento brasileiro na modelagem climática está limitado ao número de pesquisadores que se dedicam à área. Atualmente, o país conta com pouco mais de meia centena de profissionais especializados na construção de modelos climáticos.

"O que temos hoje é uma massa crítica mínima. Queremos triplicar esse número dentro de dez anos", disse Nobre. O pesquisador indica que deveremos dobrar esse número dentro dos próximos cinco anos. Outros centros avançados de modelagem climática de países desenvolvidos em pesquisa em clima contam com um mínimo de 150 especialistas, número que esse esforço nacional em modelagem climática pretende alcançar por volta do ano de 2020.

Supercomputador climático

Com exceção do número de pesquisadores, o Brasil já conta com fatores que o colocam em um lugar privilegiado na pesquisa climática. "Temos quase 20 anos de experiência no assunto, nossos modelos produzem previsões de tempo e da tendência climática sazonal com bons índices de acerto, e agora temos também infraestrutura computacional", disse Nobre.

O pesquisador se refere ao supercomputador recém-adquirido pelo Inpe com apoio da FAPESP, que tem velocidade efetiva de 15 teraflops na aplicação de modelagem e que deverá entrar em operação até o fim do ano - veja Novo supercomputador brasileiro tem desempenho superior ao esperado.

Nobre explica que a modelagem climática envolve milhares de variáveis - simulações repetidas que podem chegar, cumulativamente, a centenas de milhares de anos -, considera diferentes cenários e ainda deve apresentar boa resolução. Todos esses fatores exigem uma alta capacidade de processamento, um trabalho que só é possível para os supercomputadores.

O novo sistema de supercomputação custou R$ 50 milhões, sendo R$ 15 milhões da FAPESP e R$ 35 milhões do Ministério da Ciência e da Tecnologia, por meio da Financiadora de Estudos e Projetos (Finep). "Esse computador está entre os cinco maiores do mundo voltados à modelagem climática", disse Nobre.

Com a infraestrutura adequada, o Inpe pretende desenvolver nos próximos anos modelos climáticos de quinta geração, que integram ainda mais processos relevantes ao clima e que são, por conta disso, muito mais complexos.

Estudo propõe indústria nacional de energia nuclear

Essa cadeia deve ser capaz de atender às necessidades postas pelo Programa Nuclear Brasileiro (PNB), em sua expansão prevista para até 2030.

A parceria resultou em um estudo - encomendado pelo Ministério da Ciência e Tecnologia (MCT) ao CGEE - que posteriormente possibilitará encontros entre especialistas, representantes governamentais e do setor empresarial com vistas ao levantamento de propostas e recomendações que embasem a formulação de uma política industrial e tecnológica para o setor.

A cadeia de suprimento para geração de eletricidade a partir de usinas nucleares tem prioridade no estudo conduzido pelo CGEE. No entanto, também são abordadas as áreas de saúde, de produção industrial e do agronegócio.

Radiofármacos

Na área de saúde os radiofármacos e congêneres têm importantes aplicações em diagnósticos e terapias por parte das clínicas e hospitais do Brasil. Ampliar sua utilização deverá contribuir para a melhoria da qualidade destes serviços.

Já no agronegócio e na indústria, a questão é competitividade.

O emprego das tecnologias de irradiação em alimentos melhora suas condições de conservação e qualidade, fator determinante para o acesso dos produtos brasileiros a alguns mercados externos.

Aceitação da energia nuclear

A energia nuclear é cada vez mais aceita pela opinião pública e por grupos ambientalistas. No Brasil, pesquisas de opinião pública revelam uma aceitação que varia, em média, de 60% a 80% da população brasileira.

Entre os motivos que levaram a uma percepção positiva do setor nos últimos anos se incluem o aumento da segurança nos procedimentos de produção e os fatores ambientais, já que a geração de eletricidade com base em energia nuclear não emite gases causadores de efeito estufa.

A opção por um modelo que não polui a atmosfera é uma das vantagens competitivas da energia nuclear. "Mas a principal vantagem mesmo é econômica", afirma o presidente da CNEN, Odair Gonçalves. "A energia nuclear é mais barata que o óleo, e o valor se equipara ao do carvão e do gás natural. Além disso, exige pouco espaço de armazenamento de combustível, já que 10 g de urânio enriquecido produzem a mesma eletricidade que 1.200 kg de carvão ou 700 kg de óleo", diz.

"Num momento de intensas discussões sobre mudanças climáticas e aquecimento global, as alternativas tecnológicas de produção de energia vêm sendo repensadas pelas sociedades, e os avanços na tecnologia nuclear permitiram um olhar diferente sobre este modelo de geração de energia elétrica", afirma a assessora do CGEE, Liliane Rank, líder do estudo.

No começo da década, pesquisas mostravam que menos de 30% dos brasileiros apoiavam ou confiavam na produção de energia nuclear. Além das vantagens competitivas de apelo ambiental e econômico, a virada na opinião ocorreu a partir de 2003. "Neste ano, passamos a priorizar a transparência das informações sobre o setor", explica Gonçalves, da CNEN.

Em referência à questão ambiental, é positivo o fato de que as usinas nucleares ocupam terrenos relativamente pequenos quando comparados às extensas áreas inundadas para a instalação de usinas hidrelétricas.

Expansão Nuclear

A primeira etapa do estudo liderado por Liliane Rank, concluída em novembro de 2009, deu origem a um relatório final, "Estudo da Cadeia de Suprimento do Programa Nuclear Brasileiro: contextualização e perspectivas do setor de produção de energia nuclear no Brasil".

De acordo com Liliane, a segunda fase, iniciada no primeiro semestre de 2010, deve especificar e dimensionar a demanda de suprimentos, fundamentada na expansão prevista para o setor, além de estabelecer um diálogo entre oferta e demanda para identificar oportunidades de investimentos que fortaleçam a base industrial do país.

O Plano Nacional de Energia do governo brasileiro trabalha com cinco cenários de potência instalada no país até 2030. A energia nuclear, segundo o plano, passaria dos atuais 2,1% de participação para 3% no cenário mais modesto para a produção de origem nuclear. Ou, no cenário mais favorável, para uma fatia de até 5% em 2030.

Novas usinas nucleares no Brasil

Para alcançar esses objetivos, o Brasil construirá entre quatro e oito novas usinas nucleares em seu território nos próximos 20 anos. As obras da usina de Angra 3 começam em 2010, de acordo com a CNEN. O governo definirá, ainda este ano, a localização da quarta planta, que deverá ser instalada na região Nordeste, provavelmente no estado de Pernambuco.

"Por isso o estudo é primordial", afirma Odair Gonçalves. "Precisamos dominar a produção de algumas ligas metálicas. O estudo é fundamental principalmente para as áreas de insumos e infraestrutura", diz. Segundo Gonçalves, a expectativa é que a indústria nacional domine toda a cadeia de suprimento até 2015.

O Brasil ostenta uma situação confortável no setor, já que é um dos três países que ao mesmo tempo detêm reservas de urânio e dominam o processo de enriquecimento, ao lado de Estados Unidos e Rússia. Além disso, a tecnologia de enriquecimento de urânio é conhecida e aplicada comercialmente por apenas sete países: Brasil, EUA, França, Rússia, Reino Unido, Alemanha, Japão e Holanda.

Diferentemente de outros países, como Estados Unidos, França, Rússia e Reino Unido, o Brasil enriquece urânio com finalidade estritamente pacífica, como prevê a Constituição do país. Essa posição histórica credenciou o governo brasileiro a participar, nos últimos meses, da busca de uma solução para o impasse entre o Irã e a comunidade internacional sobre o enriquecimento de urânio pelos iranianos.

Recomendações para o setor nuclear

O resultado das ações propostas no estudo conduzido pelo CGEE contribuirá para promover a mobilização do complexo industrial nuclear brasileiro, para que ele esteja preparado para fornecer serviços, materiais e equipamentos em grau crescente de nacionalização.

Assim, de acordo com o estudo, o parque industrial do país terá condições de atender ao Programa Nuclear Brasileiro (PNB) e de contribuir para o aprimoramento da gestão de longo prazo da implantação de novas usinas, bem como o delineamento futuro de políticas públicas de incentivo a este setor.

O documento lista uma série de sugestões que devem ser adotadas pelo setor produtivo, pelo governo e por instituições brasileiras a partir de 2010: fazer um levantamento da matriz de demanda versus oferta do setor nuclear; promover uma busca na produção nacional de enxofre; verificar os montantes dos déficits projetados no tempo, em uma comparação entre a capacidade de produção agregada ao sistema e a expansão das usinas em operação, para verificar as ordens de serviços externas necessárias até 2030.

Outras recomendações incluem identificar e promover a capacitação de empresas de consultoria na seleção de locais adequados para implantação de centrais nucleares, na preparação de relatórios de segurança para o licenciamento e na elaboração de estudos de impacto ambiental para instalações nucleares.

Uma nova etapa do estudo terá por objetivo se aprofundar em temas como a produção de radiofármacos, visando o incremento nas suas aplicações na área de saúde, e na fabricação de irradiadores nacionais, mapeando a demanda para a purificação e conservação de alimentos como frutas, já que alguns países, entre eles Estados Unidos e Japão, exigem biossegurança para os produtos que importam de outras nações.

Próteses e órteses de titânio são feitas sob medida

O que era considerado ficção científica, hoje já é realidade na Faculdade de Engenharia Química (FEQ) da Unicamp.

O que era considerado ficção científica, hoje já é realidade na Faculdade de Engenharia Química (FEQ) da Unicamp.A aquisição de um equipamento denominado Sinterização Direta de Metais por Laser (DMLS - Direct Metal Laser Sintering) permite produzir próteses e órteses personalizadas, utilizando titânio - metal biocompatível, para reparação de defeitos ósseos.

Diferentemente dos processos convencionais, as novas próteses e órteses exibem excelente conformidade anatômica por terem sido projetadas especificamente para o paciente.

Cimento ósseo

Partindo de imagens médicas digitais (tomografia computadorizada ou ressonância magnética) realizadas em pacientes com defeitos ósseos ou acidentados e tratadas em software específico, um modelo 3D é gerado.

Por meio da técnica de prototipagem rápida, a peça é construída por deposição, camada por camada. Depois de pronta, a estrutura de titânio em forma de malha recebe uma camada de cimento ósseo ou biocerâmica, biomateriais desenvolvidos especificamente para essa função.

Para peças complexas, o processo demora em média cerca de uma semana para ficar pronto e a previsão de fabricação é de três peças a cada sete dias. De acordo com o professor Rubens Maciel Filho, coordenador do Instituto Nacional de Ciência e Tecnologia (INCT) em Biofabricação (Biofabris), a técnica permite dinamizar o tempo de cirurgia em 30% e, ademais, a metodologia totalmente planejada evita possíveis testes durante o procedimento cirúrgico.

"É muito mais rápido e seguro em termos de possíveis contaminações e infecções", declarou Maciel. A Unicamp é a primeira instituição de ensino e pesquisa do hemisfério sul a receber um equipamento desse porte, que teve um custo de R$ 1,4 milhão.

Prototipagem rápida na Medicina

Tradicionalmente, a prototipagem rápida tem sido muito utilizada na indústria e na engenharia de produtos como meio de produção de protótipos fiéis em curto espaço de tempo, com os ganhos voltados principalmente para o custo.

Mais recentemente, essa técnica teve sua aplicação estendida para a área médica, principalmente no que diz respeito à fabricação de implantes e próteses personalizados, estudo da anatomia e planejamento cirúrgico que compreendem importantes campos de pesquisa.

Entre os defeitos congênitos, as anomalias craniofaciais (ACF) constituem um grupo altamente diverso e complexo que, em conjunto, afeta uma significante proporção de pessoas no mundo. Além dos casos de deformidades congênitas, há ocorrências de defeitos craniofaciais adquiridos em função de outras patologias, como os tumores, por exemplo.

Nas últimas quatro décadas, um volume crescente de casos de trauma facial tem sido observado, tendo estreita relação com o aumento de acidentes automobilísticos e a violência urbana. Em todos os casos, a reabilitação craniomaxilofacial faz parte do processo de reintegração do paciente à sociedade e promoção do bem-estar e qualidade de vida das pessoas.

Biofabricação

O conceito de biofabricação consiste em utilizar técnicas de engenharia com utilização de biomateriais para construção de estruturas tridimensionais para fabricação e confecção de substitutos biológicos que atuarão no tratamento, restauração e estruturação de órgãos e tecidos humanos.

Para a professora Cecília Zavaglia, as pesquisas na Unicamp sobre os esses novos materiais avançaram muito nos últimos anos. Zavaglia inclusive foi orientadora de uma tese de doutorado responsável pelo desenvolvimento de um cimento ósseo à base de [alfa]-fosfato tricálcico, cuja principal aplicação é o preenchimento de defeitos faciais ocasionados por acidentes ou doenças congênitas.

"Estamos trabalhando há bastante tempo vários pontos em biomateriais e já identificamos avanços que podem ser feitos. Com a criação desse Instituto, poderemos colocar esses conhecimentos e juntos termos algo pronto para ser aplicado", assegurou a docente.

Órgãos e tecidos artificiais

Para o pesquisador André Jardini, também da FEQ, atualmente fala-se muito nesse desenvolvimento de próteses, biomateriais, reparação de defeitos, no entanto tudo isso já está consolidado.

Porém, outro objetivo do INCT é desenvolver, também através da técnica de prototipagem rápida, órgãos e tecidos artificiais.

"Ao invés de colocarmos o biomaterial na máquina, é possível a impressão direta de células ou de células encapsuladas em estruturas poliméricas do próprio paciente e, a partir daí, conseguir estruturar a formação de órgãos, como a bexiga, por exemplo, procedimento que já está sendo feito em algumas instituições norte-americanas", disse Jardini.

A técnica permite também construir um scaffold, que é um suporte poroso de material biorreabsorvível (biocompatível que degrada no corpo humano) colonizado por células vivas que crescerão com design do corpo humano a ser regenerado. Dentro de um biorreator, o novo órgão é desenvolvido. "Seria um processo substitutivo à doação de órgãos", resumiu.

Reconstrução de órgãos

No entanto, isso demanda muita pesquisa, pois são diferentes níveis de dificuldade para diferentes tecidos ou órgãos e seus diferentes tipos de aplicação.

"Para restaurar osso e pele é muito rápido. Estamos apenas aguardando o aval da Comissão de Ética do Hospital de Clínicas (HC) da Unicamp para fazer a cirurgia", revelou Maciel.

Com relação à reconstrução de órgãos, além da pesquisa, necessita fundamentalmente de uma forte interação entre biólogos, engenheiros e médicos, mas isso não está diferente do que está acontecendo ao redor do mundo, alerta o coordenador.

Existem, segundo ele, institutos que já estão trabalhando nesse campo há mais tempo, porém, com a competência formada na Unicamp há uma capacidade enorme de absorção desses conhecimentos e de colocar isso em prática muito rapidamente. "A finalidade do Biofabris é estar no estado da arte e avançar junto com alguns poucos centros de alto desempenho no mundo", ressaltou.

Conhecimento nacional

O Biofabris possui representante na Faculdade de Ciências Médicas (FCM), o professor William Belangero, que desenvolve pesquisas em biomateriais para ortopedia, e parceiros, como o cirurgião plástico Paulo Kharmanandayan.

Para Belangero, interações como essa entre diferentes áreas do conhecimento são extremamente importantes nos dias atuais. E no caso da ortopedia isso se reveste de uma importância ainda maior porque se trata de uma especialidade médica que utiliza muitos implantes de materiais de todos os tipos - metálicos, poliméricos e cerâmicos.

O ortopedista esclareceu que há uma busca constante por uma melhor qualidade desses materiais que serão a fonte de fabricação dos implantes, com o objetivo de atingir uma performance cada vez melhor no tratamento das lesões ortopédicas e traumáticas que envolvem o aparelho locomotor. "Porém, é também objetivo fundamental aprimorar as ferramentas que utilizaremos na fabricação desses implantes e, ainda, nos novos conceitos de tratamento", garantiu Belangero.

Maciel prosseguiu com as expectativas, deixando bem claro que a intenção do INCT é formatar e implantar um curso de pós-graduação, no qual todos os alunos terão uma visão integrada de todo o processo. Na opinião de Jardini, esse curso seria uma semente para formar pessoas capazes de fazer a ponte e gerar conhecimento nacional para posteriormente aplicar isso nas pessoas.

Biofabris

O Biofabris é um dos nove INCT com sede na Unicamp e um dos 44 no Estado de São Paulo. O programa está sob a responsabilidade do Ministério de Ciência e Tecnologia (MCT) e é organizado pelo Conselho Nacional de Desenvolvimento Científico e Tecnológico (CNPq) em parceria com a Fundação de Amparo à Pesquisa do Estado de São Paulo (Fapesp).

Essa união de competências e conhecimentos adquiridos há muito tempo, segundo Maciel, é responsável pelo desenvolvimento de técnicas que até então estavam muito distantes do alcance da população. "Hoje temos um ferramental e conceitos envolvidos, máquinas para tornar realidade o que era quase uma ficção, mesmo nos países mais desenvolvidos.

Além dos benefícios imediatos, como restaurar a qualidade de vida dessas pessoas, estamos capacitando recursos humanos e buscando competência técnica para que esses conhecimentos sejam expandidos para uso da população brasileira", afirmou o coordenador.

Ainda de acordo com o coordenador do Instituto, a população brasileira estava privada da junção de conhecimentos que pudesse levar a uma qualidade de vida melhor. "Se não começarmos, um novo processo não se inicia", disse. Para o coordenador, não se trata de começar do zero, já que o projeto possui a experiência de vários professores e, também, das parcerias. São pessoas que trouxeram o conhecimento e, associados a uma parte computacional, têm um ferramental diferenciado.

sexta-feira, 25 de junho de 2010

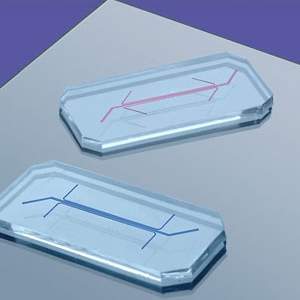

Cientistas criam pulmão eletrônico dentro de um chip

Um pulmão eletrônico acaba de ser desenvolvido por cientistas da Universidade Harvard, nos Estados Unidos. O grupo criou um dispositivo que simula o funcionamento de um pulmão em um microchip.

Um pulmão eletrônico acaba de ser desenvolvido por cientistas da Universidade Harvard, nos Estados Unidos. O grupo criou um dispositivo que simula o funcionamento de um pulmão em um microchip.Do tamanho de uma borracha escolar, o equipamento atua como se fosse um pulmão humano e é feito de partes do órgão e de vasos sanguíneos.

Por ser translúcido, o pulmão eletrônico oferece a oportunidade de estudar o funcionamento do órgão sem ter que invadir um organismo vivo.

Substituto dos animais de laboratório

Segundo os autores do estudo, o dispositivo tem potencial para se tornar uma ferramenta importante nos testes dos efeitos de toxinas presentes no ambiente ou de avaliar a eficácia e a segurança de novos medicamentos, eventualmente substituindo animais de laboratório.

"A capacidade do pulmão em um chip de estimar a absorção de nanopartículas presentes no ar ou de imitar a resposta inflamatória a patógenos demonstra que o conceito de órgãos em chips poderá substituir estudos com animais no futuro", disse Donald Ingber, fundador do Instituto Wyss, em Harvard, e um dos autores da pesquisa.

Segundo Ingber, os microssistemas a partir de tecidos produzidos até o momento são limitados mecânica ou biologicamente. "Não conseguimos entender realmente como a biologia funciona, a menos que nos coloquemos no contexto físico de células, tecidos e órgãos vivos", disse Ingber.

Funcionamento do pulmão eletrônico

Na respiração humana, o ar entra nos pulmões, preenche os microscópicos alvéolos (localizados nos finais dos bronquíolos) e transfere oxigênio por meio de uma membrana fina e permeável de células até a corrente sanguínea.

É essa membrana - formada por camadas de células pulmonares, matriz extracelular permeável e capilares - que faz o trabalho pesado do sistema respiratório. É também essa interface entre pulmão e sistema circulatório que reconhece invasores inalados, como bactérias ou toxinas, e ativa a resposta imunológica.

O pulmão eletrônico parte de uma nova abordagem na engenharia de tecidos ao inserir duas camadas de tecidos vivos - a fileira de alvéolos e os vasos sanguíneos em sua volta - em uma estrutura porosa e flexível.

O dispositivo consiste de uma membrana de silicone, porosa e flexível, coberta por células epiteliais de um lado e de células endoteliais do outro. Microcanais em torno da membrana permitem que o ar se desloque por ela. Ao aplicar um vácuo no dispositivo, a membrana se expande de modo semelhante ao que ocorre no tecido pulmonar real.

"Partimos do funcionamento da respiração humana, pela criação de um vácuo quando nosso pulmão se expande, que puxa o ar para os pulmões e faz com que as paredes dos sacos pulmonares se estiquem. O sistema de microengenharia que desenhamos usa os princípios básicos da natureza", disse Dan Huh, outro autor do estudo.

Riscos das nanopartículas

Para determinar a eficiência do dispositivo, os pesquisadores testaram sua resposta ao inalar bactérias vivas (E. coli). Eles introduziram microrganismos no canal de ar do lado do pulmão no dispositivo e, ao mesmo tempo, aplicaram leucócitos pelo canal no lado dos vasos sanguíneos.

Como resultado, no dispositivo ocorreu uma resposta imunológica que fez com que os leucócitos se deslocassem pelo canal de ar e destruíssem as bactérias.

A equipe prosseguiu nos testes com "experimentos do mundo real", segundo Huh, introduzindo vários tipos de nanopartículas no saco pulmonar do pulmão eletrônico. Algumas dessas partículas estão presentes em produtos comerciais, outras são encontrados no ar e na água poluída.

Vários tipos dessas nanopartículas entraram nas células do pulmão, levando as células a produzir mais radicais livres e induzindo a inflamação. Muitas das partículas atravessaram o pulmão eletrônico e atingiram o canal arterial.

Tinta invisível de elétrons cria nanocristais mais puros

Cientistas da Universidade de Erlangen-Nuremberg, na Alemanha, transformaram elétrons em uma versão nanoscópica de uma "tinta invisível".

Tinta de nanocristais

A equipe do professor Hubertus Marbach inventou uma técnica para o crescimento de nanocristais que permite que mensagens sejam de fato escritas sobre uma pastilha de silício, usando unicamente um feixe de elétrons.

Para ler as mensagens, basta aplicar um gás específico, que reage com os nanocristais, tornando-os detectáveis.

A técnica, embora provavelmente não seja prática o suficiente para ser usada pelos agentes secretos, tem um potencial muito mais imediato e valioso - os nanocristais criados são muito mais puros do que aqueles criados pelas ferramentas utilizadas pela indústria eletrônica, que lida diariamente com o silício.

Crescimento de nanocristais

Hoje, feixes de elétrons são utilizados pela indústria para depositar nanocristais sobre uma superfície. Na indústria de semicondutores, por exemplo, a tecnologia é utilizada para reparar defeitos nas máscaras litográficas usadas para criar circuitos integrados. "É um negócio multimilionário", diz Marbach.

Tradicionalmente, isto é feito dirigindo feixes de elétrons diretamente para moléculas como o pentacarbonil de ferro, forçando-as a se decompor em nanocristais de ferro, que grudam na superfície.

Embora essa técnica permita o crescimento controlado de nanocristais, explica Marbach, o processo quimicamente agressivo pode elevar os níveis de impurezas de carbono e oxigênio no interior dos cristais de ferro a até 60 por cento.

Tinta invisível

Para resolver o problema, Marbach e seus colegas usaram um feixe de elétrons para remover íons de oxigênio de uma pastilha de óxido de silício, deixando recortes nanoscópicos na superfície. O processo não deixa praticamente nenhum vestígio visível.

Esses recortes, ou "dentes", como os pesquisadores os chamam, facilitam as reações químicas, permitindo que uma mensagem secreta seja escrita sobre a pastilha de silício usando o feixe de elétrons.

Mais tarde, a mensagem pode ser revelada dirigindo um fluxo do gás pentacarbonil de ferro sobre a superfície. O gás reage com os recortes para formar monóxido de carbono, deixando nanocristais de ferro - sólidos e reflexivos - fixos sobre a superfície.

A vantagem é que, com a nova técnica, os cristais têm uma pureza de 95% de ferro. Os pesquisadores esperam que a técnica seja utilizada de forma imediata pela indústria.

USP cria ponto de acesso à internet alimentado por energia solar

Pesquisadores do Laboratório de Sistemas Integráveis (LSI) da Escola Politécnica (Poli) da USP criaram o protótipo de um sistema de comunicação sem fio em malha alimentado por energia solar.

Pesquisadores do Laboratório de Sistemas Integráveis (LSI) da Escola Politécnica (Poli) da USP criaram o protótipo de um sistema de comunicação sem fio em malha alimentado por energia solar.Conhecido como Wi-fi Solar, o equipamento permite o acesso a internet sem fio para dispositivos móveis em áreas ao ar livre. O sistema, em fase de testes, apresenta menores custos de instalação e o emprego da energia solar reduz despesas com eletricidade.

Wi-fi Solar

O Wi-fi Solar possui quatro módulos: comunicação (roteador), fotovoltaico (painel solar), armazenamento (baterias) e controle de energia.

"O roteador cria uma malha de comunicação sem fio, com várias rotas, entre outros módulos de comunicação da rede e fornece cobertura Wi-Fi para dispositivos móveis e portáteis no raio de alcance do sinal transmitido por cada módulo de comunicação", conta o engenheiro Rafael Herrero Alonso, responsável pelo projeto. "O módulo fotovoltaico gera eletricidade em corrente contínua ao sistema a partir da transformação direta da luz em energia elétrica."

Baterias recarregáveis garantem a operação do sistema em períodos sem irradiação solar.

"Em sistemas autônomos é necessário acumular energia, para compensar as diferenças existentes entre produção e utilização ao longo do tempo", explica o engenheiro. "O armazenamento obriga a utilização de um módulo de controle de energia adequado, que faça a gestão do processo de carga, a proteger e garantir uma elevada confiabilidade e um maior tempo de vida útil para as baterias."

Rede de baixo custo

Atualmente, dois Sistemas Wi-Fi Solar estão instalados em postes de iluminação na Cidade Universitária (Zona Oeste de São Paulo).

"Ambos operam no mínimo 8 horas por dia. Sendo caracterizado por um sistema autônomo, não precisa de manutenção e interação humana", conta o engenheiro. "Além disso, mais de 50 pessoas se conectam a rede implementada com os sistemas Wi-Fi Solar diariamente e transferem em torno de 1 gigabyte de informação."

Entre as principais vantagens do sistema, Alonso aponta a eliminação da infraestrutura de cabos elétricos para a instalação, e a redução de custos com o projeto da rede sem fio, mão-de-obra para instalação elétrica e do próprio custo da eletricidade, devido à utilização de energia solar renovável.

"Também é possível diminuir os custos com cabeamento estruturado para acesso a internet, fazer a instalação e o início do funcionamento do sistema em menos tempo", acrescenta, "além de reduzir gastos com manutenção e mão-de-obra operacional com técnicos no local."

Parceria com empresas

O engenheiro ressalta que o Wi-fi Solar é independente de infraestrutura cabeada. "Desta forma, as economias de custos podem chegar a 40% em relação à instalação de um infraestrutura de redes sem fio tradicional para ambientes externo", aponta. "Em resumo, o sistema permite cobrir grandes áreas ao ar livre com rapidez, facilidade e menor custo, representando assim, um sistema confiável e economicamente viável."

A pesquisa, realizada no Núcleo de Engenharia de Mídias (NEM) do LSI, teve a colaboração dos professores Marcelo Knorich Zuffo e Roseli de Deus Lopes, da Poli, e do engenheiro Hilel Becher, gerente do NEM.

"Nosso objetivo é transferir a tecnologia para ser transformada em produto por uma empresa parceira, que dará continuidade na industrialização e comercialização", planeja Alonso. A empresa Heliodinâmica disponibilizou os módulos de armazenamento e fotovoltaicos usados no desenvolvimento do estudo.

Sistemas similares ao desenvolvido na USP já estão disponíveis comercialmente no exterior.

Criado nanotecido de proteína que pode ser usado no coração

Construídos inteiramente a partir de materiais biológicos - proteínas - os tecidos artificiais poderão ter uso direto na medicina, repondo tecidos naturais de forma mais segura e sem risco de rejeição.

Nanotecido biológico

Na natureza, as células e os tecidos organizam-se para formar uma matriz de fibras de proteína que, em última instância, determina a sua estrutura e a sua função - como a elasticidade da pele e a capacidade de contração dos tecidos do coração.

"Até hoje tem sido muito difícil replicar essa matriz extracelular utilizando materiais sintéticos," explica o bioengenheiro Adam W. Feinberg. "Mas nós imaginamos que, se as células podem construir esta matriz na superfície de suas membranas, talvez nós pudéssemos construi-la nós mesmos em uma outra superfície."

Foi justamente isso o que Feinberg e seus colegas fizeram. Eles desenvolveram uma matriz que se estrutura sozinha sobre uma superfície termossensível. A composição de proteínas da matriz pode ser ajustada para gerar tecidos com propriedades específicas.

Para recolher o nanotecido, basta alterar a temperatura da superfície onde ele se forma - o material solta-se como se fosse uma folha de papel.

Tecido para remendar o coração

Segundo os pesquisadores, a nova tecnologia poderá ser usada para regenerar o coração e outros tecidos do corpo humano, assim como para fabricar tecidos extremamente fortes e elásticos, com apenas alguns nanômetros de espessura, para várias outras aplicações.

Os métodos atuais para regenerar tecidos biológicos normalmente envolvem o uso de polímeros sintéticos para criar um suporte, uma espécie de andaime, onde o tecido se desenvolve.

Mas esta abordagem pode causar efeitos colaterais conforme o polímero começa a se degradar.

Por outro lado, o nanotecido de proteína é feito das mesmas proteínas que os tecidos naturais e, portanto, o corpo pode descartar qualquer porção do material que deixe de ser necessário, sem gerar efeitos colaterais.

Os testes iniciais permitiram a criação de fibras de músculos cardíacos semelhantes às dos músculos papilares, o que poderá levar a novas estratégias de reparo e de regeneração do coração.

Tecidos de alto desempenho

Os tecidos de alto desempenho são outra aplicação potencial para esta tecnologia.

Alterando o tipo de proteína utilizada na matriz, os pesquisadores podem manipular a quantidade de fios na malha, a orientação das fibras e outras propriedades, de forma a criar tecidos com propriedades novas e com desempenho muito superior aos tecidos sintéticos atuais.

Hoje, uma borracha pode ser esticada em média de 500 a 600 por cento, mas os nanotecidos de proteínas podem ser esticados em até 1.500 por cento.

Nanocristais criam células solares de alta eficiência

A descoberta, segundo eles, abre a possibilidade de construir células solares com eficiência de duas vezes a três vezes maior do que as atuais, que raramente superam os 20%.

Os elétrons capturados são aqueles que normalmente escapam do circuito da célula solar e se perdem no ambiente na forma de calor.

Elétrons quentes

Na maioria das células solares atuais, os raios do Sol incidem sobre a camada superior das células, normalmente feita de silício cristalino.

O problema é que muitos elétrons no silício absorvem quantidades excessivas da energia solar e irradiam essa energia para fora da célula solar, na forma de calor, antes que ela possa ser aproveitada.

Uma primeira abordagem para aproveitar essa energia consiste na transferência desses "elétrons quentes", tirando-os do semicondutor e levando-os para um fio, ou circuito elétrico, antes que eles percam energia.

Mas os esforços para extrair esses elétrons dos semicondutores tradicionais de silício ainda não tiveram sucesso.

Nanocristais

No entanto, quando esses semicondutores são construídos na forma de estruturas extremamente pequenas, medindo poucos nanômetros, eles formam os chamados pontos quânticos, nanocristais que possuem propriedades diferentes do silício cristalino normal.

"A teoria diz que os pontos quânticos devem retardar a perda de energia na forma de calor," conta William Tisdale, que realizou os experimentos deste novo estudo. "A grande questão para nós era saber se poderíamos também acelerar a extração e a transferência dos elétrons quentes o suficiente para agarrá-los antes que eles resfriassem."

Tisdale e seus colegas demonstraram que pontos quânticos feitos de um outro semicondutor, o seleneto de chumbo, em vez de silício, são capazes de capturar os elétrons ainda "quentes".

A seguir, os elétrons foram direcionados para uma camada de dióxido de titânio, um outro material semicondutor barato e largamente utilizado na indústria. O dióxido de titânio funciona como um fio para levar os elétrons para o circuito elétrico, elevando a potência de saída do circuito.

Células solares de pontos quânticos

Extrapolando os resultados do rendimento verificado no experimento, os cientistas calculam que é possível construir células solares de pontos quânticos com uma eficiência de 66%, praticamente três vezes mais do que as células solares disponíveis comercialmente.

"Este é um resultado muito promissor," disse Tisdale. "Nós demonstramos que você pode arrancar os elétrons quentes muito rapidamente - antes que eles percam sua energia."

O trabalho, contudo, ainda está no início. Agora os cientistas precisam construir células solares reais, usando os pontos quânticos de seleneto de chumbo e verificar cuidadosamente seu funcionamento, eventualmente escolhendo outros materiais.

O uso do dióxido de titânio também precisará ser revisto ou otimizado. Embora ele capture os elétrons quentes, os elétrons perdem parte de sua energia no próprio material. Eventualmente uma nova arquitetura de construção das células solares possa resolver o problema.

De qualquer forma, os resultados deixaram os cientistas animados. "Eu me sinto confortável em dizer que a energia solar está para se tornar um grande componente da nossa oferta energética no futuro," disse Eray Aydil, coordenador do estudo.

Astrônomos detectam super tempestade em exoplaneta

As observações de elevada precisão de monóxido de carbono mostram que este gás se desloca em alta velocidade numa corrente que vai do lado diurno, muito quente, do planeta para o lado noturno, mais frio.

As observações forneceram outro detalhe completamente inédito - a medição da velocidade orbital do próprio exoplaneta, permitindo assim uma determinação direta da sua massa.

"O HD209458b não é exatamente um local bom para quem sofre do coração. Ao estudar o gás venenoso de monóxido de carbono com grande precisão, descobrimos evidências de um super vento, que sopra a uma velocidade entre os 5.000 e os 10.000 km por hora," diz Ignas Snellen, que coordenou a equipe de astrônomos que fez a pesquisa.

Planeta sem rotação

O exoplaneta HD209458b tem cerca de 60% da massa de Júpiter, orbitando uma estrela parecida com o Sol, situada a cerca de 150 anos-luz de distância, na direção da constelação de Pégaso.

A uma distância da sua estrela de apenas uma vigésima parte da distância Sol-Terra, o planeta é intensamente aquecido pela sua estrela, apresentando na superfície uma temperatura de cerca de 1.000º Celsius no lado mais quente.

Como o planeta não tem rotação, tendo sempre o mesmo lado voltado para a estrela, esse lado é muito quente, enquanto o outro é muito mais frio. "Na Terra, grandes diferenças de temperatura levam inevitavelmente a ventos extremos e, como revelam nossas medições, a situação em HD209458b não é diferente," diz Simon Albrecht, outro membro da equipe.

Trânsito planetário

O HD209458b foi o primeiro exoplaneta a ser encontrado por meio de uma técnica conhecida como "trânsito": a cada 3,5 dias o planeta passa à frente da sua estrela, bloqueando uma pequena parte da radiação estelar durante um período de três horas.

Durante este evento, uma pequeníssima fração da radiação estelar é filtrada pela atmosfera do planeta deixando uma pequena marca.

Uma equipe de astrônomos da Universidade de Leiden, do Instituto Holandês para a Investigação Espacial (SRON) e do MIT, nos Estados Unidos, utilizou o Very Large Telescope, do Observatório Europeu do Sul (ESO) e o seu potente espectrógrafo CRICES para detectar e analisar estas impressões digitais muito tênues, observando o planeta durante cerca de cinco horas, à medida que este passava em frente à estrela.

"O CRICES é o único instrumento do mundo capaz de obter espectros tão precisos quanto o necessário para determinarmos a posição das riscas de monóxido de carbono com uma precisão de 1 para 100.000," diz Remco de Kok, outro membro da equipe. "Esta elevada precisão permitiu-nos medir pela primeira vez a velocidade do gás de monóxido de carbono utilizando o efeito Doppler."

Vida em outros pontos do Universo

Os astrônomos obtiveram ainda vários outros resultados inéditos. Por exemplo, eles mediram diretamente a velocidade do exoplaneta à medida que este orbita a sua estrela.

"Geralmente, a massa de um exoplaneta é determinada através de medições do movimento da estrela e assumindo o valor da massa da estrela, de acordo com a teoria. Mas, neste caso concreto, conseguimos medir o movimento do planeta e assim determinar a massa tanto da estrela como do planeta," diz o coautor Ernst de Mooij.

Os astrônomos mediram também, e pela primeira vez, a quantidade de carbono presente na atmosfera de um exoplaneta. "Parece que o H209458b é, na realidade, rico em carbono, como Júpiter e Saturno. Este fato poderá indicar que se formaram da mesma maneira," diz Snellen."

No futuro, os astrônomos poderão utilizar este tipo de observação para estudar as atmosferas de planetas do tipo terrestre, tentando assim determinar se existe vida em outros lugares do Universo.

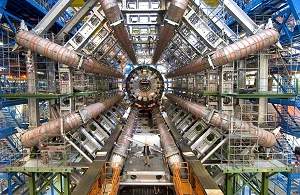

Cientistas tentam recriar som da "Partícula de Deus"

Cientistas simularam o som de partículas subatômicas produzidas no Grande Colisor de Hádrons (LHC), na Suíça.

Cientistas simularam o som de partículas subatômicas produzidas no Grande Colisor de Hádrons (LHC), na Suíça.O objetivo é facilitar a identificação da chamada "partícula de Deus" - o bóson de Higgs - cuja existência ainda não foi confirmada, mas que, segundo teorias, daria massa a todas as outras.

A cientista Lily Asquith coordenou a equipe que desenvolveu o modelo que transforma dados do gigantesco experimento Atlas, no LHC, em sons.

O experimento mostra que "ouvir os dados" tem uma função prática, muito além de um significado poético. Carl Sagan explorou o tema em seu livro Contato, em que a cientista prefere "ouvir" as transmissões vindas do espaço do que confiar nas análises precisas feitas pelos computadores.

"Se a energia estiver perto de você, você ouve um som grave, e se estiver mais longe, mais agudo", disse Asquith.

Colisões de prótons

O colisor é um projeto bilionário construído na fronteira entre a França e a Suíça para tentar responder algumas perguntas fundamentais para a física.

O experimento acontece em um túnel circular de 27 quilômetros de comprimento, repleto de imãs que "conduzem" prótons pelo imenso anel.

Em certos pontos do trajeto, os feixes de prótons mudam de trajetória e se chocam em quatro experimentos, que são minuciosamente monitorados pelos cientistas.

É nessas colisões que os estudiosos esperam encontrar novas partículas subatômicas, como o bóson de Higgs, que ajudariam a entender a origem do Universo.

Sonificação

Atlas é um dos quatro experimentos do colisor. Um instrumento batizado de calorímetro é usado para medir energia e é composto de sete camadas concêntricas.

Cada uma dessas camadas é representada por um tom diferente, dependendo da quantidade de energia contida nele.

O processo de transformar dados científicos em sons é chamado sonificação. Até o momento, a equipe de Asquith havia criado diversas simulações baseadas em previsões do que aconteceria durante as colisões no LHC.

Só agora eles começaram a utilizar dados de experimentos reais.

Sons de dados

"Quando você ouve as sonificações, na realidade, o que você está ouvindo são dados. Elas são fiéis aos dados e dão informações sobre os dados que não seriam possíveis de se obter de qualquer outra maneira", disse Archer Endrich, um desenvolvedor de software que trabalha no projeto.

Pela sonificação, os cientistas esperam poder identificar diferenças sutis para detectar novas partículas.

Um compositor envolvido com o projeto, Richard Dobson, destacou ter ficado impressionado com a musicalidade das colisões.

"É possível ouvir estruturas claras nos sons, quase como se tivessem sido compostas. Cada uma parece contar uma pequena história. São tão dinâmicas e mudam o tempo todo, que se parecem muito com as composições contemporâneas", disse o músico.

Fenda pode criar ilha gigante na África

A conclusão é de um grupo de cientistas britânicos que vêm monitorando mudanças geológicas na região de Afar, na Etiópia.

Fenda na África

Segundo descreveram os cientistas durante uma conferência da Royal Society, de Londres, uma fenda de 60 quilômetros de comprimento se abriu a região em 2005 e vem crescendo desde então.

Um monitoramento num período de apenas dez dias verificou a expansão da fenda em oito metros, segundo o sismólogo James Hammond, da Universidade de Bristol, um dos coordenadores do estudo.

Os pesquisadores dizem que o processo acabará dividindo a África em dois, transformando parte da Etiópia e da Somália em uma grande ilha no Oceano Índico.

Abaixo do nível do mar

A fenda começou a aparecer em 2005, após a erupção do vulcão Dabbahu, na região de Afar. O local, apesar de ainda não ter água, está localizado abaixo do nível do mar.

Os sismólogos dizem que estão presenciando um processo que normalmente só ocorre debaixo dos oceanos.

"Partes de Afar estão abaixo do nível do mar, e o oceano está separado por apenas uma faixa de 20 metros de terra do território da Eritreia", afirmou Hammond à BBC.

"Então essa terra cederá eventualmente, o mar entrará e começará a criar esse novo oceano", disse o cientista.

Segundo ele, com o tempo esse oceano crescerá até separar de vez a região do chamado "Chifre da África" do restante do continente, criando assim "uma África menor e uma ilha muito grande no Oceano Índico".

quinta-feira, 24 de junho de 2010

É Notícia: Kennedy Alencar entrevista Plínio de Arruda

Tela sensível ao toque é construída com grafeno

Esta é a primeira vez que se demonstra a capacidade técnica de fabricação de folhas de grafeno de grandes dimensões, superando os 70 centímetros quadrados.

O feito é um marco na história da tecnologia, trazendo o material do laboratório para a aplicação prática apenas seis anos depois da descoberta do grafeno - veja mais em Grafeno produzido industrialmente vira padrão de referência da eletrônica.

Tela sensível ao toque

Por ser o material de carbono mais fino possível, com apenas um átomo de espessura, o grafeno é ideal para a construção de eletrodos transparentes, necessários para as telas sensíveis ao toque.

A equipe da Universidade de Sungkyunkwan, liderada por Jong-Hyun Ahn e Byung Hee Hong, fabricou a camada de grafeno sobre uma folha de cobre utilizando uma técnica chamada CVD (chemical vapour deposition: deposição de vapor químico).